Mistral AI发布旗舰语言模型Mistral Large 2,1230亿参数

Mistral AI隆重推出了其旗舰语言模型的最新版本——Mistral Large 2,该版本在代码生成、数学处理及多语言能力上实现了显著飞跃。这款拥有1230亿参数的强大模型,配备了128,000个令牌的超大上下文窗口,旨在向业界顶尖的性能与效率发起挑战。

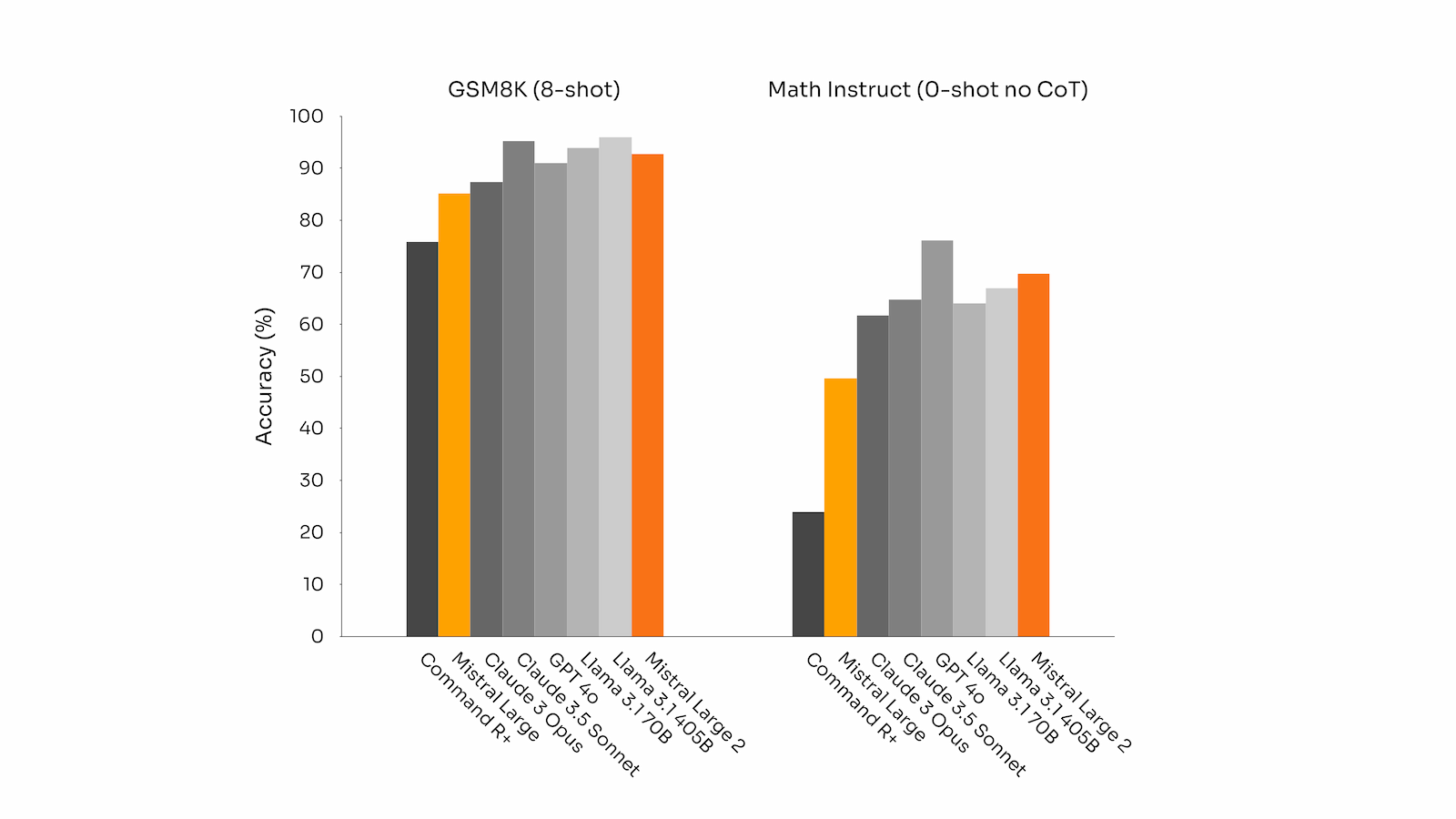

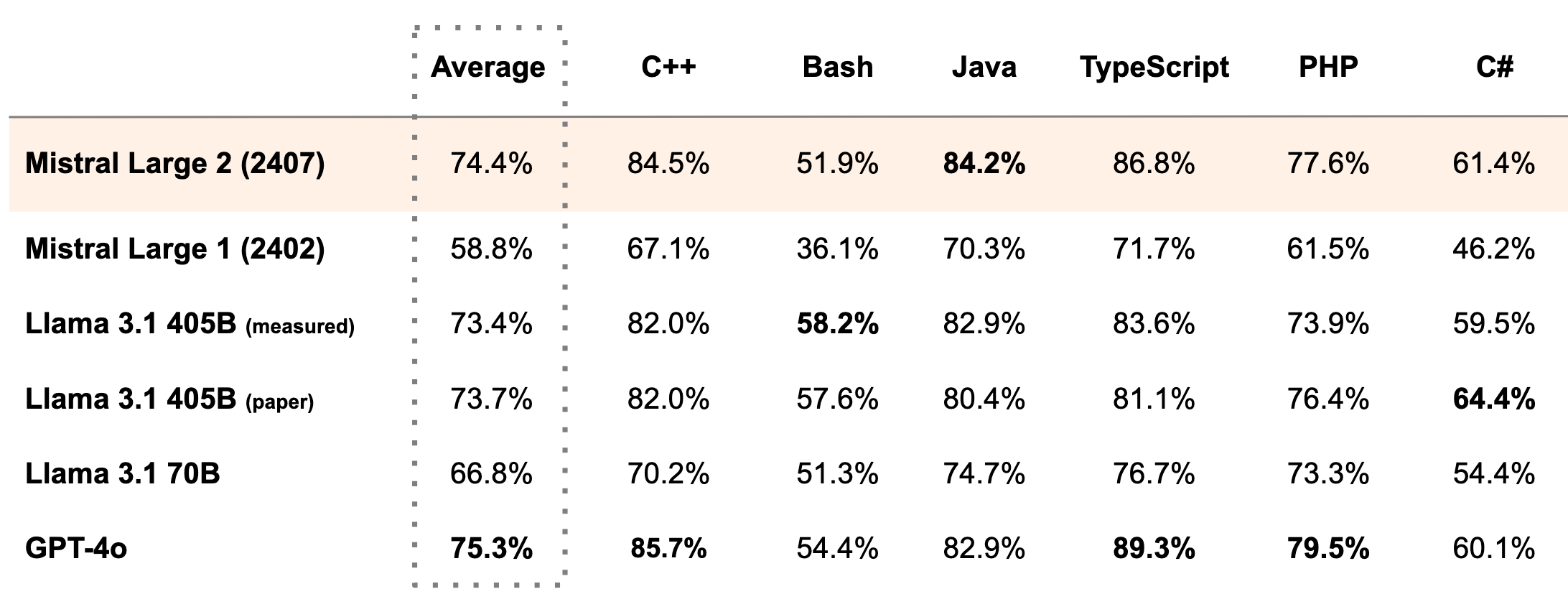

在多项基准测试中,Mistral Large 2展现了非凡实力。特别是在HumanEval和MultiPL-E等代码生成挑战中,它不仅超越了Meta新发布的Llama 3.1 405B,还紧随GPT-4之后,名列前茅。而在数学领域,尤其是在无需额外训练或推理链的MATH基准测试中,Mistral Large 2同样紧追GPT-4o,表现卓越。

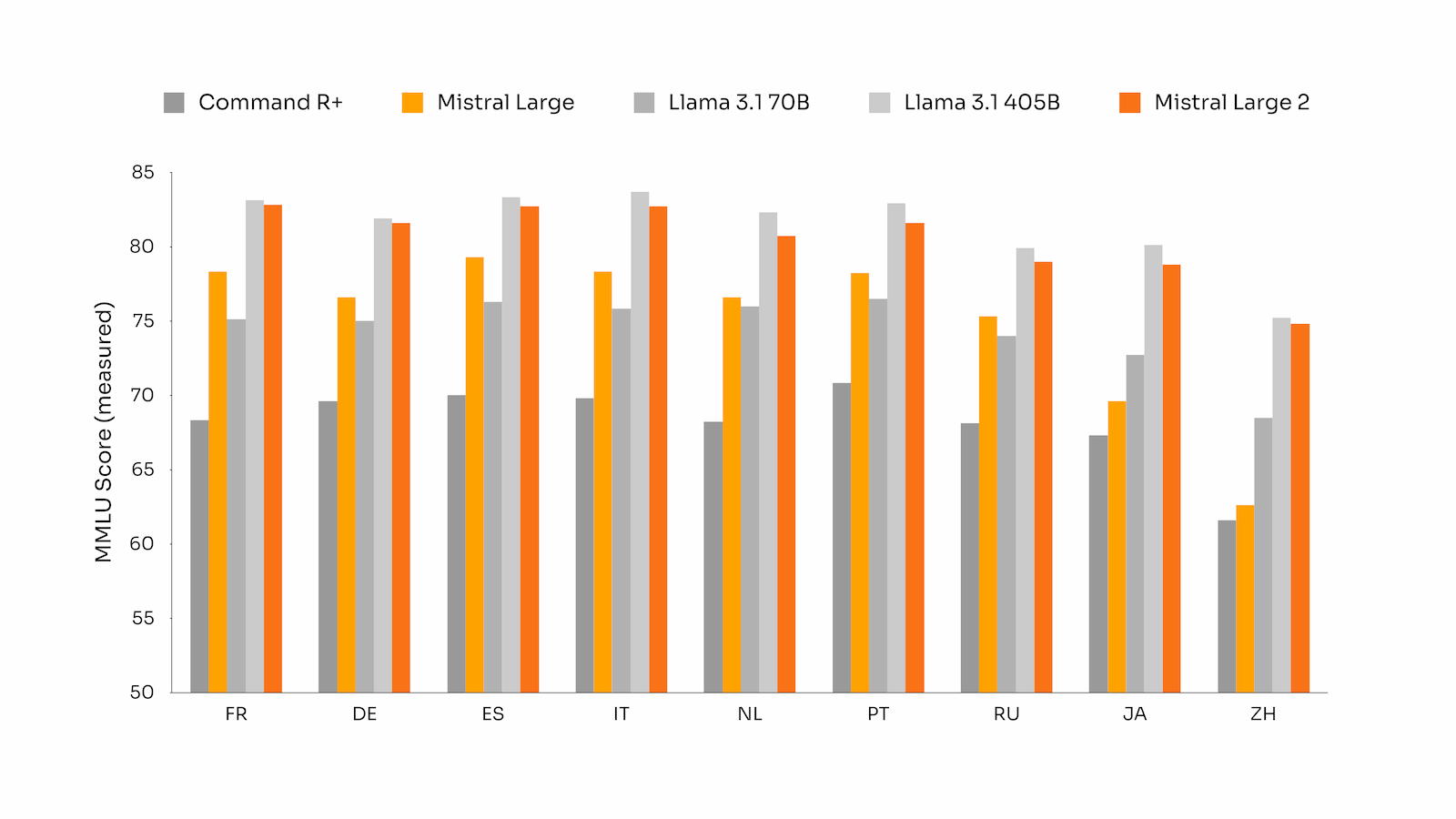

此外,Mistral Large 2的多语言能力也实现了质的飞跃。在覆盖九种语言的多语言MMLU基准测试中,它不仅平均成绩远超Llama 3.1 70B基准,还与Llama 3 405B平分秋色,展现了强大的跨语言理解和应用能力。

尽管拥有庞大的体量,Mistral AI却巧妙地将其设计为单节点推理模型,着重优化长上下文应用场景的吞吐量,确保高效运行。目前,该模型已通过la Plateforme平台向公众开放,并发布了适用于HuggingFace的instruct模型权重,供研究人员深入探索。

Mistral AI的首席执行官Arthur Mensch自豪地表示:“Mistral Large 2在评估指标上树立了性能与成本比的新标杆。”他强调,该模型的预训练版本在MMLU测试中达到了84.0%的准确率,为开放模型领域的性能/成本帕累托前沿设立了新的里程碑。

得益于在源代码上的广泛训练以及Mistral AI在代码模型领域的深厚积累,Mistral Large 2在编码任务中的表现与GPT-4、Claude 3 Opus及Llama 3 405B等业界佼佼者并驾齐驱。

同时,Mistral AI还致力于提升模型的推理精度并减少生成内容的幻觉现象,这一努力在数学基准测试中的改进表现中得到了验证。

更令人瞩目的是,Mistral Large 2擅长遵循复杂指令、处理精确任务以及进行长时间的多轮对话,为用户提供了更加流畅、智能的交互体验。

Mistral Large 2紧随Llama 3.1的发布步伐,进一步加剧了AI语言模型领域的竞争态势。其在代码生成、数学处理及多语言支持等方面的出色表现,使其成为科研及潜在商业应用的理想选择。

随着AI模型在规模和能力上的不断攀升,Mistral AI对效率和单节点推理的重视,彰显了在追求极致性能的同时,也不忘考虑实际部署与应用平衡的明智之举。