百度在AI领域取得重大突破,语言模型可靠性与可信度显著提升

百度近期在人工智能领域宣布了一项里程碑式的创新成果,这一突破有望重塑语言模型的可靠性与可信度标准。百度的研究团队成功开发出一种创新的“自我推理”框架,该框架赋予AI系统以批判性思维,使其能够自主评估并验证自身知识与决策过程的准确性。

在权威学术平台arXiv上发布的研究论文中,百度详细阐述了这一革命性方法,它直击AI领域的一个长期痛点:确保大型语言模型的事实准确性。尽管这些强大的系统能够生成高度逼真的文本,却常因“幻觉”现象——即自信地输出错误信息——而饱受诟病。

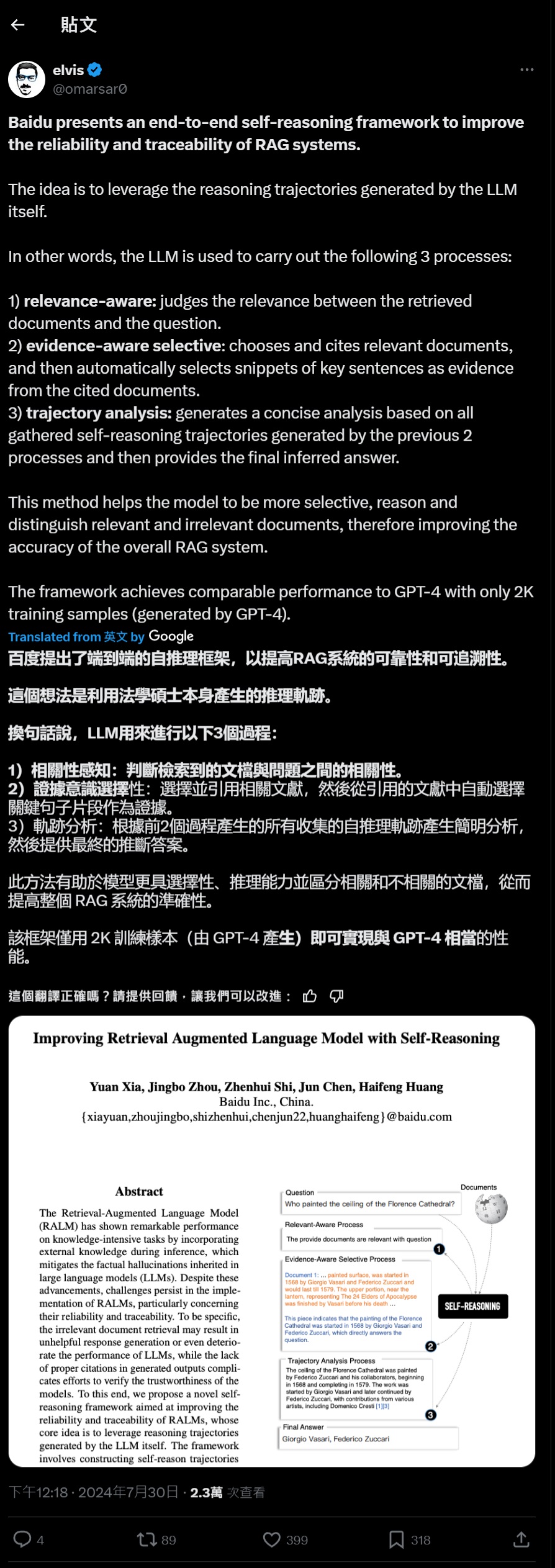

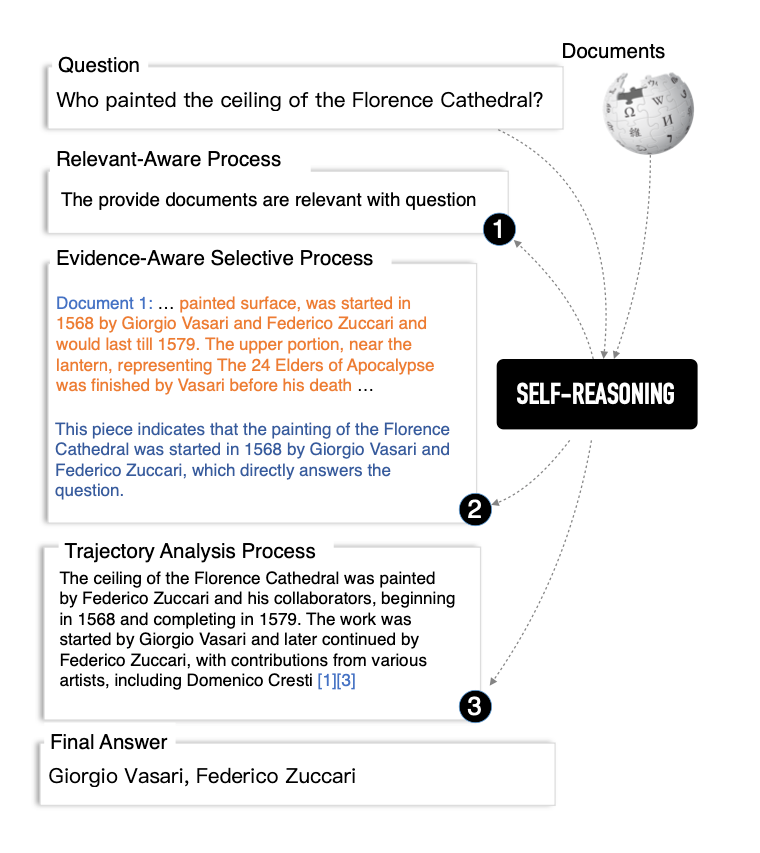

百度研究团队表示:“我们提出的自我推理框架,旨在提升检索增强语言模型(RARMs)的可靠性和可追溯性,其核心在于利用LLM(大型语言模型)自身生成的推理轨迹。该框架包含三个核心过程:相关性感知、证据感知的选择以及轨迹分析。”

这一创新不仅解决了AI生成信息的能力问题,更向前迈进了一步,实现了对信息的验证与具体化。通过内置的自我推理机制,AI系统不再局限于简单的信息检索与生成,而是能够像人类专家一样,批判性地审视并评估自己的输出。

这一发展标志着AI模型正由单一的预测工具向复杂的推理系统转变,自我推理能力的引入不仅提升了AI的准确性,还大大增强了其决策过程的透明度,为建立公众对AI系统的信任奠定了坚实基础。

在具体实施上,百度的自我推理AI首先评估检索信息的相关性,随后像人类研究员一样选择并引用相关证据,最后通过深入分析推理路径,生成既有充分依据又准确无误的答案。这种多步骤、严谨的推理流程,使得AI在信息处理上更加谨慎,同时也为其输出提供了清晰可追溯的依据。

在多个权威问答和事实验证数据集上的测试中,百度的自我推理系统均表现出色,甚至在某些情况下,仅使用少量训练样本(如2000个样本)就达到了与顶尖AI模型GPT-4相媲美的性能水平。这一成就不仅彰显了百度技术的先进性,也为AI产业的民主化进程注入了新的动力。

传统上,训练高效的语言模型需要庞大的数据集和昂贵的计算资源,而百度的这一方法则打破了这一限制,证明了利用有限资源同样可以开发出高性能的AI系统。这一发现有望降低AI研发的门槛,促进更多小型企业和研究机构参与到AI创新中来,从而推动整个行业的健康发展。

然而,值得注意的是,尽管自我推理框架取得了显著进展,但AI系统仍难以完全达到人类的细微理解和上下文意识水平。它们仍然是基于大数据和模式识别的工具,而非真正具备理解和意识的实体。

展望未来,百度的这一创新成果在需要高度信任和问责性的领域具有广阔的应用前景,如金融咨询、医疗诊断等。随着AI系统越来越多地融入各行业的关键决策过程,提升其可靠性和可解释性将成为不可回避的课题。百度的自我推理框架为解决这一问题提供了宝贵的思路,并为未来更可信、更可靠的AI系统铺平了道路。

面对AI技术的飞速发展,如何在追求技术创新的同时确保系统的质量、可靠性和伦理合规性,将是未来AI研究必须面对的重要挑战。百度的这一突破不仅是对当前技术瓶颈的一次有力突破,更是对未来AI发展方向的一次深刻思考。