大型语言模型的使用和增强

介绍

随着 LLM 的潜力和用途变得越来越重要,围绕 LLM 开发应用程序和工具的热潮也随之兴起。这显然也是一个巨大的商机,而且这个商机还在不断扩大。

然而,在尝试利用 LLM和构建以 LLMs 为中心的应用程序时,人们发现 LLM存在漏洞。因此,必须建立解决方案和框架来解决这些漏洞,并支持 LLM 和生成式人工智能应用开发。

LLM的局限性

无记忆

LLM 无法记住之前的提示,这限制了它们在需要保留状态的应用中的使用。在对话中保持上下文也是如此。因此,必须采用 “少量学习 ”的方法,总结对话历史,并在总结中注入提示。

此外,还必须采用播种(seeding)等方法,即针对特定输入复制特定回复。

随机回复

LLM 对相同的提示会给出不同的答案。温度等参数可以限制这种可变性,但它仍然是一种固有特性。

在某些对话式用户界面中,这可能是个不错的选择,因为在这些界面中,我们需要模拟人类的活泼程度。

过时信息

LLM 无法访问当前数据或了解当前时间,只能依靠训练数据。因此就有了 RAG 的概念,每次推理都要检索与上下文高度相关的信息。

大尺寸

LLM 需要昂贵的 GPU 资源来进行训练和服务,从而导致潜在的延迟问题。

因此,小型语言模型应运而生;除了知识密集型之外,小型语言模型具有大型语言模型的所有特点。知识密集型特征已被 ICL 和 RAG 所取代。因此,小语言模型是大多数解决方案的理想选择。

幻觉

LLM 可以生成非常可信、简洁和连贯的答案,但也可以生成与事实不符的答案。

这些局限性,尤其是幻觉,引发了人们的兴趣,并导致了各种提示工程和 LLM 增强策略的出现。

大型语言模型(LLM)中的幻觉

在大型语言模型中,幻觉是指生成无意义或不真实的内容。

这一现象已经引起了广泛关注,《自然语言生成中的幻觉调查》一文对此进行了特别强调。

根据最近的一项研究,幻觉可分为以下几类:

内在幻觉

这些幻觉引入了与事实不符或逻辑不一致的内容,直接与原始材料相冲突。

外在幻觉

这些幻觉与原始资料无法核对,涉及推测或不符合事实的元素。

LLM 在不同的数据集(包括互联网、书籍和维基百科)上进行训练,并根据概率模型生成文本,而无需对真相有固有的理解。

指导调整和人类反馈强化学习(RLHF)等技术旨在生成更符合事实的输出结果,但其固有的概率性质仍是一个挑战。

提示工程: CoT

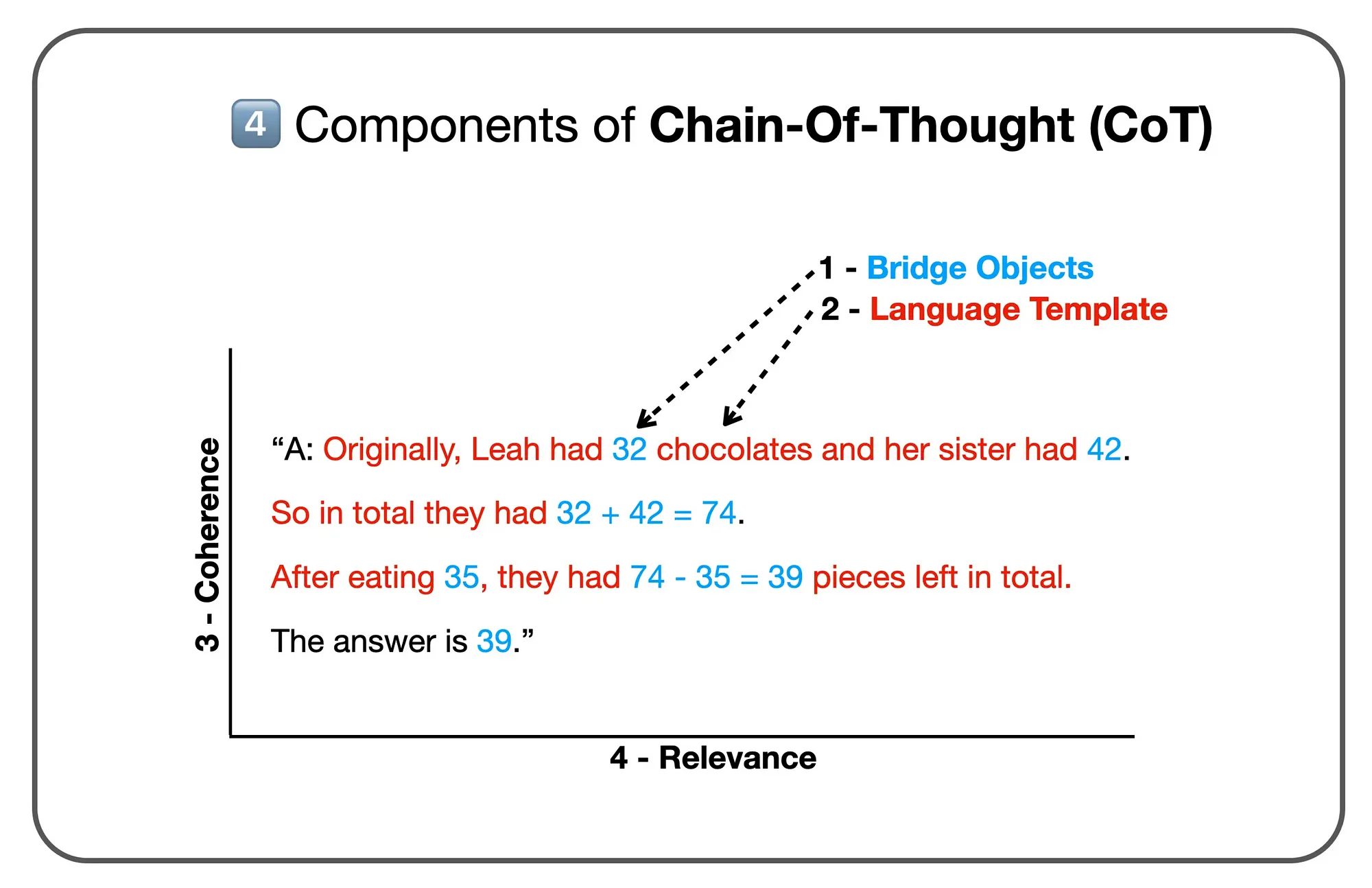

思维链(CoT)提示将 LLM 的隐性推理过程显性化。

通过分解解决问题所需的推理步骤,该模型可获得更符合逻辑和推理的输出结果,尤其是在需要复杂问题解决或更深入理解简单信息检索或模式识别之外的任务中。

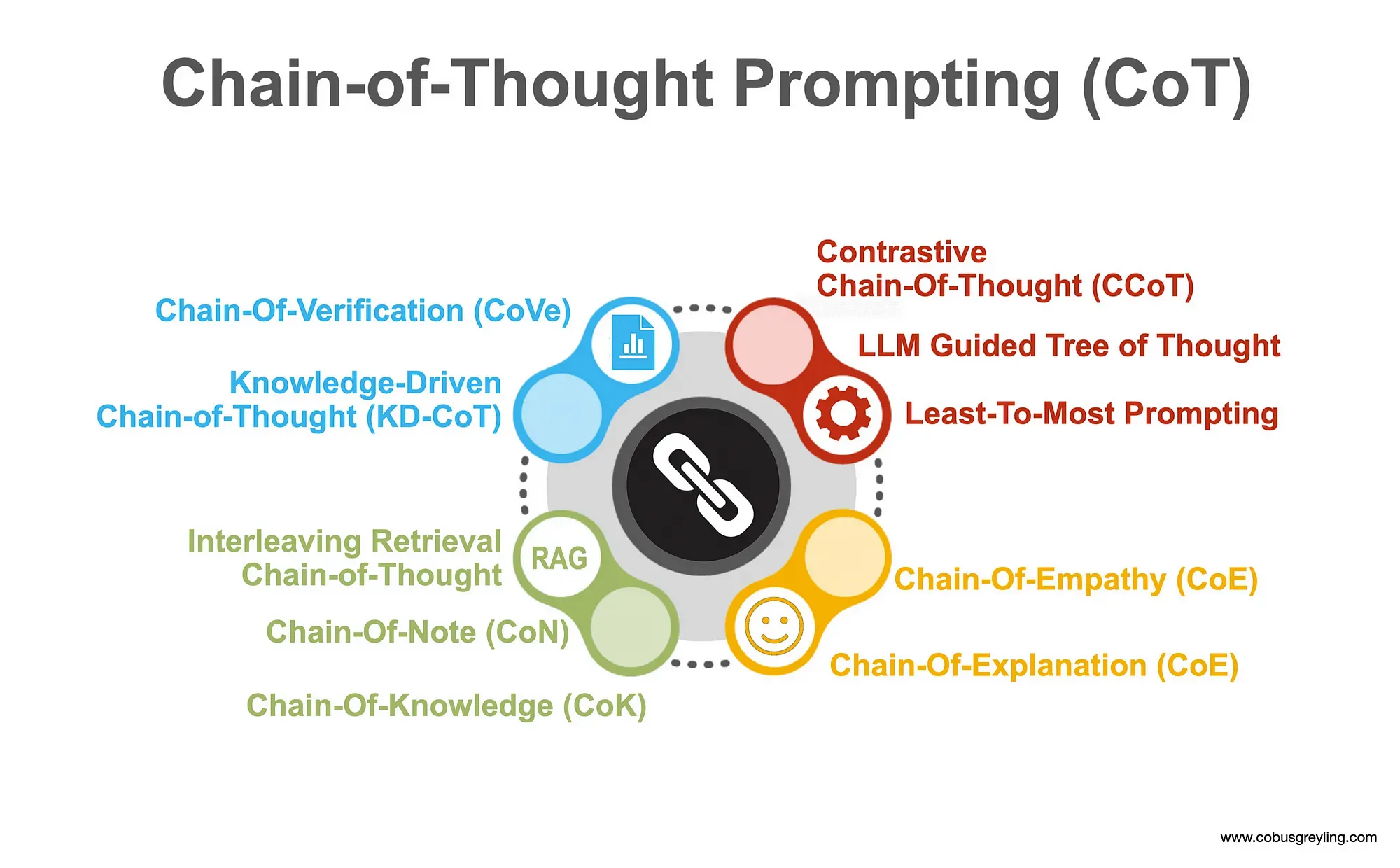

Chain-Of-X 现象

最近,各种 “Chain-Of-X ”实现方法展示了大型语言模型(LLM)如何将复杂问题分解为一系列中间步骤。这一概念被称为 Chain-Of-X,源于思维链(CoT)提示。

CoT 提示通过将较大的问题分解成较小的步骤,反映了人类解决问题的方法。然后,LLM 会集中精力解决每个子问题,从而降低忽略关键细节或做出错误假设的可能性。事实证明,这种 Chain-Of-X 方法在与 LLM 交互时非常有效。

工具与人工智能代理

人工智能历史上对人工智能代理的概念进行了深入探讨。代理通常是一个自主实体,它能利用传感器感知环境,根据当前状态做出判断,并采取相应行动。

就 LLM 而言,代理指的是 LLM(增强型)的专门实例化,旨在自主执行特定任务。这些代理与用户和环境交互,根据输入和预期目标做出决策。基于 LLM 的代理可以访问和使用工具,并根据给定的输入做出决策,处理需要自主和决策的任务,而不仅仅是生成简单的响应。