测试时间训练 (TTT):序列建模的新方法

在人工智能(AI)和自然语言处理(NLP)领域,序列建模的重要性令人难以置信。它是我们日常使用的许多应用的基础,如语言翻译、文本摘要、聊天机器人,甚至代码生成。然而,目前流行的序列建模方法面临着一些巨大的挑战。

序列建模目前面临的挑战

要了解 TTT 为何如此重要,我们先来看看当前方法存在的问题:

递归神经网络 (RNN):

- 好: 它们速度快、效率高,使用的计算机功率较低。

- 坏: 它们在处理长序列时很吃力,经常会遗忘文本前面的重要信息。

变压器:

- 好: 他们善于理解长篇文章,并发现不同部分之间的联系。

- 坏: 它们需要大量的计算机处理能力,尤其是在处理超长文本时,速度会很慢,成本也很高。

测试时间训练(TTT)介绍

TTT 是一个巧妙的新思路,旨在解决这些问题。下面是它的工作原理:

- 隐藏状态成为学习者: 在传统模型中,“隐藏状态 ”只是一堆传递信息的数字。在 TTT 中,隐藏状态实际上是一个可以学习和改进的小型人工智能模型。正如论文所述,“我们的关键想法是利用自监督学习将历史上下文 x₁、......、xₜ 压缩成一个隐藏状态 sₜ,方法是将上下文作为一个未标记的数据集,而将状态作为一个模型”。作者阐述道:“具体来说,隐藏状态 sₜ 现在等同于 Wₜ,即模型 f 的权重,可以是线性模型、小型神经网络或其他任何东西”。

- 在使用中学习: 通常情况下,人工智能模型只需训练一次,使用后就不会再改变。TTT 模型在使用过程中会不断学习和适应,帮助它们更好地理解每篇特定文本。研究人员解释说:“即使在测试时,我们的新层仍会针对每个输入序列训练不同的权重序列 W₁、......、Wₜ”。这种动态适应是 TTT 的主要特点。

- 自我监督学习: 隐藏状态中的小型人工智能模型通过尝试预测部分输入文本来进行学习。这被称为 “自我监督学习”,因为它不需要人类提供正确答案。论文将其描述为 “在某种自我监督损失 ℓ 上的梯度下降步骤”。他们提供了这样一个损失函数的例子:ℓ(W; xₜ) = ∥f(x̃ₜ; W) - xₜ∥² 其中 x̃ₜ 是输入 xₜ 的损坏版本。

TTT 如何工作?

研究人员创建了两个版本的 TTT:

线性 TTT:

- 使用简单的线性模型作为隐藏状态。

- 它非常快速高效。

TTT-MLP:

- 使用稍复杂的模型,称为多层感知器(MLP)。

- 它能理解更复杂的模式,但需要更强的计算机能力。

这两个版本都是在阅读文本时不断更新对文本的理解。本文详细解释了其工作原理,包括更新规则和输出规则的数学公式:

更新规则:

Wₜ = Wₜ₋₁ - η∇ℓ(Wₜ₋₁; xₜ)

输出规则:

zₜ = f(xₜ; Wₜ)

还引入了一种 “迷你批 TTT ”方法来提高效率: “我们使用 Gₜ = ∇ℓ(W'ₜ;xₜ),其中 t' = t - mod(t, b) 是上一个迷你批次的最后一个时间步长(或 0 表示第一个迷你批次),因此我们可以一次并行处理 b 个梯度计算"。

TTT 为何重要?

TTT 具有几个重要优势:

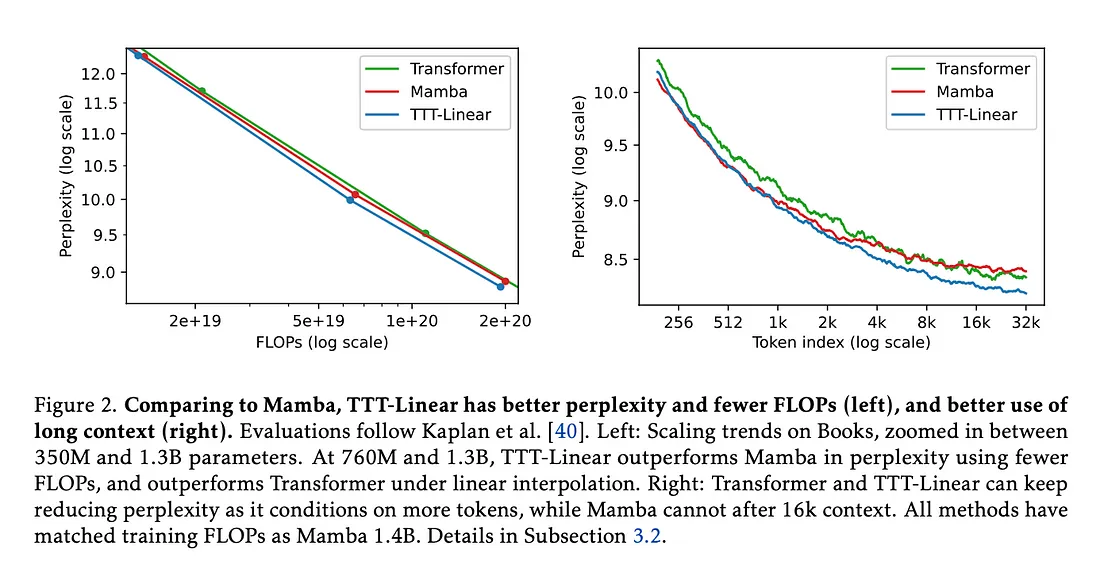

- 更好地处理长文本: RNN 往往会遗忘长文本的早期部分,而 TTT 则不同,它能在整个文本中不断提高理解能力。图中显示 “Transformer 和 TTT-Linear 可以随着对更多标记的处理而不断降低困惑度,而 Mamba 在处理了 16k 上下文后就无法做到这一点了”。他们进一步解释说:“TTT 层可以利用其较大的隐藏状态来压缩长语境中的更多信息,在这一点上,TTT-MLP 优于 TTT-Linear,而 TTT-Linear 又优于 Mamba”。

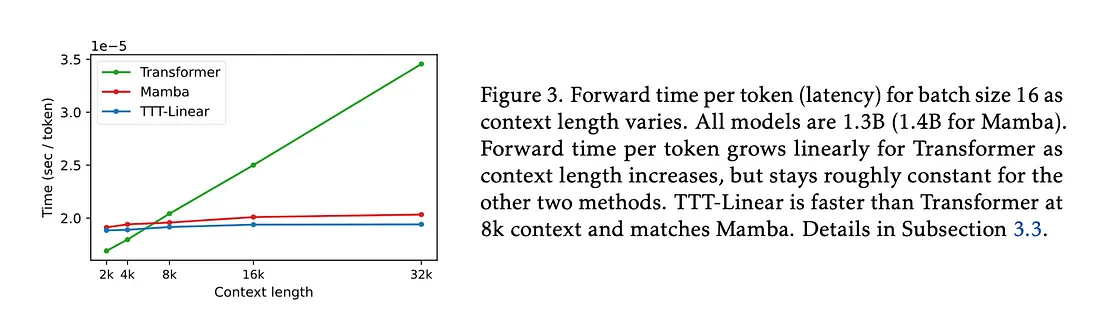

- 比 Transformers 更快: 对于长文本,TTT-Linear 的运行速度实际上比 Transformer 更快。论文在图中显示,“在 8k 上下文中,TTT-Linear 比 Transformer 更快,在壁钟时间内可与 Mamba 相媲美”。他们通过 “迷你批 TTT 和双重形式 ”等技术实现了这一效率。

- 灵活多变: TTT 方法不仅适用于文本。研究人员认为,它可以用于其他涉及序列的任务,如理解视频或控制机器人。他们提到了 “机器人操纵和运动 ”等潜在应用,并建议 “对于视频任务和具身代理(其上下文长度可以轻松扩展到数百万或数十亿),F 可以是一个卷积神经网络”。

TTT 效果如何?

研究人员对 TTT 进行了全面测试:

- 他们建立了拥有多达 13 亿个参数的大型人工智能模型。

- 他们将 TTT 与性能最佳的 Transformer 模型和一种名为 Mamba 的新型 RNN 进行了比较。

- 他们使用了不同的数据集,包括 “The Pile ”和 “Books3”。

- 他们测试了不同长度的文本,从短段落到超长文档。

结果令人印象深刻:

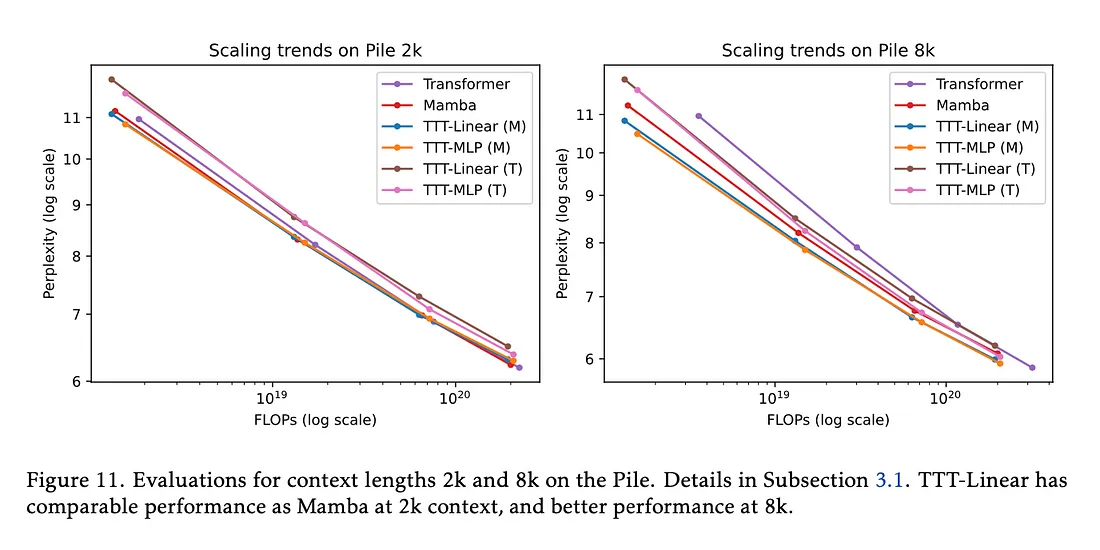

- 在大多数测试中,TTT 的表现与 Transformers 和 Mamba 一样好,甚至更好。如图 11 所示,在 2k 上下文中,“TTT-Linear (M)、Mamba 和 Transformer 的性能相当”,而在 8k 上下文中,“TTT-Linear (M) 和 TTT-MLP (M) 的性能明显优于 Mamba”。

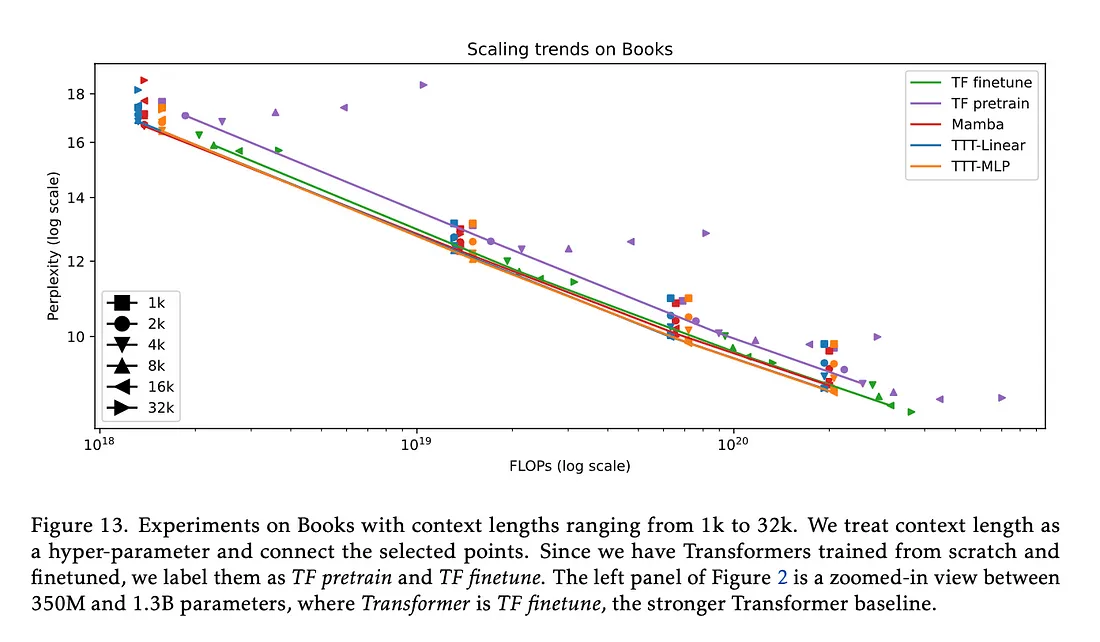

TTT 在处理长文本时表现尤为出色,明显优于 Mamba。图 13 展示了在不同长度的上下文中的优势。并指出:“我们在本文中观察到的一个显著现象是,随着上下文长度的增加,TTT 层相对于 Mamba 层的优势也在扩大”。

虽然 TTT 显示出很大的前景,但仍存在一些挑战。总之,测试时间训练(TTT)代表着人工智能在理解和处理文本方面向前迈进了一大步。通过让人工智能模型在使用过程中学习和适应,TTT 为创建更智能、更高效的人工智能系统开辟了新的可能性。

随着这一领域研究的不断深入,我们可以期待更强大的人工智能系统来处理复杂的任务,并为我们如何让机器更好地理解和处理人类语言提供有价值的见解。TTT 方法很可能是开启下一代人工智能模型的钥匙,这些模型能够真正以高效和有效的方式理解和处理冗长、复杂的信息序列。