Meta推出MoMa架构,提升多模态AI效率

多模态人工智能(AI)聚焦于开发能够处理和整合多种数据类型(如文本和图像)的模型。这些模型在回答视觉问题和为图像生成描述性文本方面至关重要,突显了AI理解和互动复杂世界的能力。整合不同模态的信息使AI能够更有效地执行复杂任务,在研究和实际应用中展示了显著的前景。

多模态AI的一个主要挑战是优化模型效率。传统方法使用模态特定的编码器或解码器来融合信息,往往限制了模型有效整合不同数据类型信息的能力。这种限制导致计算需求增加,性能效率降低。研究人员一直在努力开发新的架构,从一开始就无缝整合文本和图像数据,以提高模型在处理多模态输入时的性能和效率。

现有的处理混合模态数据的方法包括预处理和分别编码文本和图像数据的架构,然后再整合它们。这些方法虽然功能齐全,但计算密集,可能只部分利用了早期数据融合的潜力。模态的分离往往导致低效率,无法充分捕捉不同数据类型之间复杂的关系。因此,需要创新的解决方案来克服这些挑战,以实现更好的性能。

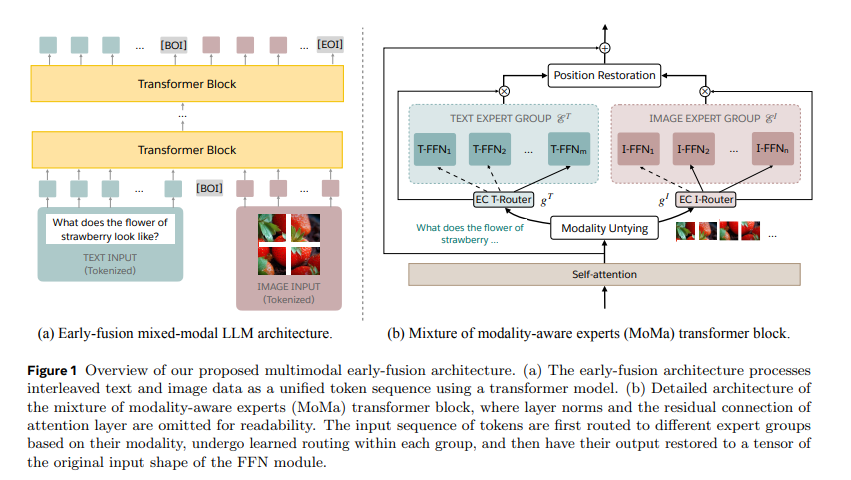

为应对这些挑战,Meta的研究人员推出了MoMa,一种新颖的模态感知混合专家(MoE)架构,旨在预训练混合模态的早期融合语言模型。MoMa通过将专家模块划分为模态特定的组来处理任意顺序的文本和图像。每个组专门处理指定的令牌,利用学习到的路由在每个组内保持语义感知的适应性。这种架构显著提高了预训练效率,实验证明取得了显著收益。Meta团队的研究展示了MoMa在推进混合模态语言模型方面的潜力。

MoMa背后的技术结合了混合专家(MoE)和混合深度(MoD)技术。在MoE中,令牌在每一层被路由到一组前馈块(专家)中。这些专家被分为文本特定和图像特定的组,允许专门的处理路径。这种方法称为模态感知稀疏性,增强了模型捕捉每种模态特定特征的能力,同时通过共享的自我注意机制保持跨模态整合。此外,MoD允许令牌在某些层选择性地跳过计算,进一步优化处理效率。

对MoMa的性能进行了广泛评估,显示出在效率和效果上有显著提升。在1万亿令牌训练预算下,包含4个文本专家和4个图像专家的MoMa 1.4B模型相比于稠密基线,整体每秒浮点操作(FLOPs)减少了3.7倍。具体来说,文本处理减少了2.6倍,图像处理减少了5.2倍。当与MoD结合时,整体FLOPs节省提高到4.2倍,文本处理改善了3.4倍,图像处理改善了5.3倍。这些结果突出显现了MoMa在增强混合模态早期融合语言模型预训练效率方面的潜力。

MoMa的创新架构代表了多模态AI的重大进步。通过整合模态特定的专家和高级路由技术,研究人员开发了一个资源效率更高的AI模型,在多样任务中保持了高性能。此项创新解决了关键的计算效率问题,为开发更具能力和资源效率的多模态AI系统铺平了道路。团队的工作展示了未来研究在此基础上构建的潜力,探索更复杂的路由机制,并将方法扩展到更多的模态和任务。

总之,由Meta研究人员开发的MoMa架构为多模态AI中的计算挑战提供了一个有前途的解决方案。该方法利用模态感知混合专家和混合深度技术,在保持强大性能的同时实现了显著的效率提升。这一突破为下一代多模态AI模型铺平了道路,使其能够更有效、更高效地处理和整合多种数据类型,提升AI理解和互动复杂多模态世界的能力。