Meta推出SAM 2:革新图像与视频分割技术

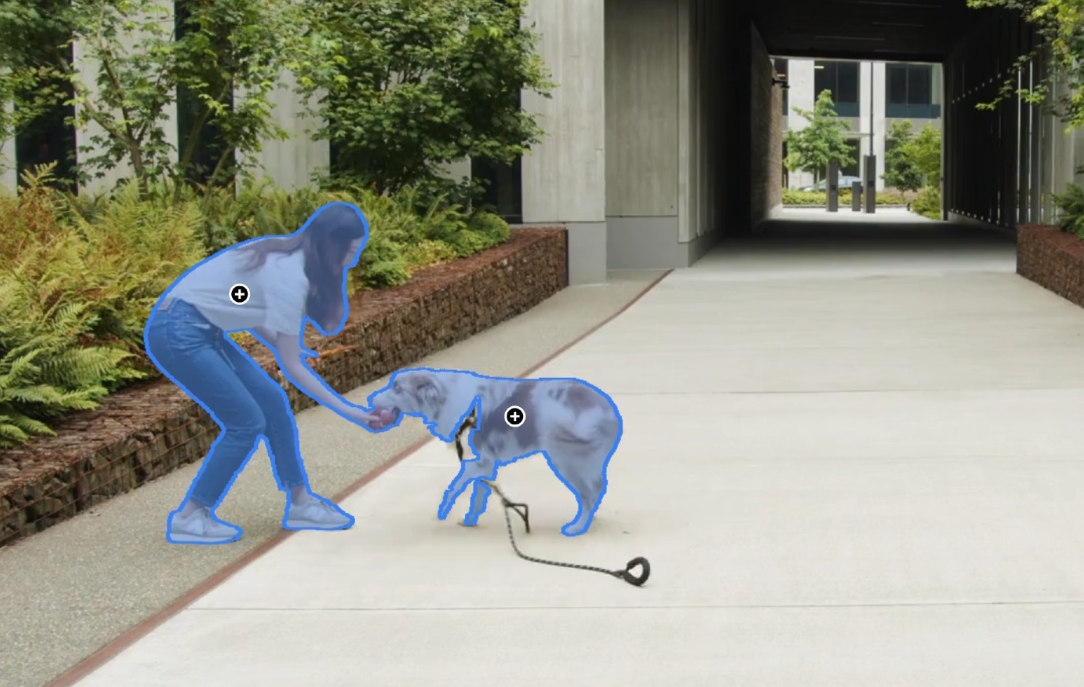

Meta近期发布了其最新力作——Segment Anything Model 2(简称SAM 2),尽管在当前大型语言模型(LLMs)的热潮中,SAM 2的发布相对低调,但其在图像与视频分割领域的实时处理能力及其广泛的应用潜力不容忽视。

SAM 2作为SAM的升级版,不仅继承了前代模型在图像分割中的高效与灵活性,更在视频分割领域实现了重大突破。该模型无需特定领域的数据微调,即可在多种场景下实现精准的对象分割。尤为重要的是,Meta公开了SAM 2的模型权重、源代码及训练数据集,这一举措极大地促进了科研界与开发社区在该领域的探索与进步。

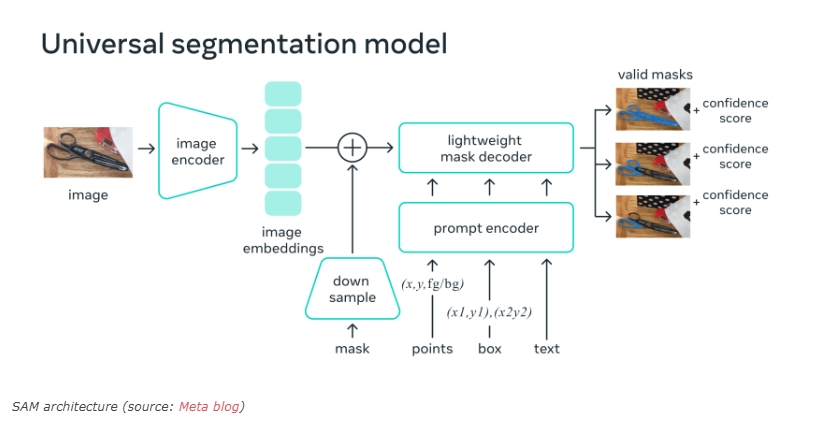

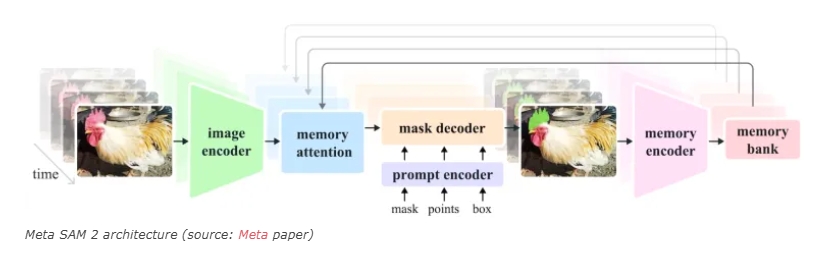

从SAM到SAM 2,对象分割技术经历了显著进化。传统方法受限于技术门槛高、标注数据需求大及训练资源昂贵等问题,而SAM通过学习图像与提示间的编码匹配,实现了快速精准的对象分割。SAM 2在此基础上,针对视频中的复杂场景进行了优化,引入了内存机制,确保模型在连续帧间保持对象识别的一致性,从而解决了视频分割中的诸多难题。

Meta为支持SAM 2的训练与应用,构建了SA-V数据集,该数据集包含来自全球47个国家的约51,000个视频片段,覆盖了多种复杂场景。通过模型迭代与人工校正相结合的方式,Meta不仅提升了SAM 2的性能,还显著提高了自动标注的效率。

在实际应用中,SAM 2在多个零样本视频数据集上的表现均优于以往方法,且具备接近实时的推理能力,每秒可处理约44帧图像。其开源特性使得开发者与研究人员能够免费使用,并探索其在特定领域的应用潜力。例如,在自动驾驶、机器人技术及工业生产线等领域,SAM 2有望发挥重要作用,提升数据处理与对象识别的效率与准确性。

此外,SAM 2的发布也引发了关于视觉语言模型(VLM)与对象分割模型结合应用的思考。未来,随着技术的不断发展,我们或许能看到更多基于SAM 2等模型的复杂应用,为人工智能领域带来更多创新与突破。