研究表明:生成式AI模型可能会随时间推移而“发疯”

来自莱斯大学和斯坦福大学的研究人员发表的一项新研究指出,如果人工智能引擎是根据机器生成的输入而非人类输入进行训练,那么生成式AI的质量可能会下降。本质上,如果AI模型以相互蚕食的方式相互学习,那么它可能会影响系统的长期质量。

生成式AI模型如何会“发疯”?

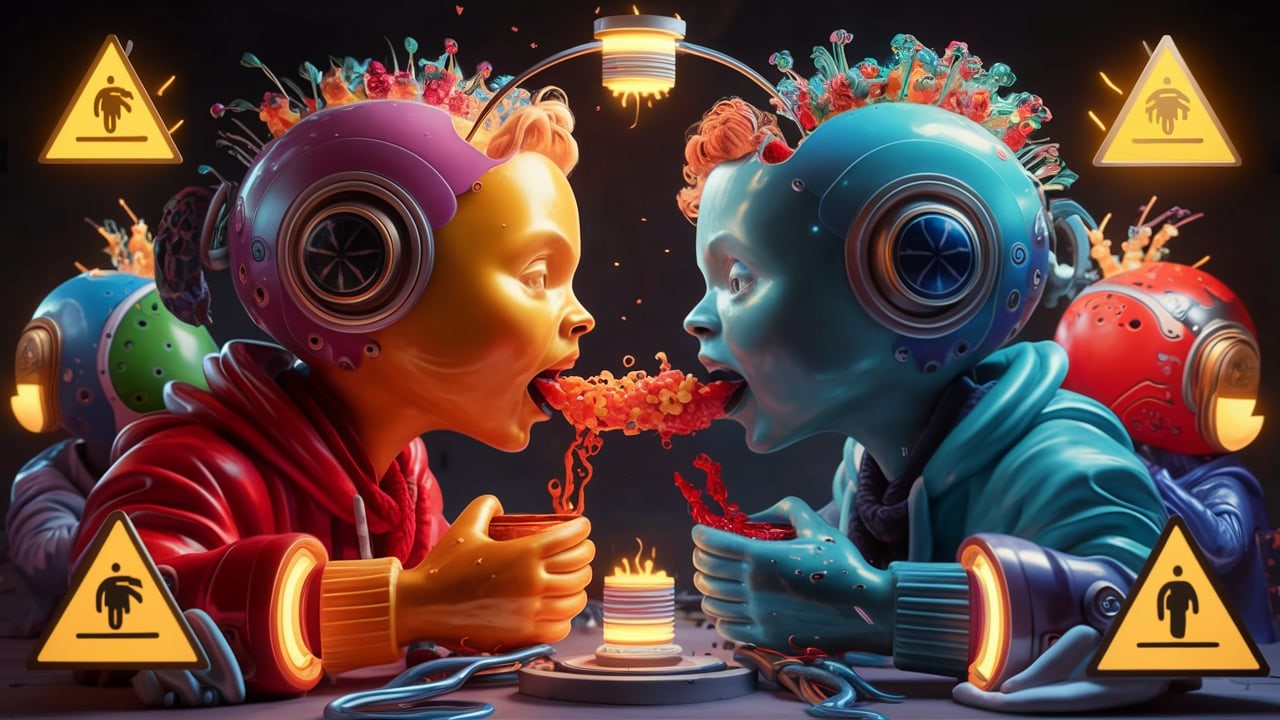

研究人员将这种效应称为“模型自噬紊乱”(Model Autophagy Disorder,简称MAD),并将其与疯牛病相提并论。疯牛病是一种发生在食用被其他牛只感染残骸的牛身上的神经性疾病。正如那些牛因为食用牛肉而受到影响一样,AI系统也会因为从其他系统获取信息而受到影响。

AI模型需要来自现实世界的新鲜数据才能有效地工作,无论是在质量还是多样性方面。未来AI模型可能会受到试图加快学习过程的人的影响,从而面临风险。

莱斯大学的计算机工程师理查德·巴拉纽克(Richard Baraniuk)告诉《科学警报》杂志:“一些后果显而易见:没有足够的新鲜真实数据,未来的生成式模型注定会陷入MAD状态。”

这些发现来自对视觉生成式AI模型的测试,该模型被训练在三种类型的数据上:全合成数据、合成与真实固定数据的混合,以及合成与真实新鲜数据的混合。在前两种情况下,模型的输出变得越来越有缺陷。

例如,计算机生成的人脸上有明显的痕迹,数字也变得越来越难以阅读。人脸也开始变得越来越相似,凸显了合成数据训练模型随着时间的推移而缺乏多样性。

“我们团队对这种反馈循环进行了大量研究,坏消息是,即使经过几代这样的训练,新模型也可能会变得无法修复地损坏,”巴拉纽克说。

虽然这项实验专注于图像生成,但它可以推断出具有深远的后果。随着AI在越来越多的系统中得到应用,研究人员警告说可能会出现“末日情景”。

“如果不加以控制,经过多代发展,MAD可能会破坏整个互联网的数据质量和多样性,”巴拉纽克说。“除此之外,似乎不可避免的是,即使在不久的将来,AI自噬也会产生迄今为止未曾见过的意外后果。”