TII推出Falcon Mamba 7B:革新性SSLM模型引领AI新纪元

技术创新研究所(TII)近期隆重推出了Falcon Mamba 7B,这是一款革命性的大型语言模型,其独特之处在于采用了状态空间语言模型(SSLM)架构。作为TII Falcon系列中的佼佼者,Falcon Mamba 7B摒弃了传统的Transformer设计模式,并经由国际知名平台Hugging Face的严格验证,被公认为当前表现最优异的开源SSLM模型。

状态空间语言模型,作为自然语言处理领域的新星,与主流的Transformer架构大相径庭。它巧妙地借鉴了控制理论中的先进技术来处理语言序列,展现出多项显著优势。这些模型在处理超长文本时游刃有余,且内存占用极低,无论面对多大的输入量,都能保持性能的稳定如一。

Falcon Mamba 7B在实际应用中充分展现了这些卓越特性。它能够生成长篇大论的文本内容,而无需额外增加内存负担,有效突破了传统语言模型在处理大量文本时的瓶颈。这一突破性的能力,预示着在处理大型文档分析、持续文本生成等应用场景中,将开启全新的可能性。

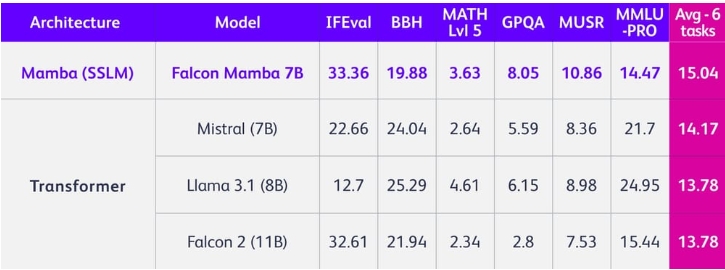

在多项基准测试中,Falcon Mamba 7B的表现力压群雄,包括Meta的Llama 3.1 8B和Mistral的7B等基于Transformer的知名模型。这一成绩有力证明了SSLM在大规模语言任务处理上的巨大潜力,相较于其Transformer同类,更显优势。

目前,Falcon Mamba 7B已正式登陆Hugging Face平台,向全球范围内的研究人员和开发者开放测试。用户不仅可以直接访问并测试该模型,还能通过平台提供的交互式体验区,深入探索其在各类语言任务中的强大能力。

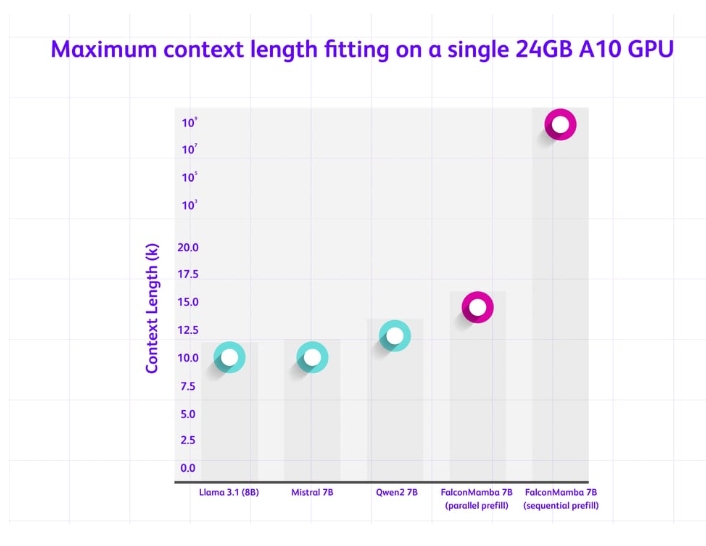

在标准GPU环境下的性能测试中,Falcon Mamba 7B同样展现出了非凡的效率。相比传统Transformer模型,它在处理长文本序列时,不仅速度不减,还能有效控制内存使用。例如,在配置有24GB内存的NVIDIA A10 GPU上,该模型在处理大规模文本输入时,表现出了惊人的效率与稳定性。

随着Falcon Mamba 7B的广泛应用,其对于自然语言处理领域的实际影响尚待全面评估。但无疑,这一模型的推出标志着语言模型研发领域的一次重大飞跃,有望为文本处理任务提供更加高效、强大的AI解决方案。

值得注意的是,阿布扎比TII推出的Falcon Mamba 7B也是全球人工智能创新合作的一个缩影。它展示了来自世界各地研究机构的共同努力与智慧结晶,共同推动着自然语言处理乃至整个人工智能领域的不断前行。随着技术的不断进步,我们有理由相信,像Falcon Mamba 7B这样的创新模型,将引领AI系统在理解和生成人类语言方面实现新的飞跃。