北京人工智能研究院推出Aquila2系列模型

大型语言模型(LLM)以其卓越的多任务处理能力,正引领着研究领域的深刻变革。然而,这类模型的训练过程却面临着计算资源消耗巨大、对静态数据集依赖性强以及难以快速适应数据变化等挑战。针对这些问题,北京人工智能研究院(BAAI)的语言基础模型与软件团队成功研发了Aquila2系列模型,为LLM的训练开辟了新的高效路径。

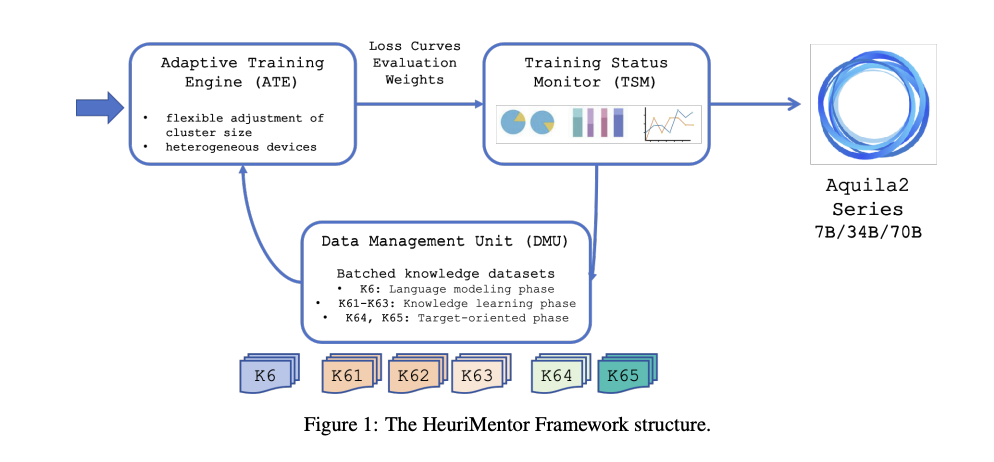

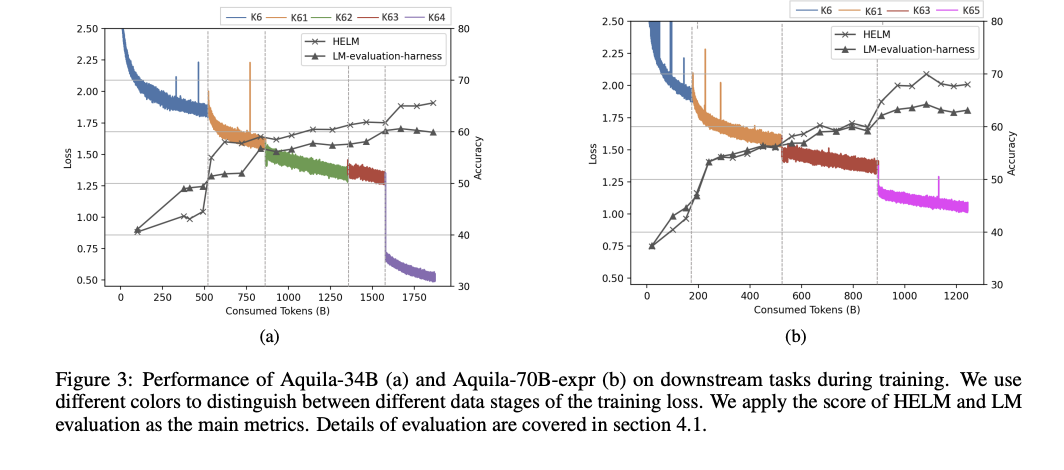

Aquila2系列模型,参数规模横跨70亿至700亿,采用了创新的HeuriMentor(HM)框架进行训练。该框架集成了自适应训练引擎(ATE)、训练状态监控器(TSM)和数据管理单元(DMU)三大核心组件,不仅显著增强了训练过程的可控性和灵活性,还实现了对数据分布的动态调整,从而大幅提升了训练效率和模型性能。

在模型设计上,Aquila2系列采用了精心挑选的10万词汇表,结合字节对编码(BPE)技术,确保了词汇的有效性和表达的丰富性。同时,模型训练数据均衡覆盖了英语和中文,依托Pile和WudaoCorpus等高质量数据集,为双语处理能力打下了坚实基础。此外,Aquila2还引入了分组查询注意力(GQA)机制和Rotary Position Embedding(RoPE)位置编码方法,进一步提升了推理效率和序列数据处理能力。

经过全面评估,Aquila2-34B模型在多个自然语言处理任务中展现出了卓越的性能,特别是在双语理解和类人理解能力方面表现尤为突出。与业界领先的Baichuan2、Qwen、LLaMA2和InternLM等模型相比,Aquila2-34B在多个数据集上均取得了优异成绩,证明了其强大的竞争力和广泛的应用潜力。

尤为值得一提的是,Aquila2系列模型的训练过程得益于HM框架的支持,实现了对数据分布的实时调整和优化,从而加速了模型收敛并提高了最终质量。这一创新不仅为LLM的训练提供了新的思路和方法,也为未来AI技术的发展奠定了坚实基础。