KGAST:从知识图谱到带注释的合成文本

在 ACL 2024 知识图谱和大型语言模型(KaLLM)研讨会上,有 14 篇论文被 “电梯演讲马拉松”(Elevator Pitch Marathon)采纳,展示了知识图谱和大型语言模型交叉领域的创新研究。并介绍了一种名为 KGAST 的新型框架,该框架利用知识图谱和大型语言模型为信息提取任务自动生成带注释的合成数据。该论文提出了一种创新方法来解决数据稀缺问题并提高模型性能,尤其是对于训练样本有限的类别。在这篇文章中,我们将详细探讨这一框架。

KGAST: 信息提取中的合成数据生成框架

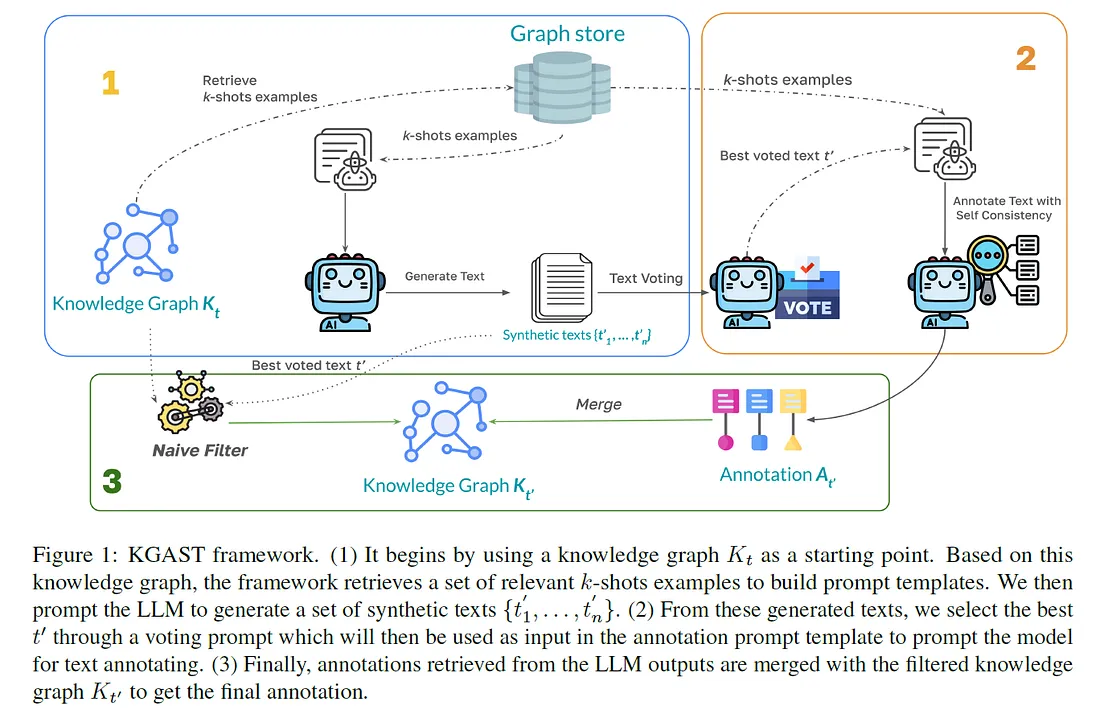

我们提出的为信息提取(IE)任务生成注释合成数据的方法是围绕利用大型语言模型(LLM)和知识图谱(KG)而构建的。该过程首先将任务定义为自然语言生成挑战。核心目标是创建与给定知识图谱紧密匹配的合成文本。最初,该方法从一组包含标注注释和关系的黄金标准文本开始。这些注释和关系是 KG 的子集。为了指导 LLM 生成合成文本,研究人员使用从原始文本中提取的 KG 构建了一个提示。该提示是 LLM 生成合成文本的基础,合成文本附有相应的注释和关系。然后对合成文本进行过滤,以确保只保留相关的 KG 三元组,即在生成的文本中同时存在头部和尾部实体。

提示构建过程对于准确引导 LLM 非常重要。提示分为几个部分,分别定义 LLM 的角色,提供与输入 KG 非常相似的黄金标准数据示例(k-shot 示例),以及以三元组列表的形式呈现测试输入。这些元素共同引导 LLM 生成一个连贯的合成文本,以反映预期的 KG。不过,生成的文本和注释有时可能不完整或不连贯,因为 LLM 可能无法包含所有输入的三元组,或者生成的文本包含无意义的短语或幻觉。

为了解决这些潜在问题,研究人员在他们的方法中加入了自一致性技术。这种方法包括生成多个版本的合成文本和注释,然后根据它们的创造性、一致性以及是否包含所有必要的输入三元组进行评估。根据这些标准选出最佳版本,确保最终合成文本和注释的高质量。在注释方面,多个生成版本中最一致的输出将被合并,以提高准确性。

例如,在一个英文例子中,原始文本描述了澳大利亚昆士兰州太平洋博览会购物中心的历史和特点,提到了主要租户和附近景点等具体细节。合成文本虽然保留了有关该地点和一些实体(如 Toys 'R' Us 和 Myer)的核心信息,但引入了一些变化和新的措辞,却忽略了原文中一些详细的历史背景。同样,在另一个关于第二次世界大战期间云雀部队的例子中,合成文本正确识别了关键人物和事件,但改变了叙事结构,省略了原文中的具体细节。

这些例子突出说明了合成文本是如何在引入新的语言变化的同时抓住幼稚园教育的精髓的。不过,这些例子也表明,在合成版本中,一些实体和细节可能会被添加或省略,这反映了在合成数据生成过程中平衡多样性和准确性的持续挑战。

该方法的最终结果是合成文本与 KG 一致,并附有准确、一致的注释。这种合成数据可用于训练或增强 IE 模型,尤其是在原始数据有限或不平衡的情况下。通过以这种方式制定任务并通过自一致性验证输出,该方法旨在生成高质量的合成数据,以补充或增强 NLP 任务中的现有训练数据集。

结论

KGAST 框架在为 IE 任务生成合成数据方面迈出了显著的一步。通过有效结合 KG 和 LLM,该方法解决了数据稀缺和模型在代表性不足的类别中的表现等关键难题。不过,虽然 KGAST 提供了一种稳健的方法,但目前还不能完全取代原始数据。