NVIDIA发布Mistral-NeMo-Minitron 8B:新一代高效大型语言模型

NVIDIA重磅推出了Mistral-NeMo-Minitron 8B,一款高度复杂且卓越的大型语言模型(LLM),延续了其在先进AI技术领域的不懈探索与卓越成就。此模型在多个基准测试中大放异彩,稳居同规模类别顶尖行列,并开放可访问,展现了其非凡实力。

Mistral-NeMo-Minitron 8B的诞生,源自对更大规模Mistral NeMo 12B模型的精妙改造——通过宽度剪枝技术精心雕琢而成。这一创新过程,如同匠人雕琢艺术品,巧妙地剔除了模型中相对不重要的部分,如神经元和注意力头,从而实现了模型的瘦身。随后,利用知识蒸馏的魔法,对被裁剪的模型进行再训练,不仅保留了原模型的精髓,还赋予了它更高效的运行能力,实现了大小与性能的完美平衡。

模型剪枝与蒸馏的奥秘,在于其精准的策略与细致的执行。剪枝,分为深度与宽度两种,而Mistral-NeMo-Minitron 8B巧妙地选择了宽度剪枝,确保了模型在缩小体积的同时,仍能保持强大的性能。随后,通过轻量级的知识蒸馏,将庞大教师模型的知识精髓注入到小巧的学生模型中,实现了性能与效率的双重飞跃。这一过程中,仅使用了3800亿个标记的数据集进行再训练,相较于原始Mistral NeMo 12B模型的数据需求,堪称高效节能。

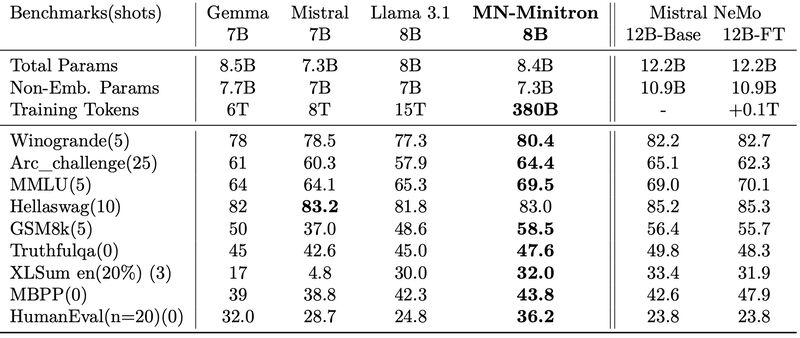

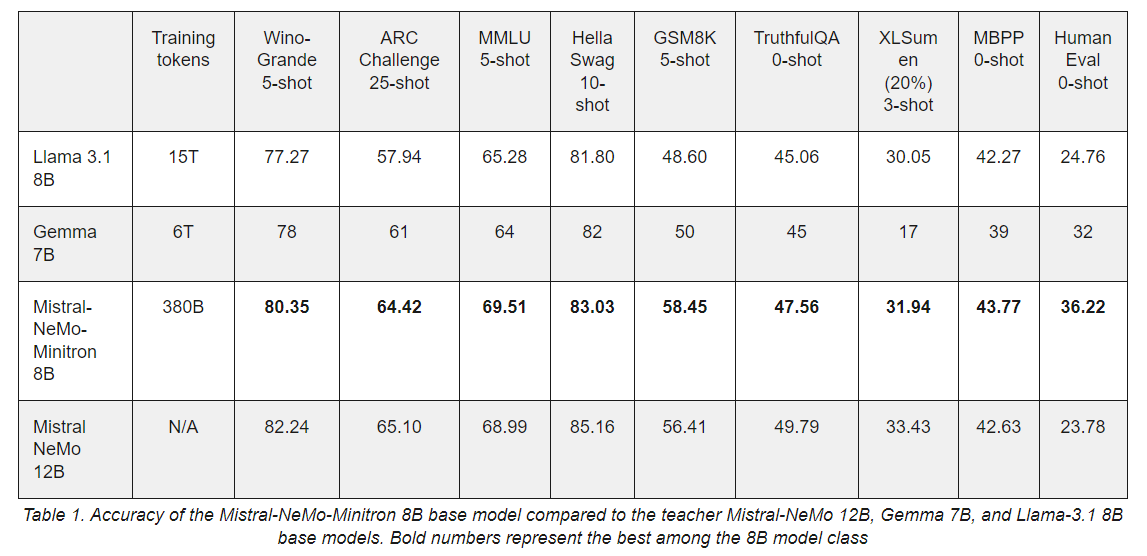

在基准测试的舞台上,Mistral-NeMo-Minitron 8B更是大放异彩。无论是在5-shot WinoGrande测试中的80.35分,还是在MMLU 5-shot和HellaSwag 10-shot测试中的出色表现,都彰显了其作为同类别中最准确模型之一的地位。与Mistral NeMo 12B、Llama 3.1 8B及Gemma 7B等模型相比,Mistral-NeMo-Minitron 8B在多个关键领域展现出了卓越的性能优势。

技术层面,Mistral-NeMo-Minitron 8B基于先进的Transformer解码器架构,采用4096的嵌入大小、32个注意力头以及分布在40个层中的11,520维MLP中间维度,并融入了分组查询注意力(GQA)和旋转位置嵌入(RoPE)等前沿技术,确保了模型在各种任务中的稳健性能。其训练数据集广泛覆盖法律、数学、科学、金融等多个领域,以及英文和多语种文本与代码,为模型的广泛应用奠定了坚实基础。

NVIDIA表示,Mistral-NeMo-Minitron 8B的发布仅是其通过剪枝与蒸馏技术探索更小、更高效模型征途的起点。公司将继续深化这一领域的研究,推动模型在准确性、高效性及实用性方面的不断进步,并将这些成果集成到NVIDIA NeMo框架中,为开发者提供更加强大的自然语言处理工具。

然而,Mistral-NeMo-Minitron 8B作为大型语言模型,同样面临着数据偏见和社会偏见的潜在风险。NVIDIA强调了对负责任AI开发的承诺,并呼吁用户在应用过程中充分考虑这些因素,共同推动AI技术的健康发展。

综上所述,NVIDIA凭借剪枝与蒸馏技术的精湛运用,成功推出了Mistral-NeMo-Minitron 8B这一里程碑式的模型,为自然语言处理领域树立了新的效率与性能标杆。随着技术的不断进步与应用的持续拓展,我们有理由相信,这一模型将在未来发挥更加重要的作用。