Meta的Transfusion模型使用单一架构处理文本和图像

能够同时处理文本和图像的多模态模型是人工智能领域的一个研究热点。然而,训练这些模型面临着一个独特的挑战:语言模型处理的是离散值(单词和标记),而图像生成模型则必须处理连续的像素值。

目前的多模态模型采用的技术降低了数据表示的质量。在最新的一篇研究论文中,来自Meta和美国南加州大学的科学家介绍了一种名为Transfusion的新技术,该技术使单个模型能够无缝地处理离散和连续模态。

多模态模型的挑战

当前解决多模态挑战的方法往往涉及不同的权衡。一些技术为语言和图像处理使用不同的架构,并经常单独预训练每个组件。这是LLaVA等模型采用的方法。这些模型在学习不同模态之间复杂交互方面存在困难,尤其是在处理图像和文本相互交织的文档时。

其他技术则将图像量化为离散值,有效地将它们转换成类似于文本的标记序列。这是Meta今年早些时候推出的Chameleon采用的方法。虽然这种方法允许使用语言模型进行图像处理,但它会导致连续像素值中包含的信息丢失。

周春婷(Chunting Zhou),Meta AI的高级研究科学家和该论文的合著者,之前曾参与Chameleon论文的研究工作。

“我们注意到,量化方法在图像表示方面创造了一个信息瓶颈,其中图像的离散表示被高度压缩,导致原始图像中的信息丢失,”她告诉VentureBeat。“与此同时,训练一个好的离散图像标记器也非常棘手。因此,我们提出了一个问题:‘在训练多模态模型与离散文本时,我们是否可以直接使用图像更自然的连续表示?’”

Transfusion:多模态学习的统一方法

“扩散模型和基于下一个标记预测的自回归模型分别是生成连续数据和离散数据的最佳方法,”周春婷说。“这启发我们开发一种新的多模态方法,该方法以自然和简单的方式结合了这两种方法的最佳优点。”

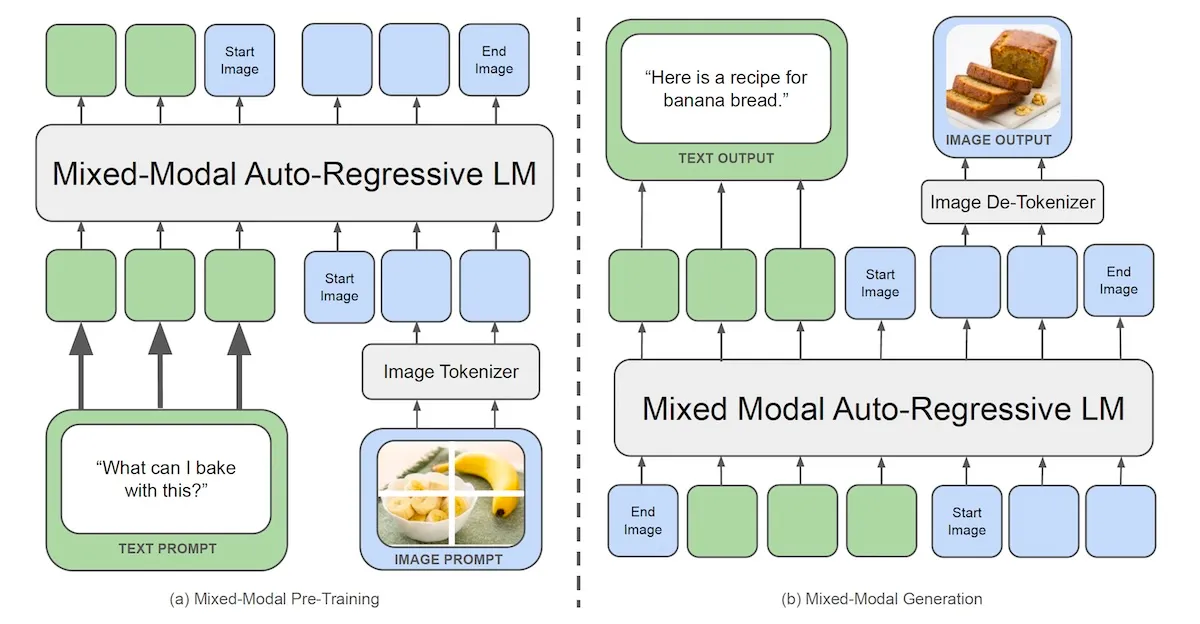

Transfusion是一种训练单个模型以处理离散和连续模态的方法,无需量化或单独的模块。Transfusion的核心思想是使用两个目标来训练一个单一模型:文本的语言建模和图像的扩散建模。

Transfusion将这两个目标结合起来,以训练一个能够处理和生成文本和图像的Transformer模型。在训练过程中,模型同时接触到文本和图像数据,并且语言建模和扩散的损失函数被同时应用。

“我们证明,通过训练一个单一的模型来同时预测离散文本标记和扩散连续图像,可以完全整合这两种模态而不会丢失信息,”研究人员写道。

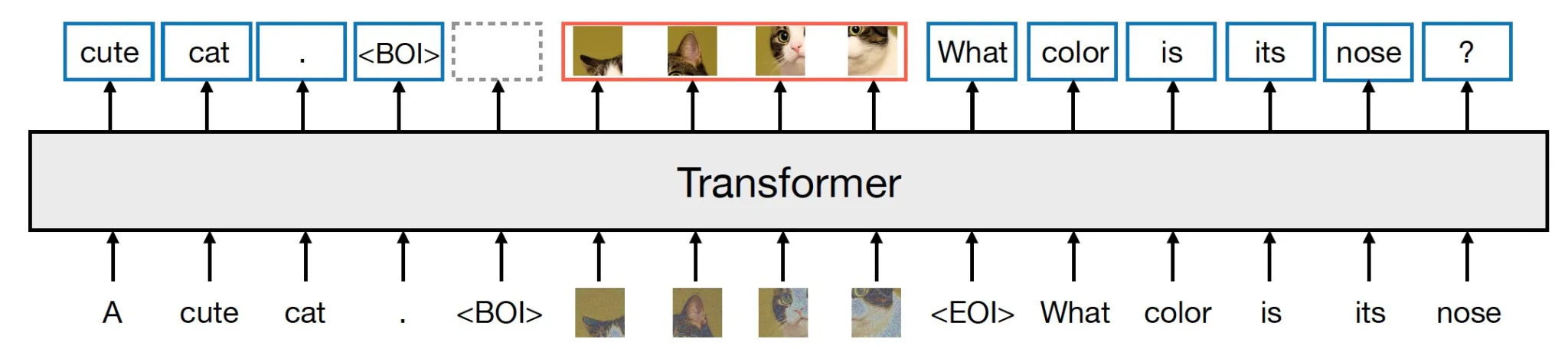

Transfusion使用统一的架构和词汇表来处理混合模态的输入。该模型包括轻量级的模态特定组件,这些组件在文本标记和图像块被Transformer处理之前,将它们转换为适当的表示形式。

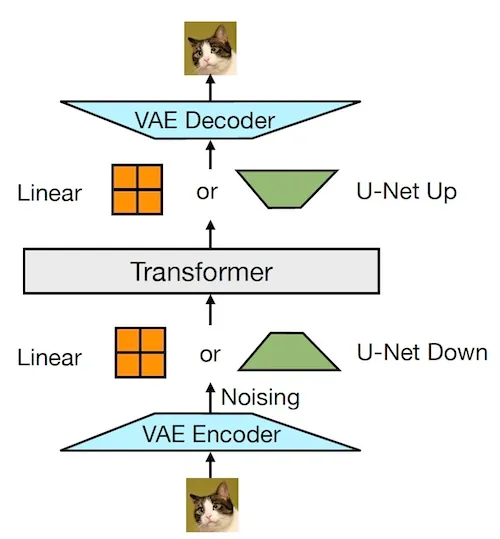

为了提高图像数据的表示能力,Transfusion使用了变分自编码器(VAE),这是一种神经网络,可以学习将复杂数据(如图像)表示在低维连续空间中。在Transfusion中,VAE被用来将图像的每个8x8块编码成一系列连续值。

“我们的主要创新在于证明我们可以对共享的数据和参数使用不同模态的单独损失——文本的语言建模和图像的扩散,”研究人员写道。

Transfusion优于基于量化的方法

研究人员基于Transfusion训练了一个70亿参数的模型,并在各种标准的单模态和跨模态基准上对其进行了评估,包括文本到文本、文本到图像和图像到文本的任务。他们将Transfusion的性能与基于Chameleon的同等规模模型进行了比较,后者是目前训练原生混合模态模型的突出开源科学方法。

在他们的实验中,Transfusion在所有模态上均一致优于Chameleon。在文本到图像的生成中,Transfusion以不到Chameleon三分之一的计算成本取得了更好的结果。同样,在图像到文本的生成中,Transfusion仅以21.8%的计算资源就达到了与Chameleon相当的性能。

令人惊讶的是,即使在文本方面,Transfusion和Chameleon都使用相同的语言建模目标,Transfusion在仅文本的基准上也表现出了更好的性能。这表明,基于量化图像标记的训练可能会对文本性能产生负面影响。

“作为替代方案,Transfusion在所有方面都比常用的基于离散图像标记的多模态训练方法具有更大的可扩展性,”周春婷说。

研究人员对图像生成进行了单独的实验,并将Transfusion与其他图像生成模型进行了比较。Transfusion在能够生成文本的同时,还优于其他流行模型,如DALL-E 2和Stable Diffusion XL。

“Transfusion为多模态学习打开了许多新的机会和有趣的应用场景,”周春婷说。“由于Transfusion像大型语言模型(LLM)一样工作,但处理的是多模态数据,这可能会解锁新的应用,在用户输入的交互会话中具有更好的可控性,例如图像的交互式编辑和视频编辑。”