DeepMind的GenRM通过自我验证提高LLM的准确性

大型语言模型(LLM)在处理复杂的推理任务时容易出现事实和逻辑错误。为了应对这一挑战,研究人员经常使用验证器或奖励模型来评估和选择LLM生成输出中最准确的响应。

在最新的一篇论文中,谷歌DeepMind、多伦多大学、蒙特利尔人工智能研究所(Mila)以及加州大学洛杉矶分校的研究人员介绍了一种名为GenRM的新型方法,该方法利用LLM的生成能力来创建更有效的验证器。GenRM可以成为那些当前验证方法失效的LLM应用的实用工具。

经典验证器和奖励模型的局限性

提高LLM准确性的常见方法之一是让它们生成多个候选答案,然后使用单独的组件来选择最佳答案。这种方法需要可靠的验证器或奖励模型。

在推理领域,基于LLM的验证器通常被训练为判别性奖励模型(RMs),它们为候选解决方案分配数值分数,然后根据这些分数将它们分类为正确或错误。然而,这些RMs并没有充分利用LLM在生成和处理响应方面的优势。

“尽管经典的奖励模型(RMs)/验证器是通过微调LLM来训练的,但它们并没有利用LLM本质上设计用于的文本生成能力,”论文的合著者、DeepMind的高级研究科学家Rishabh Agarwal告诉VentureBeat。

另一种流行的技术是“LLM作为裁判”,它使用高级的提示技术来评估响应。然而,虽然这种方法很灵活,但“LLM作为裁判”缺乏奖励模型在训练过程中获得的能力。

生成性奖励模型

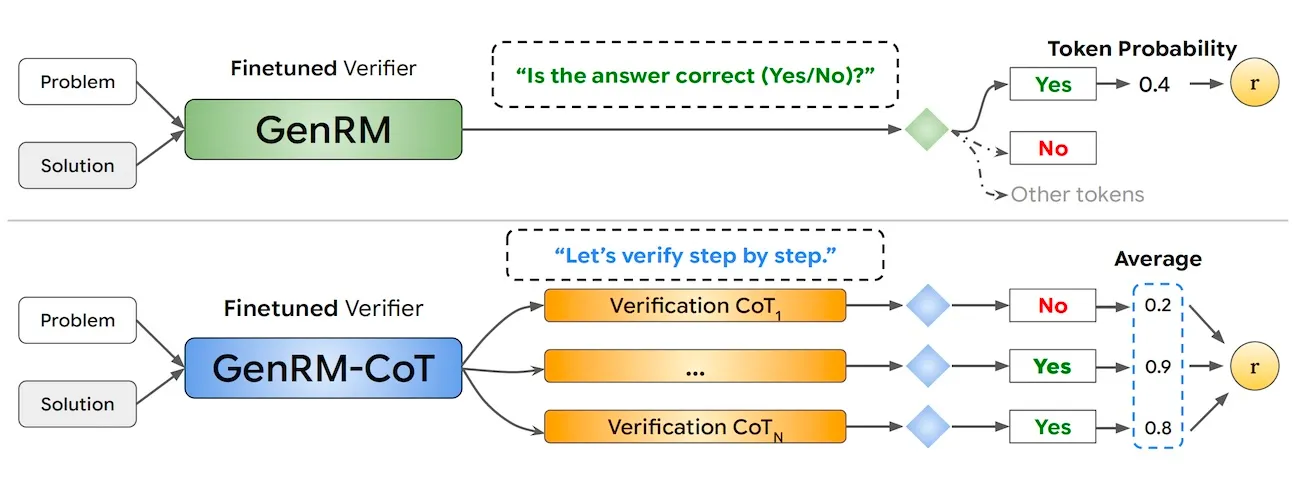

DeepMind的GenRM提出了一种不同的方法:通过使用下一个令牌预测来训练验证器,从而利用LLM的文本生成能力。

“通过下一个令牌预测来训练RMs使它们能够利用生成性LLM的众多优势,”Agarwal说。“我们展示了相同的模型如何既能验证又能生成解决方案,通过使用思维链在验证之前‘多想’,以及在测试时增加计算量来提高准确性。”

在GenRM中,验证决策被表示为一个令牌。例如,为了为解决方案生成一个数值分数,验证器会使用诸如“答案是否正确?”之类的提示,并将分数表示为在上下文和提示下单个文本令牌(如“是”或“否”)的概率。

由于验证通常涉及复杂的推理,生成性验证器可以自然地受益于诸如思维链(CoT)推理等高级提示技术,该技术要求模型在给出答案之前生成一个思维过程。

“具体来说,我们可以在对解决方案的正确性做出决定之前,生成中间推理步骤或批判(CoT),这可能会发现直接验证器错过的微妙推理错误,”研究人员写道。

用于训练GenRM模型的CoT(思维链)推理可以由人类生成,也可以由另一个LLM(大型语言模型)生成。在推理过程中,GenRM首先生成一个CoT推理,然后使用“是”令牌的概率来分配一个正确性分数。

研究人员还通过多数投票的方式进一步提高了CoT验证器的验证准确性。他们抽取多个CoT链,并计算所有样本中“是”令牌的平均分数,从而有效利用测试时间的计算资源。

“GenRM可以被视为将‘LLM作为裁判’与经典验证器结合起来:它对应于在特定领域验证数据上训练过的‘LLM作为裁判’,”Agarwal说。“因此,GenRM适用于任何现成的、经过提示的LLM不够好的领域。”

GenRM的实际应用

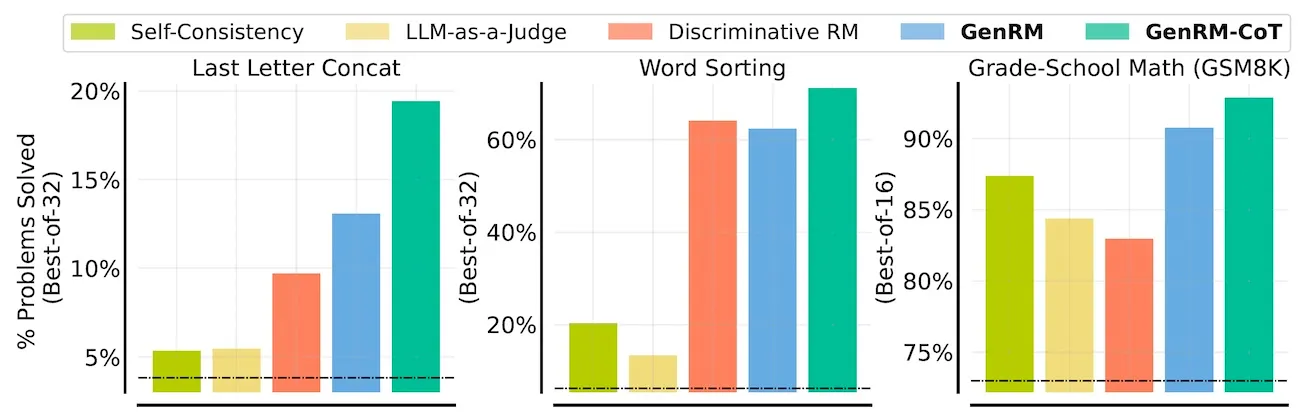

为了评估GenRM的有效性,DeepMind的研究人员将其应用于多个推理任务,包括最后一个字母的连接、单词排序和单词数学问题。他们将GenRM与标准方法进行了比较,包括判别性奖励模型、“LLM作为裁判”以及“自洽性”方法,后者是模型生成多个答案,并选择最常见的答案作为最终响应。

在所有任务中,结合了CoT的GenRM在多个百分点上始终优于其他方法,包括经过专门训练的判别性奖励模型。在GSM8K数学推理基准测试中,一个为GenRM训练的Gemma-9B模型解决了92.8%的问题,超越了GPT-4和Gemini 1.5 Pro的性能。

“通过将解决方案生成与验证统一起来,正如GenRM使用下一个令牌预测目标所做的那样,在所有任务上始终如一地提高了验证性能,”研究人员写道。“这种改进在直接和基于CoT的生成性验证器中都得到了观察,这表明教验证器模仿正确解决方案通常是有帮助的。”

实验还表明,随着数据集大小和模型容量的增加,GenRM的表现也会相应提高。此外,当允许GenRM采样更多响应时,其性能会继续提升。这为LLM应用开发人员提供了在准确性和计算成本之间取得平衡的更多灵活性。

“与使用相同数据的传统验证器相比,GenRM(通过联合训练生成和验证)仍然可以超越它们,并且GenRM的训练只是标准的微调,”Agarwal说。“不过,为了充分利用GenRM的能力,我们需要批评/验证推理,这些推理解释了奖励标签。对于高质量数据,这可以通过人类来完成,但一个更具可扩展性的选择是使用合成LLM生成的推理。”

GenRM未来可能的发展方向包括在开放式生成任务上扩展合成验证推理,将GenRM集成到强化学习流程中,以及利用先进的LLM功能,如小样本学习、检索增强生成、ReAct以及代码生成和执行来增强验证。