检索增强生成(RAG)的新突破:OP-RAG

2024年09月11日 由 neo 发表

322

0

检索增强生成(RAG) 是一种通过检索相关信息来增强大型语言模型(LLM)生成能力的技术,在问答系统等自然语言处理任务中发挥着重要作用。然而,传统的RAG方法在处理长上下文时往往面临挑战,即模型难以从大量信息中准确提取出关键信息。

OP-RAG:一种顺序保持的RAG方法

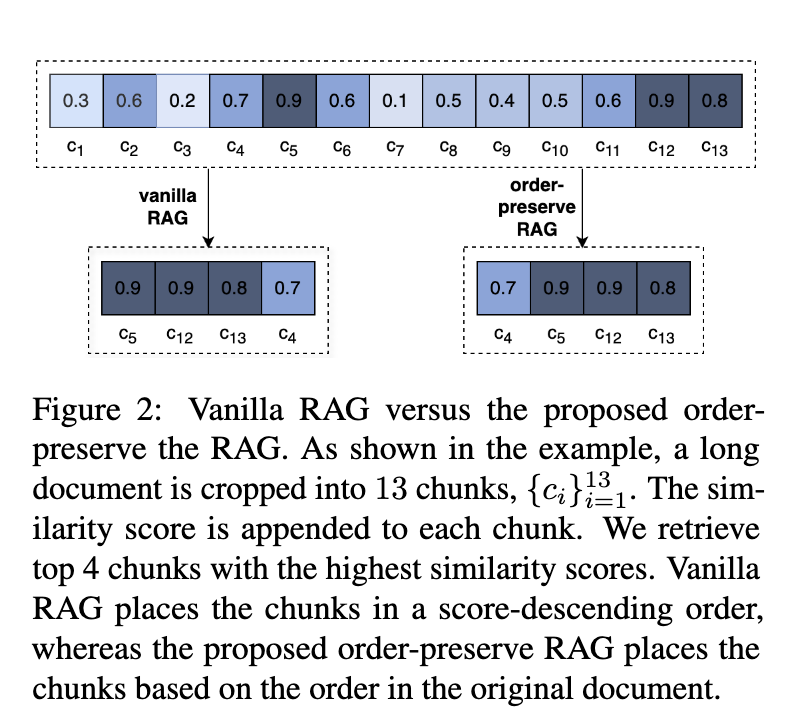

为了解决上述问题,NVIDIA的研究人员提出了一种名为OP-RAG(Order-Preserving RAG)的方法。与传统的RAG方法不同,OP-RAG在检索文本块时,不仅考虑相关性,还保留了文本块在原始文档中的顺序。这种顺序的保持,使得模型能够更好地理解上下文,从而生成更准确、连贯的答案。

OP-RAG的工作原理

OP-RAG的工作流程如下:

- 文本分割: 将大规模文本分割成连续的文本块。

- 相关性评估: 对每个文本块与查询的相关性进行评估。

- 顺序排序: 根据相关性对文本块进行排序,同时保留其在原始文档中的顺序。

- 生成答案: 模型利用排序后的文本块生成答案。

OP-RAG的优势

- 提高准确性: 通过保持文本顺序,OP-RAG能够更好地理解上下文,从而生成更准确的答案。

- 降低计算成本: OP-RAG能够在更少的标记数量下取得更好的效果,从而降低计算成本。

- 增强可解释性: OP-RAG的顺序保持机制使得模型的决策过程更加透明。

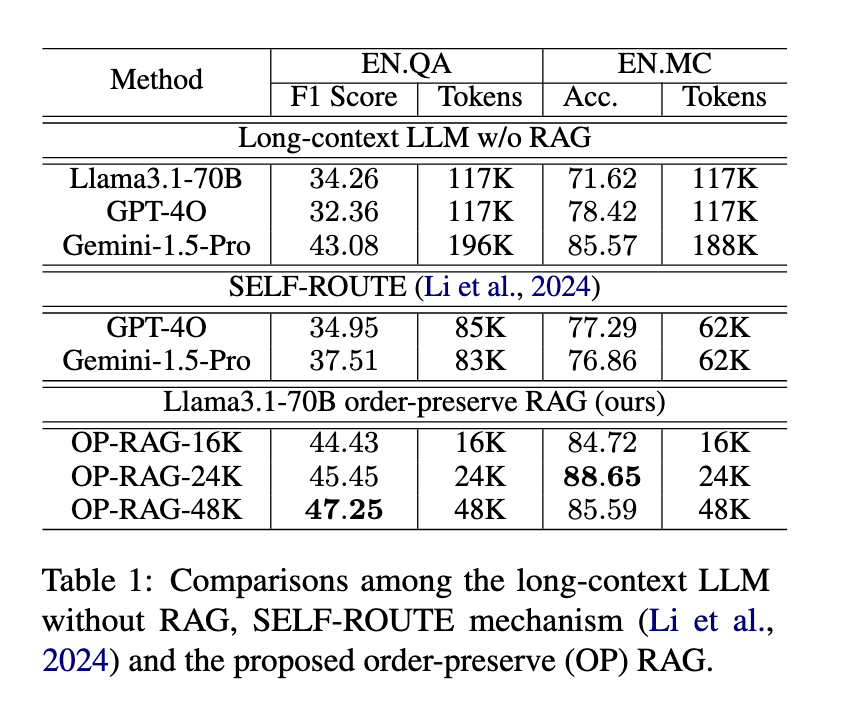

实验结果

研究人员在多个公开数据集上对OP-RAG进行了评估,结果表明OP-RAG在准确性和效率方面均优于传统的RAG方法和长上下文LLM。例如,在EN.QA数据集上,OP-RAG的F1分数比GPT-4O高出显著。

结论

OP-RAG的提出为RAG技术的发展提供了新的思路。通过保留文本顺序,OP-RAG有效地解决了长上下文LLM在处理海量信息时的难题,为自然语言处理领域带来了新的突破。

文章来源:https://www.marktechpost.com/2024/09/10/nvidia-researchers-introduce-order-preserving-retrieval-augmented-generation-op-rag-for-enhanced-long-context-question-answering-with-large-language-models-llms/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消