OpenBMB MiniCPM3-4B:性能卓越,功能全面的小型语言模型

OpenBMB近期隆重推出了MiniCPM系列的第三代产品——MiniCPM3-4B,这一模型在小规模语言模型领域内迈出了关键性的一步。MiniCPM3-4B旨在以有限的资源实现卓越性能,相较于其前身,它在功能与多用途性上实现了显著升级。

模型概览

MiniCPM3-4B作为一款高效的文本生成模型,凭借其卓越性能超越了如Phi-3.5-mini-Instruct等模型,甚至能与参数规模在7B至9B之间的高级模型相抗衡。该模型凭借尖端的技术,为用户提供了高度灵活的应用工具,涵盖对话系统、文本补全及代码生成等多个领域。

尤为引人注目的是,MiniCPM3-4B支持函数调用与内置代码解释器,这一特性使其成为了更加通用化的语言模型。这一创新不仅满足了语言模型日益多样化的需求,还实现了文本生成与计算处理的深度融合,允许开发人员直接通过模型执行代码,极大地拓宽了应用场景。

技术创新

MiniCPM3-4B的多个关键技术革新,使其从众多模型中脱颖而出。其中,模型大幅提升了处理扩展上下文长度的能力,配备的32k上下文窗口能够轻松应对大规模文本处理任务。加之LLMxMapReduce机制的引入,理论上实现了对无限上下文的处理能力,同时保持了高效的内存利用。这一特性对于处理长文档、复杂对话等应用场景尤为重要。

此外,MiniCPM3-4B针对主流框架如Hugging Face的Transformers进行了深度优化,支持PyTorch及vLLM框架,确保了模型在不同平台上的灵活部署与高效运行。其强大的兼容性与易用性,使得用户能够轻松将MiniCPM3-4B融入现有工作流程,减少了不必要的摩擦。

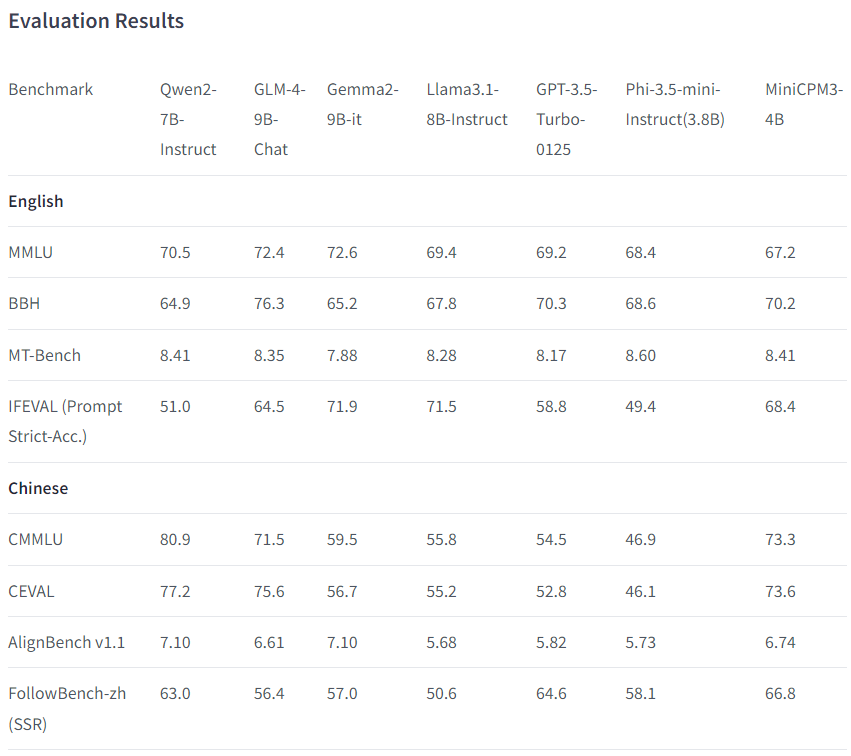

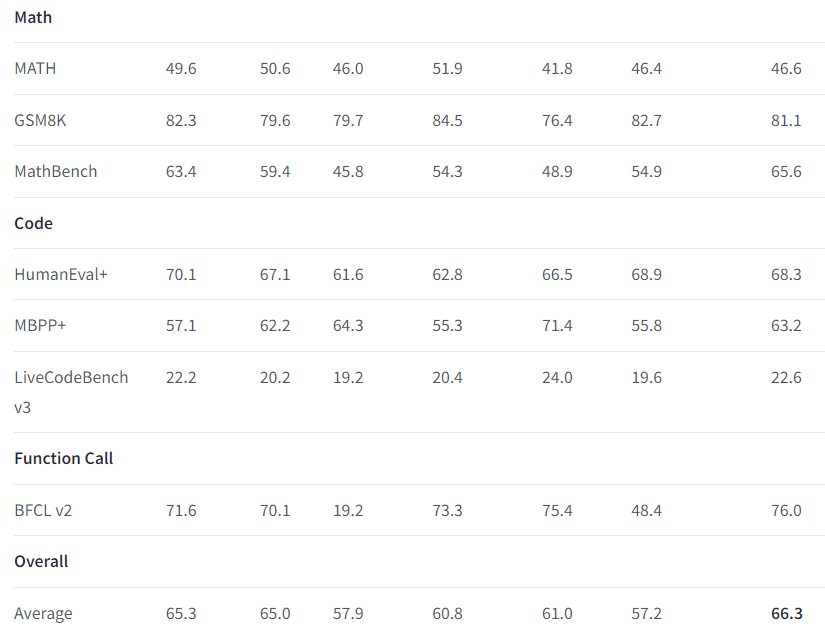

性能与评估

MiniCPM3-4B在性能评估中表现出色,不仅在MMLU(大规模多任务语言理解)基准测试中获得了70.5的高分,展现了其强大的理解与生成能力;在中文任务中,如GSM8K数学基准测试上,也取得了82.3的优异成绩,彰显了其双语处理能力的优势。

相较于同参数级别的其他模型如GPT-3.5-Turbo-0125,MiniCPM3-4B以其小巧而高效的特性,在英语及中文任务中均展现出色表现,甚至在某些情况下超越了更大规模的模型。

实际应用

MiniCPM3-4B的多功能性使其能够胜任多种应用场景。其代码生成与函数调用功能为技术环境提供了将文本生成与计算任务紧密结合的新途径。同时,长上下文窗口的设计也使其在处理复杂对话、冗长文档总结等任务时游刃有余。作为轻量级模型,MiniCPM3-4B的部署成本较低,适合资源有限的小型组织或研究团体使用,进一步拓宽了其潜在用户群。

许可与可用性

MiniCPM3-4B采用Apache-2.0许可证发布,为学术研究与商业应用提供了免费使用的可能,但需完成注册流程。这一开放的许可政策鼓励了各领域的广泛尝试与应用探索。同时,发布的文档中包含了模型的推荐引用方式,确保了学术与研究环境中对模型贡献的正确认可。

结论

OpenBMB发布的MiniCPM3-4B无疑是高效、高性能语言模型领域的重要里程碑。其高级功能如函数调用、代码解释及扩展上下文处理能力的实现,使得MiniCPM3-4B成为研究与实际应用中的多功能利器。在多个基准测试中的卓越表现与开放的许可模型共同确保了MiniCPM3-4B在学术界与工业界的广泛应用前景。其在上下文管理与计算效率方面的显著改进更是使其在中型语言模型市场中脱颖而出,为用户提供了强大的文本生成工具及更多创新可能。