谷歌推出DataGemma模型,旨在减少语言模型中的事实错误

谷歌最近宣布了DataGemma,这是其基于Gemini架构的开放型Gemma模型的两个新版本,它们依赖于谷歌Data Commons中的现实世界统计数据。谷歌声称,DataGemma是首个通过此类方式减少“幻觉”(即事实错误)的开放模型。

长期以来,语言模型在处理涉及数值或统计数据的任务时,常常出现事实错误,这是一个亟待解决的问题。谷歌的Data Commons是一个包含超过2400亿个数据点的仓库,数据来源于联合国、疾病控制与预防中心等可信机构。

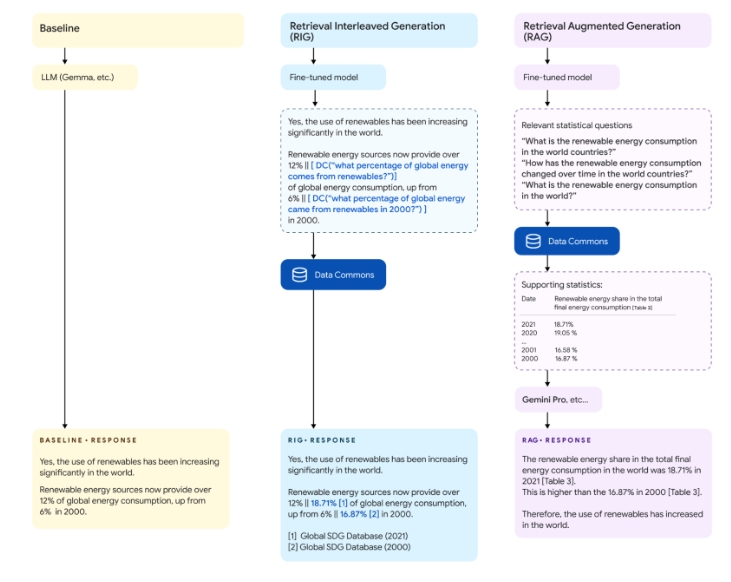

DataGemma通过两种关键技术——检索交织生成(RIG)和检索增强生成(RAG),在生成过程中将模型输出与现实世界数据相结合,以减少事实错误。RIG在生成响应前主动查询可信源,而RAG则在生成前从Data Commons中检索相关信息,并通过Gemini 1.5 Pro的长上下文窗口功能提供全面答案。

初步研究结果显示,这两种技术显著提高了模型处理数值事实和统计查询的准确性。然而,研究也指出了存在的挑战,包括Data Commons自然语言接口的精度问题、模型生成不相关问题以及数据覆盖范围不足等。

具体而言,使用RIG方法时,事实准确性从基准的5-17%大幅提升至约58%,但在约33-27%的案例中,模型或Data Commons提供了错误信息。而RAG方法在引用具体数值时表现出色,准确率高达98-99%,但在基于统计数据进行推断时,有6-20%的案例出现错误或不实推断。

谷歌强调,DataGemma目前主要用于学术和研究目的,尚未准备好商业化或面向公众使用。未来,团队计划扩大训练数据集、改进Data Commons的自然语言处理能力,并探索展示事实核查结果的用户界面。

此外,谷歌还认识到该工作的伦理影响,已进行红队测试以检查潜在危险查询,并承诺持续评估和完善模型行为。随着研究的深入,DataGemma有望为创建更可信、更可靠的AI系统奠定基础,并在医疗、政策制定、教育和科学研究等领域产生广泛影响。