苹果推出轻量级UI理解架构:UI-JEPA

苹果公司研究人员推出了一种名为UI-JEPA的新架构,旨在减少用户界面(UI)理解的计算需求同时保持高效性能。该架构意在实现轻量级设备端UI理解,推动更快速且保护隐私的人工智能助手应用发展。

理解用户从UI交互中表达的意图需要处理跨模态特征,包括图像和自然语言,并捕捉UI序列中的时间关系。尽管大型多模态语言模型(MLLMs)如Anthropic Claude 3.5 Sonnet 和 OpenAI GPT-4 Turbo 提供了个性化规划的途径,但这些模型对计算资源的需求高,模型规模庞大,并且引入了高延迟,这使得它们不适合需要轻量级、设备端解决方案的应用场景。

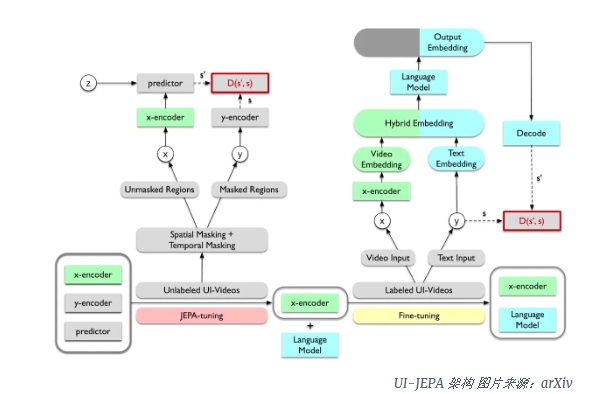

为了应对这一挑战,UI-JEPA借鉴了Meta AI首席科学家Yann LeCun于2022年提出的联合嵌入预测架构(JEPA)。与尝试填补每个缺失细节的生成方法不同,JEPA可以丢弃不可预测的信息,从而提高训练和样本效率。

UI-JEPA架构包括基于JEPA的视频变换器编码器和仅解码器的语言模型(LM)。前者将UI交互视频处理成抽象特征表示,后者则根据视频嵌入生成用户意图的文字描述。研究者使用了大约30亿参数的轻量级LM——Microsoft Phi-3,适用于设备端实验和部署。

为推进UI理解的研究,研究者还引入了两个新的多模态数据集和基准:“野生环境下的意图”(IIW)和“驯化环境下的意图”(IIT)。IIW涵盖了开放式的UI动作序列,其中用户意图模糊;而IIT则专注于意图较为明确的常见任务。

评估结果显示,在新基准测试中,UI-JEPA在少量示例设置下优于其他视频编码器模型,并且其性能与更大的封闭模型相当,但参数量远少于云基模型。此外,通过结合使用光学字符识别(OCR)从UI中提取文本,进一步提高了UI-JEPA的表现力。

研究人员认为,UI-JEPA模型有多种潜在用途,例如创建自动反馈环路以使AI代理能够连续学习而无需人工干预,以及整合到追踪跨不同应用程序和模态用户意图的框架中作为感知代理。此外,UI-JEPA可以利用屏幕活动数据来更紧密地与用户偏好对齐并预测用户行为。