Anthropic 的新技术将 RAG 准确性提高了 67%

Anthropic 推出了一种名为“上下文检索”的新方法,该方法显著改善了 AI 系统从大型知识库中访问和利用信息的方式。这项技术解决了传统检索增强生成(RAG)系统的一个关键弱点。

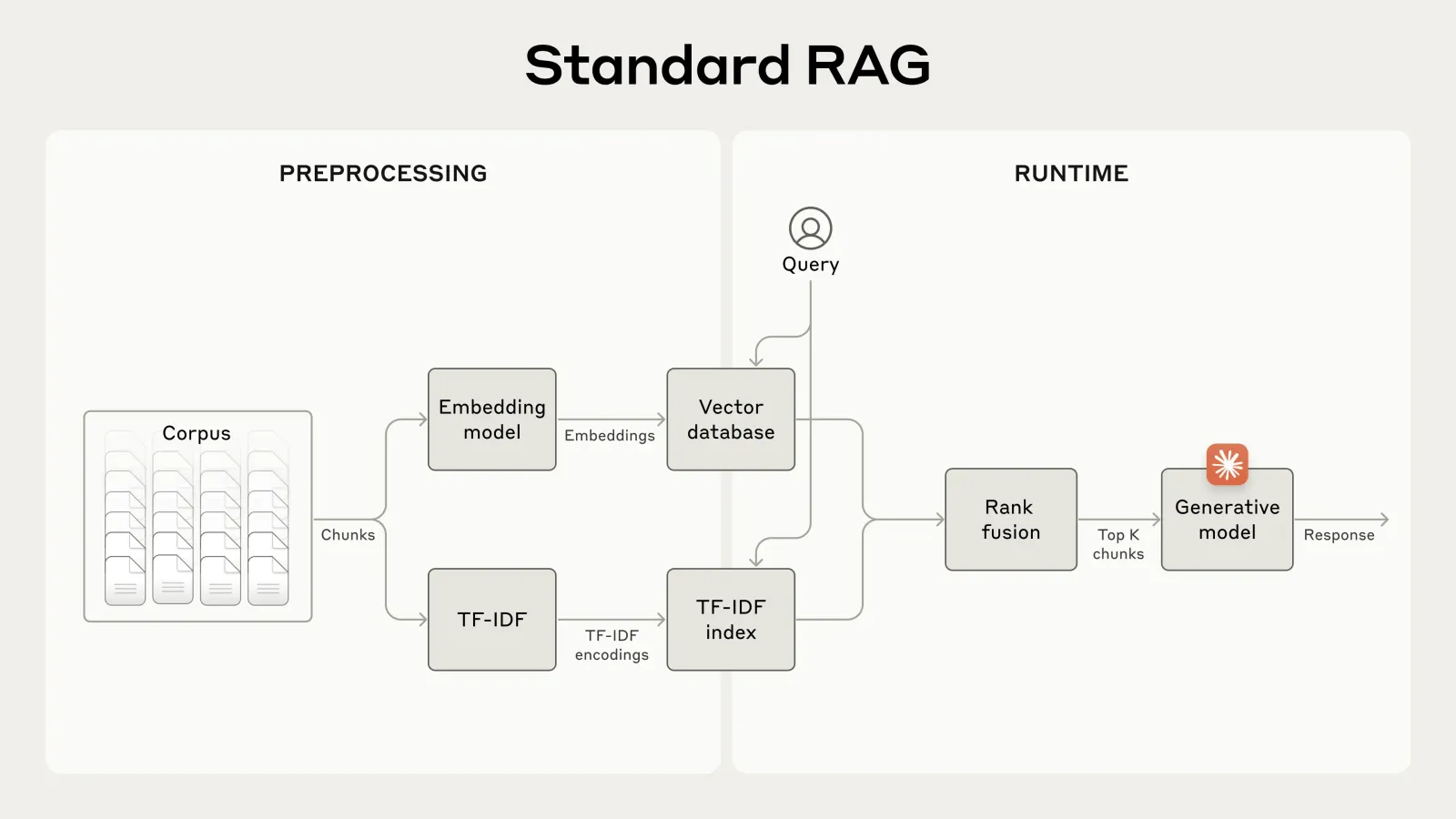

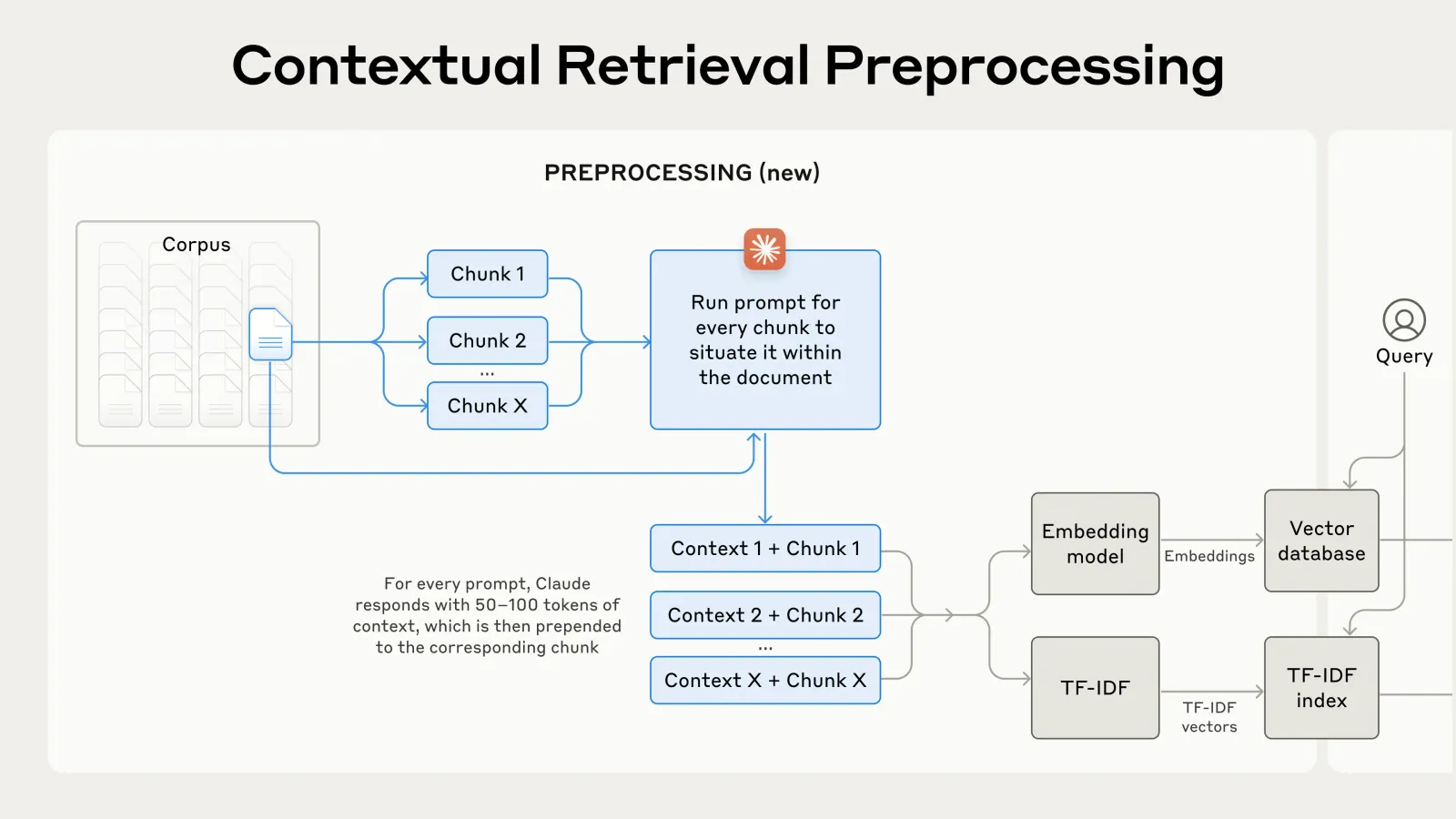

上下文检索解决了 RAG(检索增强生成)中的一个基本问题:当文档被分割成较小的块进行处理时,会丢失上下文。通过在每个块被嵌入或索引之前添加相关的上下文信息,该方法保留了可能会丢失的关键细节。

从实际操作的角度来看,这涉及到使用 Anthropic 的 Claude 模型来生成特定于块的上下文。例如,一个简单的块陈述“公司收入较上一季度增长了 3%”,通过上下文化处理后,会包含额外的信息,如具体的公司名称和相关的时间段。这种增强的上下文确保了检索系统能够更准确地识别和利用正确的信息。

该技术采用两个关键组件:上下文嵌入(Contextual Embeddings)和上下文 BM25(Contextual BM25)。这两个组件协同工作,极大地减少了检索失败的情况——即 AI 无法找到最相关信息的情况。

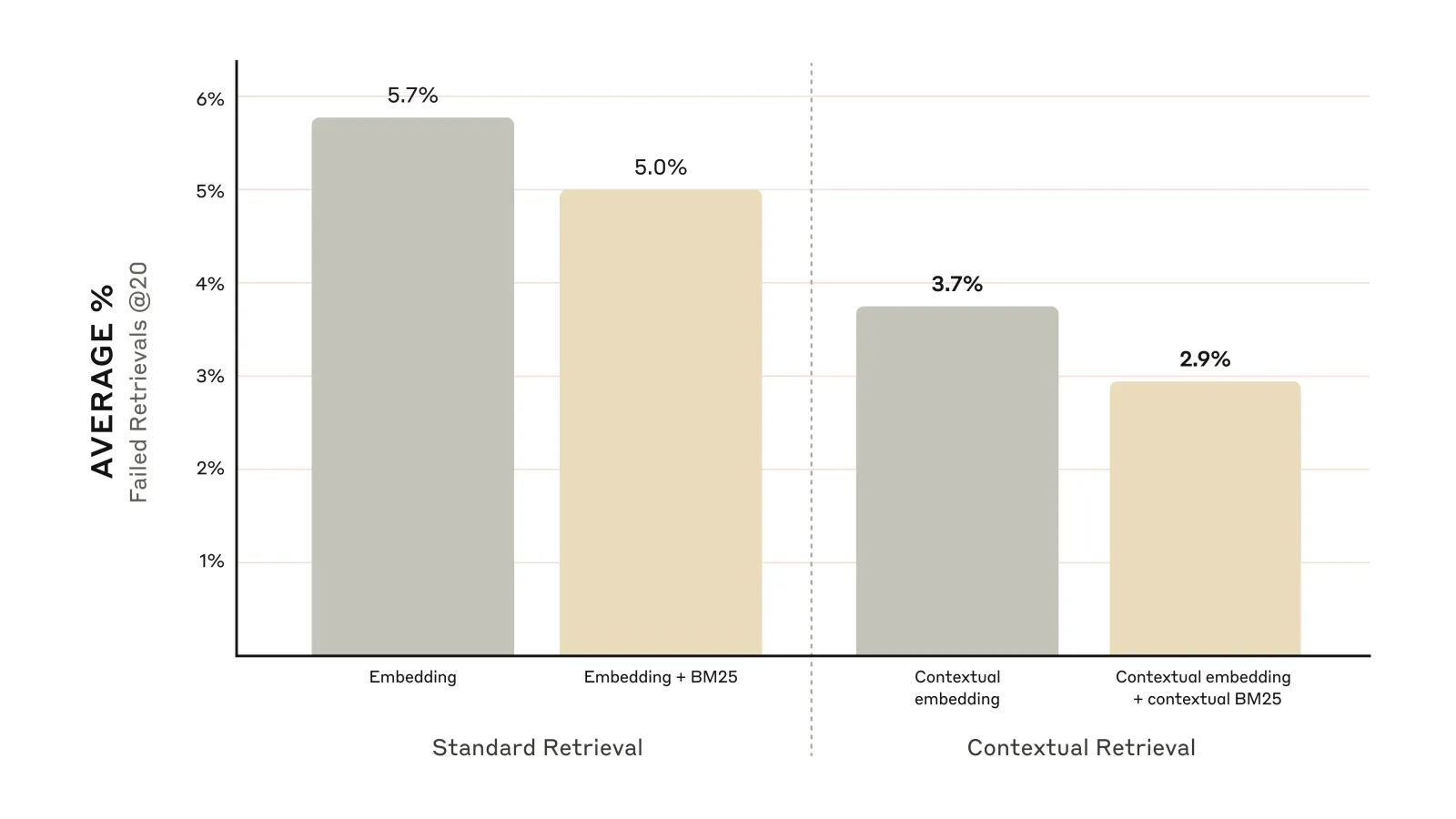

Anthropic 的开发者关系主管 Alex Albert 强调了这一进展的重要性:“上下文检索将错误的块检索率降低了高达 67%。当与即时缓存结合使用时,它可能是实现 RAG 应用中检索的最佳技术之一。”

我们很高兴分享关于上下文检索的最新研究成果——这项技术将错误的块检索率降低了高达 67%。

当与即时缓存结合使用时,它可能是实现 RAG 应用中检索的最佳技术之一。

让我来解释一下:pic.twitter.com/UG1H8DLMxZ

—— Alex Albert (@alexalbert__) 2024年9月19日

这些改进是实质性的:

仅上下文检索嵌入就将检索失败率降低了 35%

将上下文检索嵌入与上下文 BM25 结合使用,失败率降低了 49%

在这些技术之上增加重新排序步骤,失败率降低了 67%

这些准确性的提升直接转化为下游任务的更好性能,可能会提高各种应用中 AI 生成响应的质量。

Anthropic 的研究表明,上下文检索在包括代码库、小说、科学论文和金融文档在内的各种知识领域中均表现出色。尽管使用的嵌入模型不同,但这项技术始终如一地显示出改进效果,不过像 Gemini 和 Voyage 这样的嵌入模型被发现尤其有效。

使上下文检索成为可能的关键创新之一是即时缓存,该公司上个月宣布了这一技术,并显著降低了实施成本。上下文化的估计成本仅为每百万文档标记 1.02 美元。这种成本效益使得上下文检索适用于大规模应用,因为在这些应用中,对块进行手动注释将不切实际。

如果您对实现上下文检索感兴趣,Anthropic 已发布了一份详细指南,介绍了该过程。该公司鼓励对该技术进行实验,并指出,针对特定领域定制的自定义提示可能会产生更好的结果。