o1-preview与 Claude 3.5 Sonnet谁更胜一筹?

前一阵OpenAI 发布了其最新语言模型 o1-preview。这种先进的模型在生成响应之前会花更多时间进行处理,使其能够处理复杂的任务,并以更强的能力解决科学、编码和数学领域的挑战性问题。

在本文中,我们将全面分析 o1-preview,并将其与 Claude 3.5 Sonnet 进行比较,后者曾被认为是目前最先进的模型之一。

比较方法

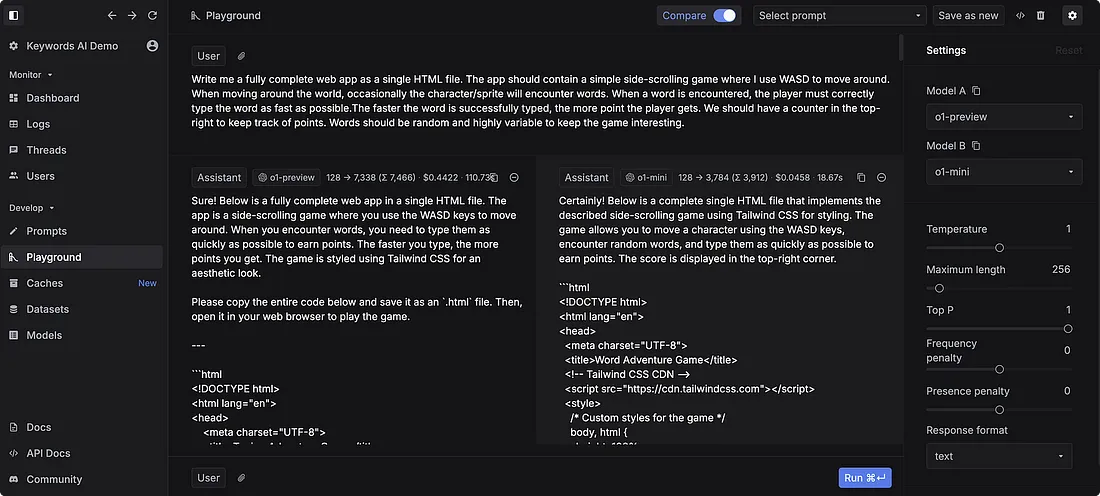

我们的分析使用了 Keywords AI 的 LLM playground,这是一个支持 200 多种语言模型并提供函数调用功能的平台。我们将从以下几个方面进行探讨:

- 基本比较

- 基准比较

- 处理速度

- 评估指标

- 建议的使用案例

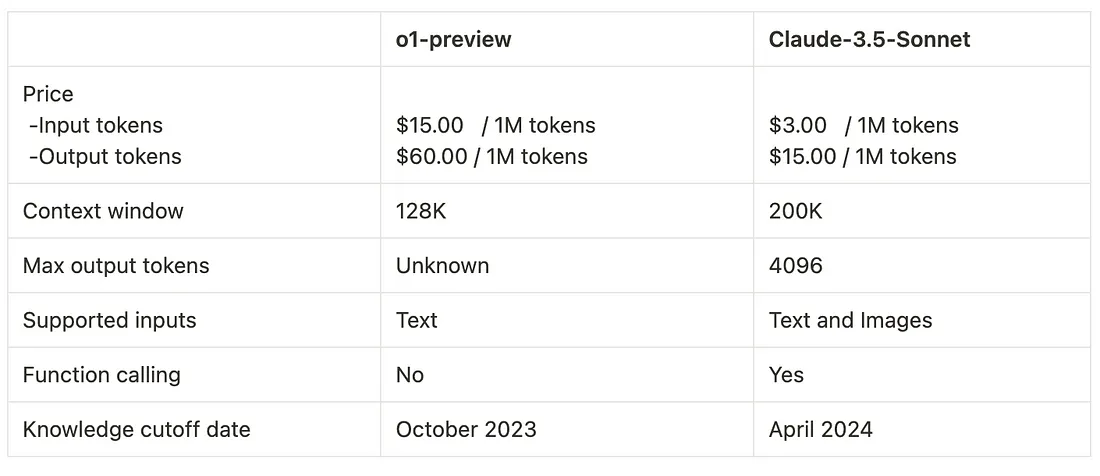

基本比较

注:o1-preview 不支持流媒体、函数调用和系统消息。

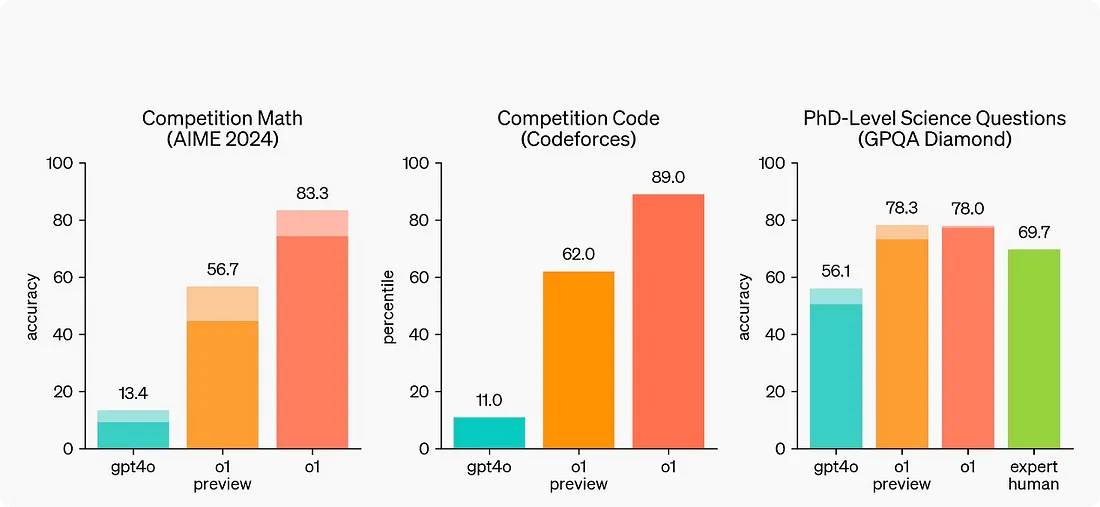

基准比较

在所有基准测试中,O1-preview 均优于 Claude 3.5 Sonnet。差距最小的是 MMLU(常识)。测试研究生水平推理能力的 GPQA Diamond 显示出显著的性能差距。MATH 基准显示了最大的差距,凸显了 o1-preview 的高级数学能力。这些结果表明,o1-preview 在各个领域的复杂推理和问题解决方面都有显著提高。

速度比较

与其他 LLM 相比,O1-preview 的思考和响应时间更长。虽然直接进行速度比较可能并不完全公平,但测试 o1-preview 的速度至关重要。这些信息有助于开发人员更好地了解 o1-preview 的功能,并确定它是否适合自己的项目。

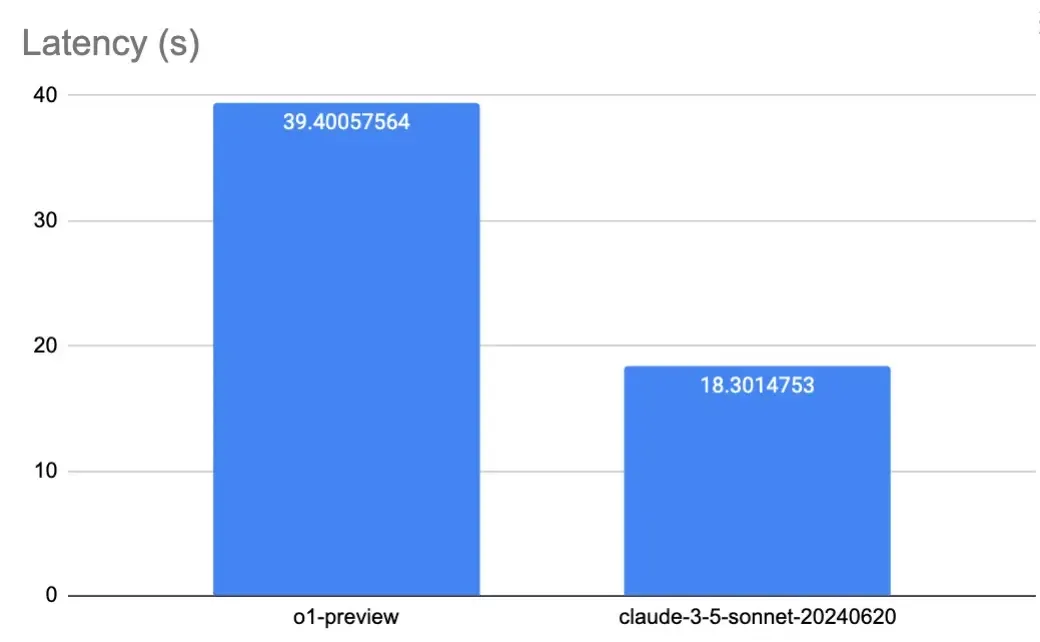

延迟

我们的测试涉及每个模型的数百个请求,测试结果显示了明显的差异。Claude 3.5 Sonnet 平均每请求 18.3 次,而 o1-preview 每请求 39.4 次。O1-preview 的延迟时间明显更长,这是因为它扩展了思考和推理过程。

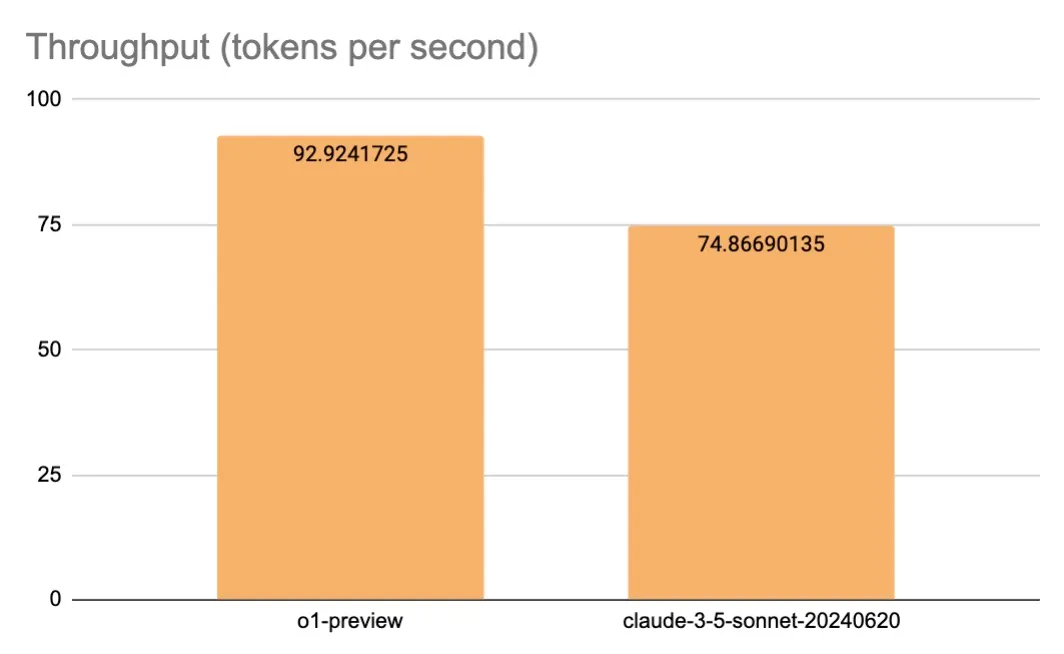

吞吐量(每秒令牌数)

尽管延迟更高,但 o1-preview 的吞吐量却更胜一筹。O1-preview 每秒生成 92.94 个令牌,而 Claude 3.5 Sonnet 每秒生成 74.87 个令牌。这表明,o1-preview 生成时间较长的主要原因是其初始处理阶段,而不是令牌生成速度。

性能比较

我们在关键词人工智能平台上进行了评估测试。评估包括三个部分:

- 编码任务: 两个模型都成功完成了前端和后端开发任务。O1-preview 在较长的上下文环境中表现出更优越的性能,第一次尝试就能更高效地识别和解决错误。它还表现出了更全面的代码分析能力。

- 逻辑推理: O1-preview 在推理任务中表现出色。它的思维过程非常接近人类认知。Claude 3.5 Sonnet 在大多数问题上都表现出色,而 O1-preview 则始终能解决复杂的推理难题,包括国际数学奥林匹克(IMO)级别的问题。

- 写作任务: 这两个模型在写作任务上的表现都非常出色。它们能够撰写真实、个性化的冷冰冰的电子邮件,以及简洁而有意义的博客文章。

模型推荐

o1-preview

- 适合:解决数学、编码和物理方面的复杂问题。特别适合研究人员处理具有挑战性的任务。

- 不适合:需要快速响应时间或严重依赖系统提示的人工智能应用。由于缺乏流媒体支持,语音 AI 应用程序。

Claude 3.5 Sonnet

- 适合:大多数需要解决问题和生成高质量内容的人工智能应用。

- 不适合:语音人工智能应用或有严格预算限制、需要较低运营成本的项目。

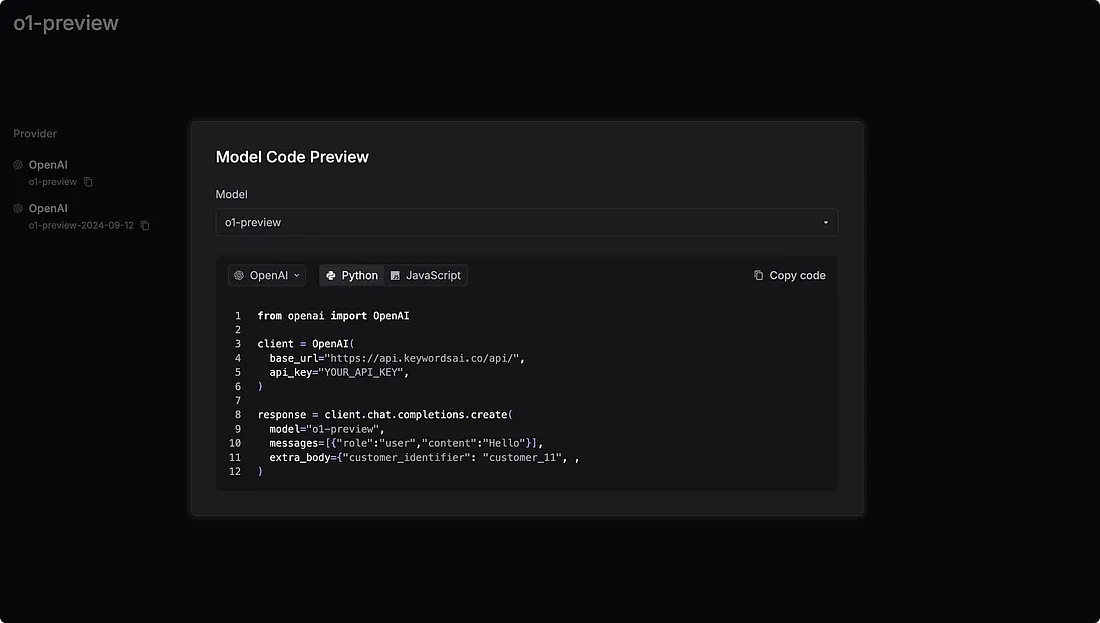

如何将 o1-preview 集成到你的人工智能应用程序中

要将 o1-preview 集成到你的人工智能应用程序中,只需访问关键字人工智能模型页面并找到 “查看代码 ”按钮。点击该按钮复制提供的代码段,然后直接粘贴到你的代码库中。通过这个简单的过程,你就可以在你的项目中利用 o1-preview 的强大功能,轻松解决复杂的问题并生成高质量的内容。