Liquid AI发布新型语言模型系列

Liquid AI近期推出了一系列旨在重塑AI领域格局的新型语言模型,即Liquid Foundation Models(LFMs)。与传统基于Transformer的架构相比,LFMs在保持顶尖性能的同时,实现了更小的内存占用和更高效的推理。

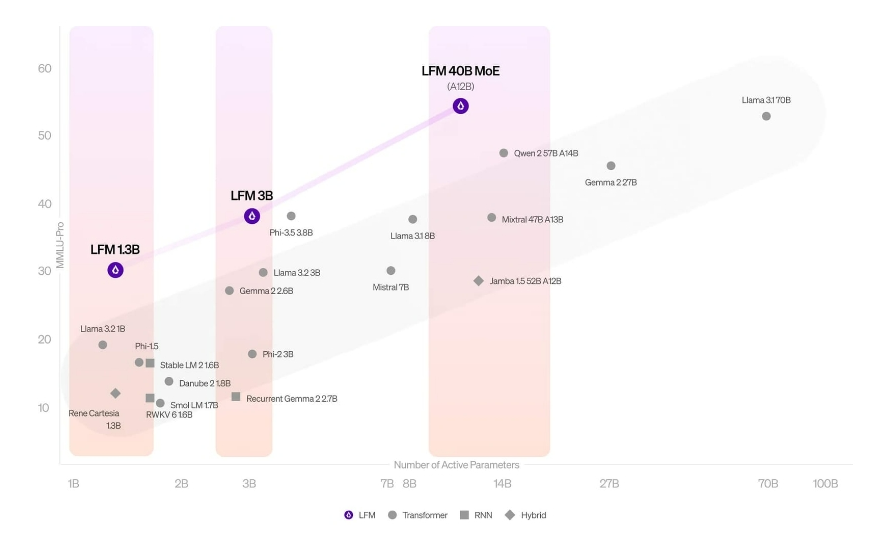

此次发布的模型系列包括LFM-1B、LFM-3B和LFM-40B三款,分别针对AI生态系统中的不同应用场景。LFM-1B拥有13亿参数,在其规模类别中树立了新的标杆,成为首个在多个公共基准测试中显著超越同规模Transformer模型的非GPT架构。

LFM-3B则配备了31亿参数,特别针对边缘部署设计,尤其适用于移动应用。据Liquid AI透露,该模型不仅优于其他3B参数模型,甚至在某些方面还超越了7B和13B参数模型。在多个基准测试中,LFM-3B的性能与微软的Phi-3.5-mini相当,但体积却小了18.4%。

在高端领域,LFM-40B采用了混合专家(Mixture of Experts,MoE)架构,在实际使用中激活12亿参数。Liquid AI表示,该模型在提供与更大模型相当性能的同时,还能在成本效益更高的硬件上实现更高的吞吐量。

LFMs的一个关键差异在于其处理长输入的方式。与Transformer模型随输入长度线性增长内存使用不同,LFMs的内存占用更为稳定。这种效率使得它们能够在相同硬件上处理更长的序列,公司声称其模型优化的上下文长度可达32000个标记。

Liquid AI的方法偏离了主流的Transformer架构,而是基于动力学系统、信号处理和数值线性代数等原则构建。公司称,这一基础使得LFMs能够利用这些领域数十年的理论进展。

尽管具备这些能力,Liquid AI也指出了当前模型的局限性,如处理零样本代码任务、精确数值计算、时间敏感信息等方面存在困难。

对于想要尝试LFMs的用户,可以通过Liquid Playground、Lambda(包括聊天界面和API)以及Perplexity Labs等途径。此外,Cerebras Inference也即将支持这些模型。Liquid AI还在为NVIDIA、AMD、Qualcomm、Cerebras和Apple等公司的硬件优化LFM堆栈,可能进一步扩大其在不同计算环境中的可用性。

然而,尽管Liquid AI的Liquid Foundation Models在基准测试和架构创新方面表现出色,但这项技术仍处于早期阶段。虽然模型在理论上显示出巨大潜力,但其实际效果和可扩展性尚未得到充分验证。随着AI领域不断探索新的模型架构,LFMs无疑是一个值得关注的进展,但其对AI领域的真正影响还需时间和实践来检验。