Tx-LLM:Google推出革命性药物研发工具,加速端到端创新进程

药物研发是一项成本高昂、耗时长且风险高的过程,通常需要10至15年的时间和高达20亿美元的投入,而大多数候选药物在临床试验中遭遇失败。成功的疗法必须满足严格的靶标相互作用、非毒性和适当的药代动力学等标准。当前的人工智能模型虽专注于该流程中的专门任务,但其有限的范围可能会影响性能。

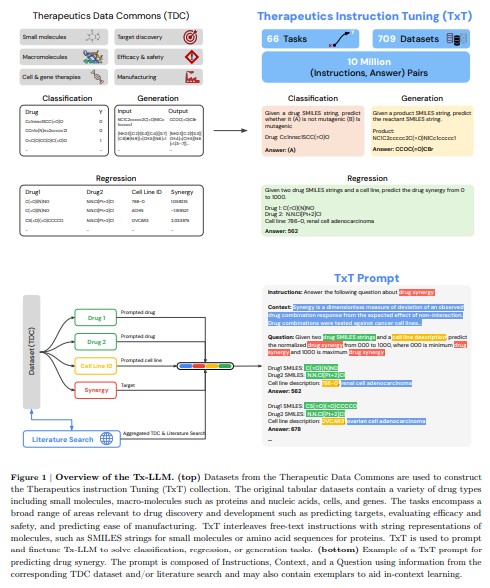

为了改进这一状况,治疗数据共享计划(Therapeutics Data Commons,TDC)提供了数据集,帮助人工智能模型预测药物属性。然而,这些模型往往是独立工作的。具备多任务处理能力的大规模语言模型(LLM)则为通过统一方法在多个任务上学习以改进治疗方法提供了潜力。

特别是基于Transformer的LLM,已经在自然语言处理方面取得了显著进展。通过在大型数据集上进行自监督学习,这些模型在多种任务上表现出色。最近的研究表明,LLM还可以处理包括回归在内的多种任务,使用参数的文本表示。

在治疗方面,像图神经网络(Graph Neural Networks,GNNs)这样的专门模型将分子表示为图形,用于药物发现等功能。蛋白质和核酸序列也被编码以预测结合和结构等属性。随着LLM在生物学和化学领域的应用越来越广泛,像LlaSMol和蛋白质特定模型等已经在药物合成和蛋白质工程任务中取得了有希望的结果。

为了推动这一领域的发展,Google Research和Google DeepMind的研究人员推出了Tx-LLM。这是一个经过精细调整的通用大规模语言模型,从PaLM-2开始为多样化的治疗任务设计。Tx-LLM在覆盖药物发现流程中的66个功能的709个数据集上进行训练,使用一套权重处理各种化学和生物实体,如小分子、蛋白质和核酸。

为了训练Tx-LLM,研究人员编制了一个名为TxT的数据集合。这个集合包含了来自TDC数据库的709个药物发现数据集,涵盖了66个任务。每个数据集都包含指示、背景、问题和答案四个组成部分,适用于指示调整。这些任务包括二元分类、回归和生成任务,使用SMILES字符串代表分子和氨基酸序列代表蛋白质等表示形式。

Tx-LLM在TDC数据集上展现出强大的性能。在66个任务中的43个任务上,它超过或与最先进的结果相匹配。在22个数据集上,它超过了最先进的模型,并在其他21个数据集上取得了接近最先进的性能。特别是在将SMILES分子字符串与疾病或细胞系描述等文本特征结合的数据集中,Tx-LLM表现出色。这可能是由于模型具备对文本的预训练知识。然而,在仅依赖SMILES字符串的数据集上,模型表现较差,而基于图的模型更加有效。

值得注意的是,Tx-LLM是第一个在包括分子、蛋白质、细胞和疾病在内的多样化TDC数据集上训练的LLM。与非小分子数据集(如蛋白质)一起进行训练可以提高小分子任务的性能。虽然通用的LLM在专门化的化学任务方面存在困难,但Tx-LLM在回归方面表现出色,在某些情况下甚至超过了最先进的模型。

该模型显示出从基因识别到临床试验的端到端药物研发潜力。然而,Tx-LLM目前仍处于研究阶段,在自然语言指令和预测准确性方面还存在局限性。为了进一步拓宽应用范围,研究人员需要对模型进行改进和验证。随着技术的不断发展,相信Tx-LLM将在未来为药物研发领域带来更多的创新和突破。