为AI模型评分:Endor Labs推出评估工具

近日,Endor Labs宣布推出了一项名为“Endor Scores for AI Models”的新功能,旨在帮助开发者在Hugging Face平台上更安全、高效地选择开源AI模型。Hugging Face是一个知名的分享大型语言模型(LLM)、机器学习模型及其他开源AI模型和数据集的平台。

随着开发者对现成AI模型的需求日益增长,越来越多的开发者转向Hugging Face等平台。这一趋势与早期开源软件(OSS)的普及情况相似,但AI模型的复杂性和潜在风险也对AI治理提出了新的挑战。Endor Labs的新功能通过提供简单直观的评分系统,为开发者在选择AI模型时提供了有力的支持。

Endor Labs的联合创始人兼CEO Varun Badhwar表示:“我们的使命一直是保护代码所依赖的一切内容,而AI模型无疑是这一任务中的下一个重要领域。如今,每个组织都在尝试使用AI模型,无论是为特定应用程序提供动力,还是建立整个基于AI的业务。因此,安全性必须跟上,而现在正是一个难得的机会,我们可以从一开始就避免潜在的风险和高昂的维护成本。”

Endor Labs的创始工程师George Apostolopoulos也对此新功能表示了肯定:“现在,几乎每个人都在尝试使用AI模型。一些团队正在构建全新的基于AI的业务,而其他人则正在寻找将‘AI技术驱动’标签添加到其产品上的方法。但有一点是肯定的,那就是您的开发人员正在积极尝试使用AI模型。然而,这种便利并非没有风险。当前的情况类似于‘荒野西部’,人们往往会选择符合自己需求的模型,却忽视了潜在的漏洞。因此,我们需要一个可靠的评分系统来帮助开发者做出明智的选择。”

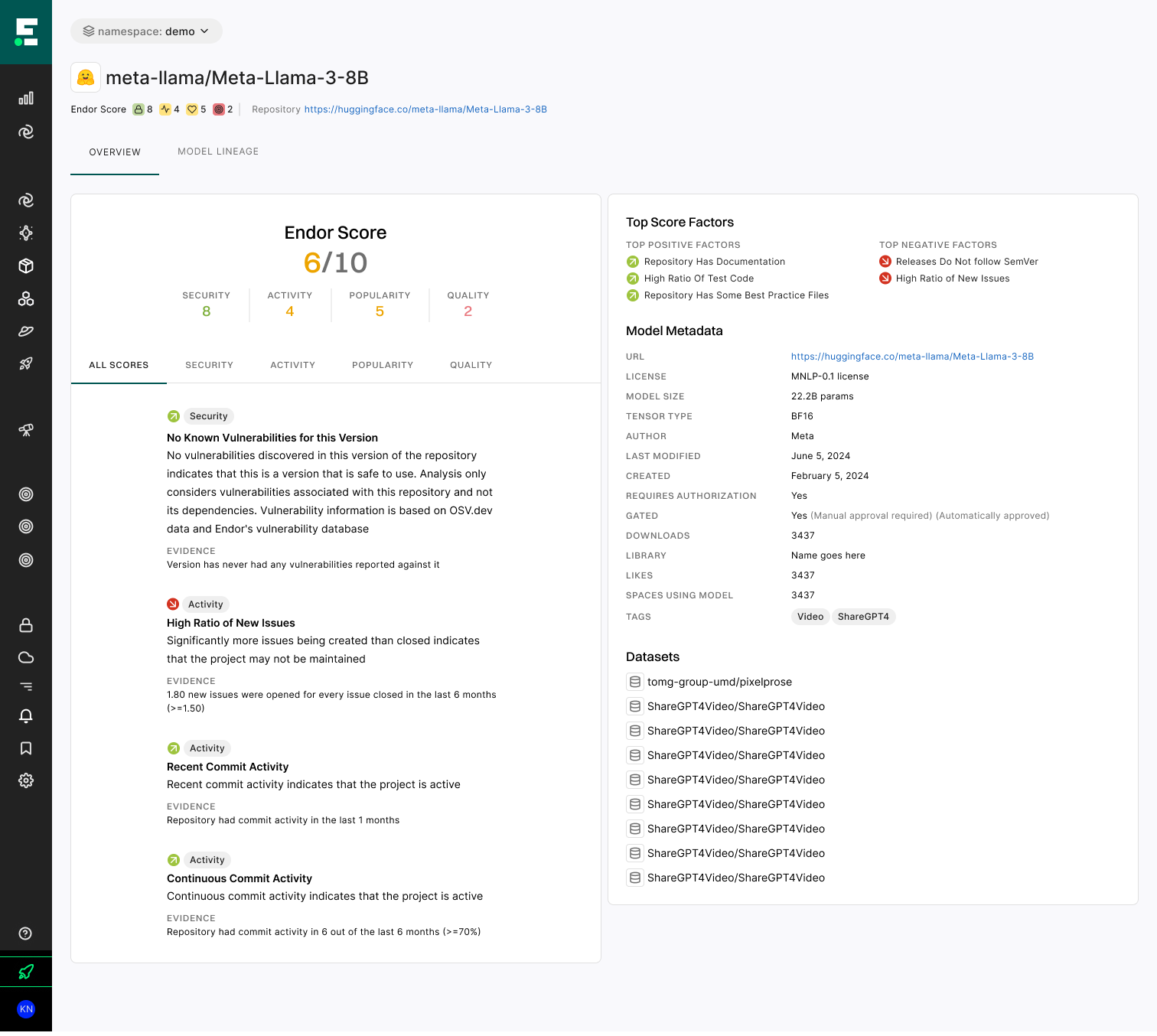

Endor的AI模型评分工具专注于评估模型的安全性、流行度、质量和活跃度,并考虑了多个关键风险领域,如安全漏洞、法律和许可问题以及运营风险。为了生成准确的评分,Endor Labs的评估工具对Hugging Face上的AI模型应用了50个预设的检查,并根据维护者数量、企业赞助、发布频率和已知漏洞等因素进行综合评估。

Endor Scores的一个显著特点是其用户友好的搜索和排名功能。开发人员无需知道具体的模型名称,只需输入一般问题,如“我可以用什么模型来分类情感?”或“来自Meta的最受欢迎的模型有哪些?”,该工具就能提供清晰的评分和排名,帮助开发者快速找到最合适的选项。

Apostolopoulos强调:“您的团队每天都会被问到关于AI的问题,他们会寻找能够加速创新的模型。通过与Endor Labs一起评估开源AI模型,您可以确保所使用的模型既符合预期又是安全的。这将为您的业务带来更大的灵活性和竞争力。”

Endor Labs的这项新功能无疑为开发者在选择开源AI模型时提供了一个有力的工具。随着AI技术的不断发展和普及,我们有理由相信,这一评分系统将在未来发挥更加重要的作用,推动AI技术的健康、快速发展。