PyTorch 2.5发布:重大更新引领机器学习框架前沿

PyTorch社区一直在先进机器学习框架领域处于领先地位,致力于满足全球研究人员、数据科学家和AI工程师日益增长的需求。近日,PyTorch 2.5正式发布,旨在解决机器学习社区面临的几大挑战,重点聚焦于提高计算效率、缩短启动时间,并增强新硬件的性能扩展性。

此次发布,PyTorch特别针对transformer模型和大型语言模型(LLMs)中的瓶颈问题进行了优化,持续改进GPU环境下的训练和推理效率。这些更新不仅巩固了PyTorch在AI基础设施领域的领先地位,也为用户带来了更加高效和便捷的使用体验。

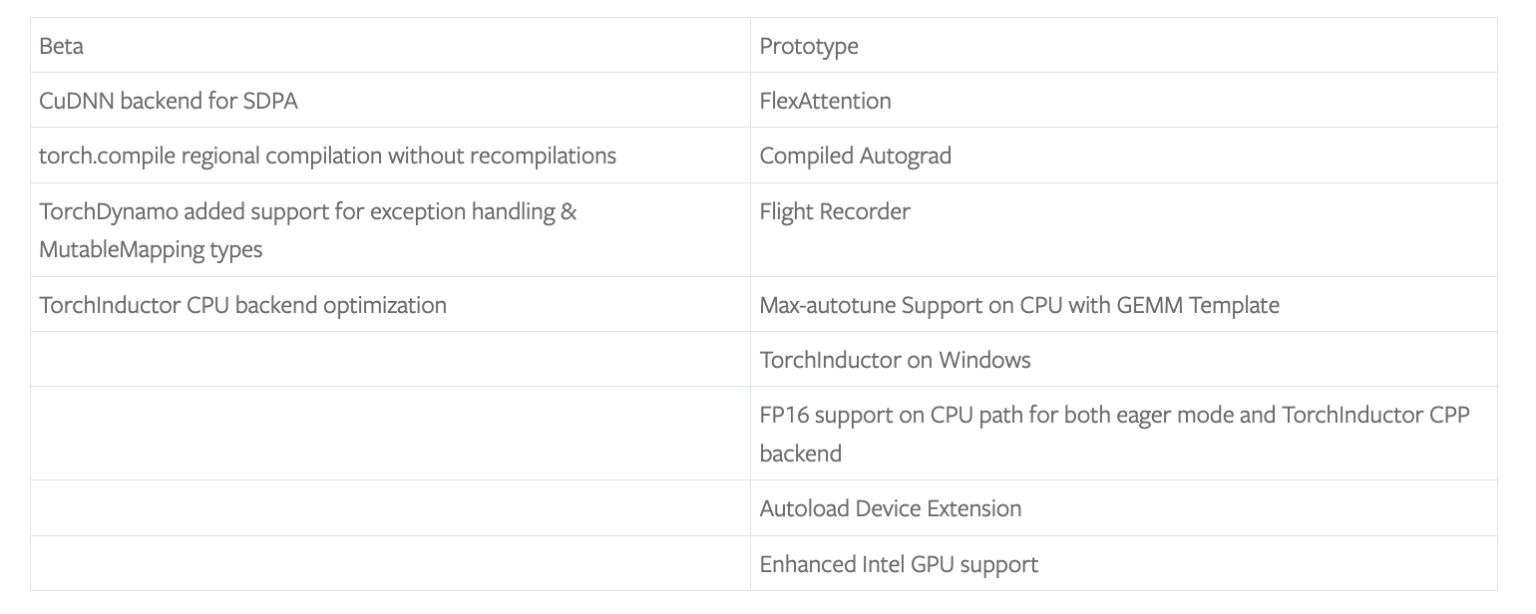

在PyTorch 2.5中,团队为这一广泛使用的深度学习框架引入了令人振奋的新功能。其中,最引人注目的改进包括为缩放点积注意力(SDPA)提供全新的CuDNN后端、推出区域编译功能torch.compile,以及引入TorchInductor CPP后端。

CuDNN后端是此次更新的亮点之一,它针对NVIDIA的H100等高端GPU进行了优化,显著提升了使用缩放点积注意力的模型(如transformer模型)的性能。用户在使用这些新型GPU时,将体验到更低的延迟和更高的吞吐量,从而加快大规模模型的训练和推理速度。

区域编译功能torch.compile则是另一个关键增强。它为用户提供了一种更模块化的编译神经网络的方法,允许用户将较小、重复的组件(如transformer层)单独编译,而非反复重新编译整个模型。这一创新极大地缩短了冷启动时间,加速了开发过程中的迭代速度。

此外,TorchInductor CPP后端也带来了诸多优化,包括FP16支持和AOT-Inductor模式等。结合max-autotune功能,TorchInductor CPP后端在分布式硬件设置上运行大型模型时,能够实现低级性能提升,为用户提供更高效的计算路径。

PyTorch 2.5之所以成为重要发布版本,原因有以下几点:

首先,CuDNN后端的引入解决了用户在高端硬件上运行transformer模型时遇到的一大难题。基准测试结果显示,H100 GPU上的性能显著提升,使用缩放点积注意力时速度加快,且用户无需额外调整即可享受这些加速效果。

其次,torch.compile的区域编译功能对于使用大型模型(如语言模型)的用户来说意义重大。这些模型通常包含许多重复的层,减少编译和优化这些重复部分所需的时间意味着更快的实验周期,使数据科学家能够更有效地迭代模型架构。

最后,TorchInductor CPP后端的推出代表了PyTorch向为需要最大控制性能和资源分配的开发人员提供更优化、更低级别体验的转变。这一变化进一步扩展了PyTorch在研究和生产环境中的可用性,满足了更多用户的需求。

总之,PyTorch 2.5是机器学习社区迈出的重要一步。它不仅符合高级可用性的要求,还优化了低级性能。通过解决GPU效率、编译延迟和整体计算速度等具体问题,PyTorch 2.5确保了其在机器学习从业者中的首选地位。聚焦SDPA优化、区域编译和改进的CPP后端,PyTorch 2.5旨在为从事前沿AI技术研究的人员提供更快、更高效的工具。随着机器学习模型的复杂性不断增长,这些更新对于推动下一波创新至关重要。