Google DeepMind推出扩散模型预测控制 (D-MPC)

模型预测控制(MPC),又称滚动视界控制,是一种先进的人工智能技术。它通过利用动力学模型和规划器,在一个规划视界内最大化目标函数,从而选择最佳行动。MPC的灵活性使其能够在测试时适应各种新颖的奖励函数,这与专注于固定奖励的政策学习方法形成鲜明对比。

为了进一步提升MPC的性能,研究人员引入了扩散模型。这些模型能够从离线数据中学习世界动态和行动序列建议,从而优化MPC的决策过程。其中,“采样、评分和排序”(Sample, Score, and Rank,SSR)方法提供了一种简单而有效的替代方案,用于优化行动选择,避免了使用更复杂的优化技术。

基于模型的方法,如Dynastyle技术,无论是在线还是离线,都致力于学习策略。而MPC方法则利用模型进行运行时规划。近年来,诸如Diffuser和Decision Diffuser等扩散方法应用联合轨迹模型来预测状态-行动序列,进一步增强了MPC的能力。这些方法通过分解动态和行动建议,增加了灵活性,并通过多步扩散建模生成轨迹级别的预测,提高了适应新环境和奖励的能力。

Google DeepMind的研究人员在此基础上提出了扩散模型预测控制(D-MPC)。这是一种将多步行动建议和动力学模型与扩散模型相结合的在线MPC方法。在D4RL基准测试中,D-MPC不仅优于现有的基于模型的离线规划方法,还与最先进的强化学习方法相媲美。更重要的是,D-MPC能够在运行时适应新的动态和优化新的奖励函数。

D-MPC的关键元素包括多步动力学、行动建议和SSR规划器。这些元素各自具备有效性,当它们结合在一起时,更是展现出了强大的性能。在规划过程中,D-MPC系统交替采取行动和利用规划器生成下一系列行动。SSR规划器对多个行动序列进行采样,并使用学习模型进行评估,最终选择最佳选项。

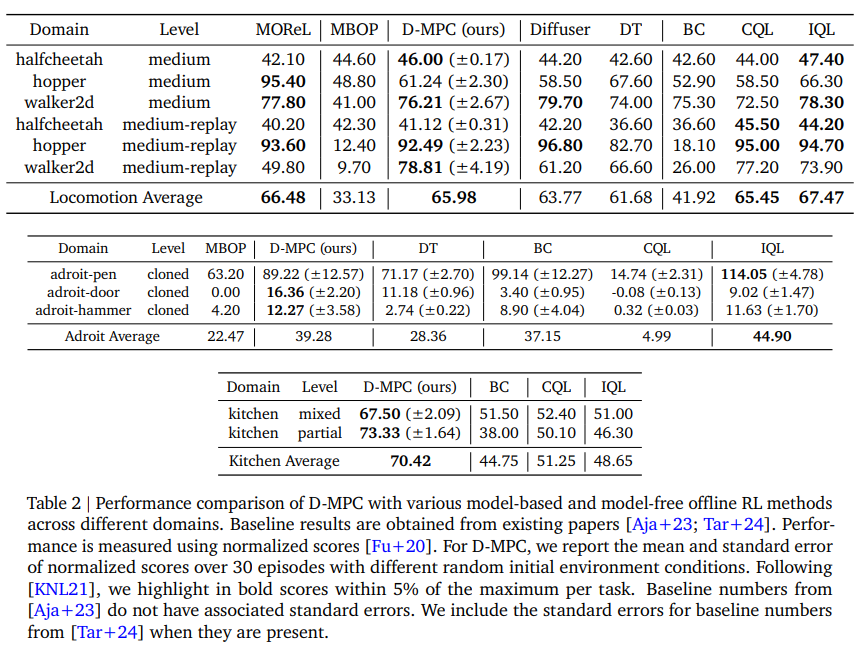

实验评估显示,D-MPC在多个方面表现出色。与离线MPC方法相比,D-MPC在性能上有所提升;同时,它还能很好地适应新的奖励函数和动态。在D4RL车辆行驶、Adroit和Franka Kitchen任务中进行测试时,D-MPC的表现优于MBOP等方法,并与Diffuser和IQL等方法不相上下。特别是在奖励和硬件缺陷方面,D-MPC展现出了良好的泛化性,经过微调后性能更是得到了显著提升。

割离性研究表明,将多步扩散模型用于行动建议和动态预测,与单步或Transformer模型相比,显著增强了长期预测准确性和整体任务性能。这一发现进一步验证了D-MPC的有效性和先进性。

综上所述,D-MPC通过使用扩散模型进行多步行动建议和动态预测,显著增强了MPC的性能。在D4RL基准测试中,D-MPC表现出色,超过了当前基于模型的规划方法,并且与最先进的强化学习方法竞争激烈。尽管D-MPC在运行时适应新的奖励和动态方面表现出色,但由于需要在每个步骤中进行重新规划,因此比反应性策略更慢。未来的工作将专注于加速采样,并使用潜在表示技术扩展D-MPC以处理像素观察数据,进一步推动人工智能技术的发展。