Meta发布可在智能手机上运行的Llama人工智能模型小型版

Meta Platforms已开发出Llama人工智能模型的较小版本,这些版本能够在智能手机和平板电脑上流畅运行,为数据中心之外的人工智能应用开启了新的可能性。

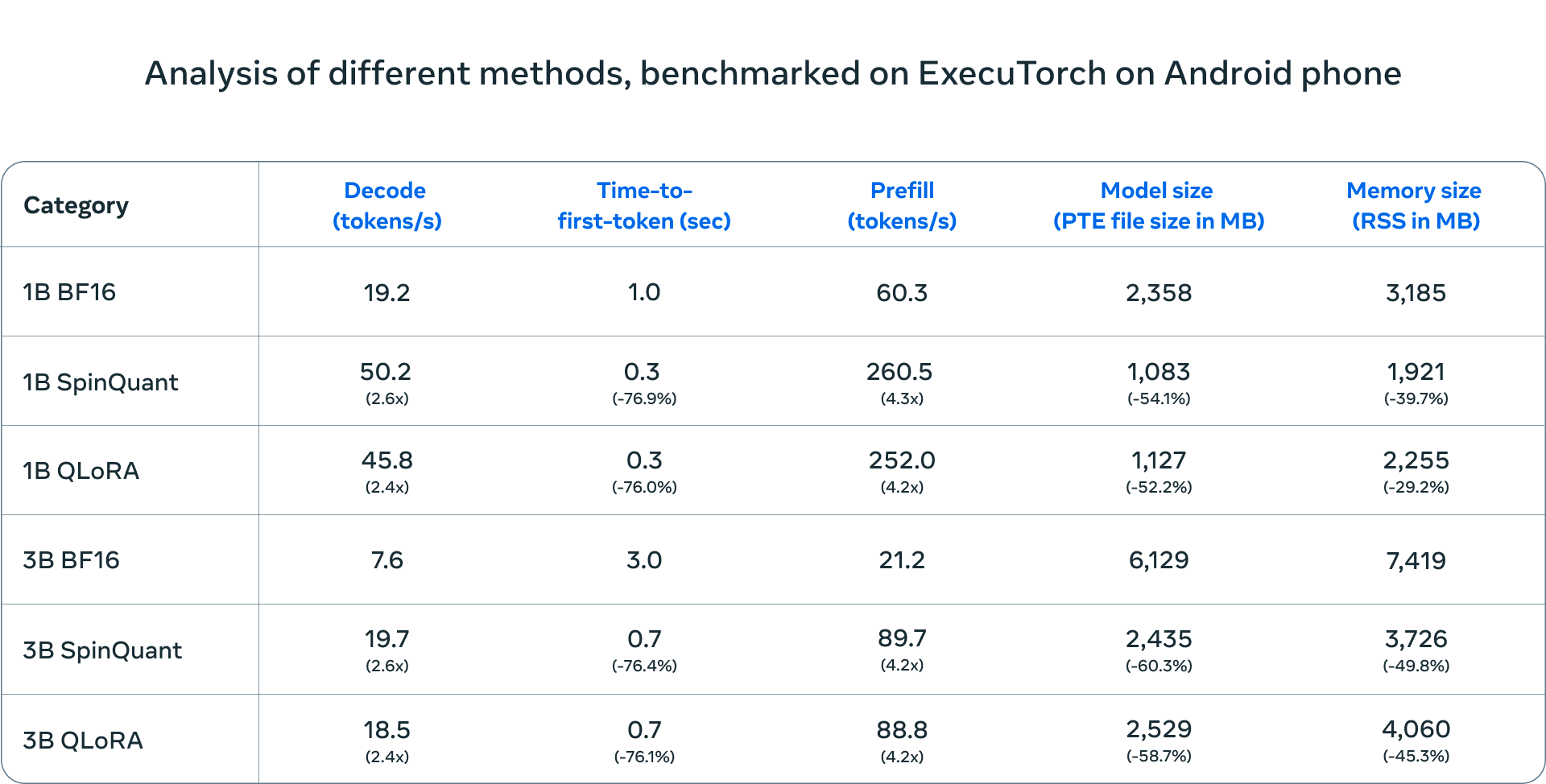

今日,Meta宣布了Llama 3.2 1B和3B模型的压缩版本。这些新版本在运行速度上提升了4倍,同时内存使用量降低至以前版本的一半以下。据Meta的测试结果显示,这些小型模型在性能上几乎与它们的大型对应模型无异。

Meta如何在移动设备上实现大型语言模型的运行

这一突破性进展得益于一种名为量化的压缩技术,该技术简化了驱动人工智能模型的数学运算。Meta结合了量化感知训练与适应器(QLoRA)以保持模型的准确性,同时引入了SpinQuant技术以提高模型的可移植性。

这项技术解决了在没有强大计算能力的情况下运行先进人工智能模型的难题。以往,复杂的人工智能模型需要依赖数据中心和专用硬件。

在OnePlus 12 Android手机上的测试中,压缩后的模型体积减小了56%,内存使用量降低了41%,同时文本处理速度提升了2倍以上。这些模型能够处理多达8000个字符的文本,足以满足大多数移动应用的需求。

科技巨头争夺移动设备上人工智能的未来

Meta的这一发布加剧了科技巨头之间在控制移动设备上人工智能运行方式上的战略竞争。与谷歌和苹果采取的谨慎、受控策略不同,Meta选择了更加开放的路径。

通过开源这些压缩模型,并与芯片制造商高通和联发科建立合作,Meta绕过了传统的平台守门人。这意味着开发人员无需等待谷歌的Android更新或苹果的iOS功能,即可构建人工智能应用。这一举措与移动应用早期阶段的开放平台策略相呼应,大大加速了创新进程。

与高通和联发科的合作尤为重要,因为这些公司为世界上大多数Android手机提供动力,包括Meta认为具有增长潜力的新兴市场的设备。通过优化其模型以适应这些广泛使用的处理器,Meta确保其人工智能能够在不同价格区间的手机上高效运行,而不仅限于高端设备。

Meta通过其Llama网站和有影响力的AI模型中心Hugging Face进行分发的决定,展示了其致力于在开发人员已经工作的领域触达开发人员的承诺。这种双重分发策略可能有助于Meta的压缩模型成为移动人工智能开发的事实标准,正如TensorFlow和PyTorch在机器学习领域所取得的地位一样。

AI在你口袋里的未来

Meta今日的公告预示着人工智能领域的一次重大转变:从集中式计算向个人计算转移。虽然基于云的人工智能将继续处理复杂任务,但这些新模型揭示了未来的一种可能性,即手机能够私密且快速地处理敏感信息。

时机至关重要。科技公司面临着数据收集和人工智能透明性的压力。Meta的方法——使这些工具开放并直接在手机上运行——同时解决了这两个问题。你的手机,而不是远程服务器,很快就能处理文件摘要、文本分析和创作等任务。

这与计算领域的其他关键转变相呼应。处理能力从主机移动到个人电脑,再从台式机转移到智能手机,现在人工智能似乎正准备在个人设备上迎来其转变。Meta押注于开发人员将接受这种改变,创造出将移动应用的便利性与人工智能的智能相结合的应用。

然而,成功并非必然。这些模型仍然需要强大的手机才能良好运行。开发人员必须在隐私的好处与云计算的强大计算能力之间做出权衡。同时,Meta的竞争对手,尤其是苹果和谷歌,也有自己对移动设备上人工智能未来的愿景。

但有一点是明确的:人工智能正在逐步摆脱数据中心的束缚,一步一个脚印地走向手机。