OpenAI音频转录工具Whisper被曝编造大量内容,引发担忧

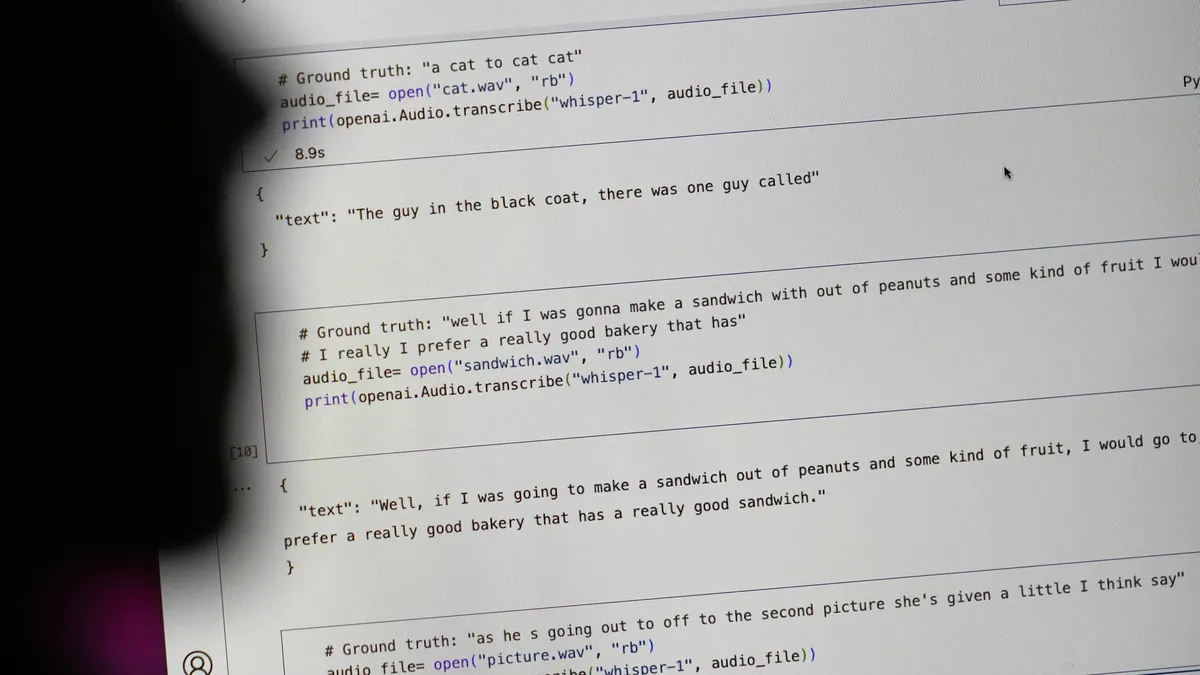

近日,一份新报告揭示了OpenAI的音频转录工具Whisper存在的问题:该工具正在编造从未说过的内容,这可能带来危险的后果。据美联社报道,这一人工智能模型在其训练材料中识别到并不存在的模式,从而生成无意义的输出,这一现象通常被称为“幻觉”。

美国研究人员发现,Whisper的错误可能包括种族评论、暴力和幻想的医疗治疗等。尽管Whisper已集成到某些版本的ChatGPT中,并且是微软和甲骨文云计算平台中的内置产品,但研究人员警告不要使用,因为他们在不同的研究中发现了这些问题。

在一项关于公开会议的研究中,密歇根大学的一位研究人员发现,在检查的10个音频转录中,Whisper有8个出现了幻觉。同时,一位机器学习工程师在超过100小时的转录中也发现了约一半的幻觉,另一位开发者更是发现他用Whisper创建的26000个转录中几乎每一个都有幻觉。

上个月,Whisper在开源AI平台HuggingFace上被下载超过420万次,成为该网站上最受欢迎的语音识别模型。然而,在分析由卡内基梅隆大学托管的TalkBank材料时,研究人员确定Whisper产生的40%的幻觉可能是有害的,因为演讲者被“误解或错误陈述”了。

美联社的报道中举了几个例子,其中一位演讲者描述了“两个女孩和一位女士”,而Whisper却发明了种族评论,指出“两个女孩和一位女士,呃,她们是黑人”。在另一个例子中,该工具创造了一种虚构的药物,称为“超活化抗生素”。

普林斯顿大学教授阿隆德拉·尼尔森在接受美联社采访时表示,像这样的错误可能会造成“非常严重的后果”,特别是在医疗环境中,因为“没有人希望误诊”。有人呼吁OpenAI解决此问题,前雇员威廉·桑德斯告诉美联社称:“如果你将这个工具推出并且人们对它过于自信,并将其集成到所有其他系统中,那就是个问题。”

对于AI转录工具来说,幻觉是一个普遍存在的问题。尽管许多用户预料到AI工具会出错或拼写错误,但研究人员发现其他程序与Whisper一样存在出错的情况。例如,谷歌的AI综述在今年早些时候受到批评,因为它建议使用无毒胶水防止披萨上的奶酪掉落,并引用了一条讽刺的Reddit评论作为来源。

苹果公司首席执行官蒂姆·库克在接受采访时也承认,AI幻觉可能是未来产品中的一个问题,包括Apple Intelligence套件。库克告诉《华盛顿邮报》,他对这些工具是否可能出现幻觉的信心并不是100%。尽管如此,公司仍在推进AI工具和程序的发展。

至于OpenAI对幻觉的回应,它建议不要在“决策背景下使用Whisper,因为准确性中的缺陷可能导致结果中的明显缺陷。”这一事件再次引发了人们对AI技术准确性和可靠性的担忧,也提醒了相关公司在推进AI技术发展的同时,需要更加谨慎地处理潜在的问题和风险。