微软发布全新AI模型OmniParser,引领GUI代理技术革新

近日,微软在其AI前沿博客上宣布了一项重要进展:全新AI模型OmniParser正式发布。这一完全基于视觉的图形用户界面(GUI)代理,已经在Hugging Face平台上以MIT许可证开放发布,引起了业界的广泛关注。

OmniParser的发布,标志着微软在AI代理行业的领先地位进一步得到巩固。这一技术成果,无疑借鉴了微软在自主AI代理领域的深厚积累与卓越成就。值得一提的是,早在今年9月,微软就已携手Oracle和Salesforce,共同加入了AI代理劳动力超级联赛,展现出其在AI领域的前瞻布局和雄心壮志。

据悉,OmniParser的研发工作并非一蹴而就。早在2024年3月,阿里巴巴集团和华中科技大学的万建强等人就在一篇研究论文中,首次提出了OmniParser的概念,将其构想为一个集文本识别、关键信息提取和表格识别于一体的统一框架。经过数月的研究与优化,今年8月,微软正式发布了关于OmniParser的详细论文,详细介绍了其作为纯粹基于视觉的GUI代理的技术特点与优势。

在Hugging Face平台上,OmniParser被描述为一个多功能工具,能够轻松将用户界面的截图转化为数据,并显著增强大型语言模型(LLM)对界面的理解能力。此次发布还包含了两种类型的数据集,分别用于检测可点击的图标和描述每个图标的功能及UI元素的意义,为OmniParser的广泛应用提供了坚实的数据支撑。

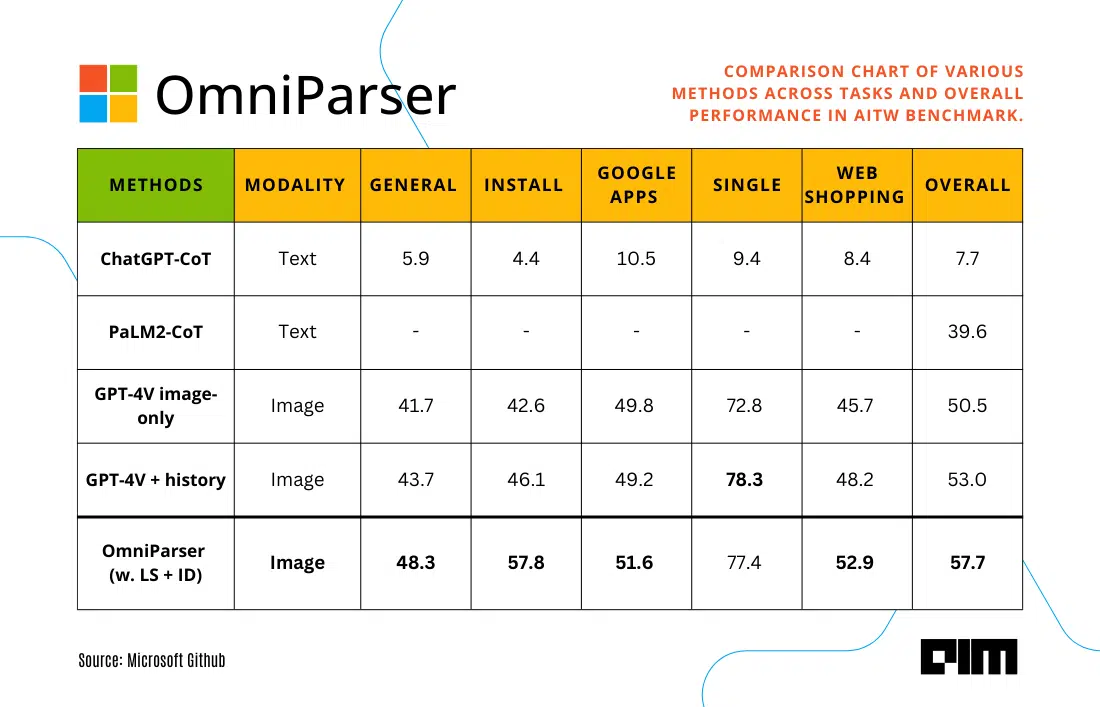

在性能测试方面,OmniParser展现出了卓越的表现。在SeeClick、Mind2Web和AITW等多个基准测试中,OmniParser的性能均超过了GPT-4V和OpenAI的具有视觉功能的GPT-4,充分证明了其技术的先进性和实用性。

为了与当前基于视觉的LLM兼容,OmniParser与最新的Phi-3.5-V和Llama-3.2-V模型进行了结合使用。测试结果显示,与未经微调的Grounding DINO模型相比,经过微调的可交互区域检测模型(ID)在所有类别的任务性能上都有显著提升。这一性能提升得益于OmniParser的“本地语义”(LS)技术,该技术能够将每个图标的功能与其目的相关联,从而增强了GPT-4V、Phi-3.5-V和Llama-3.2-V的性能。

在与GPT-4V的整合方面,OmniParser同样展现出了巨大的潜力。随着各种LLM的使用激增,对于用户界面中不同功能的增强AI代理需求也日益旺盛。然而,由于屏幕解析技术的不足,像GPT-4V这样的模型在操作系统中作为通用代理的潜力常被低估。然而,根据ScreenSpot基准测试的结果,OmniParser极大地提升了GPT-4V在与界面相关区域正确对齐的生成动作的能力,为GPT-4V在操作系统中的应用开辟了新的可能。

这一成果也得到了另一篇由微软研究人员与卡内基梅隆大学和哥伦比亚大学合作撰写的论文的支持。该论文展示了在与GPT-4V整合的OmniParser中使用最佳性能进行规模化的多模式操作系统代理的“Windows Agent Arena”测试,进一步验证了OmniParser的实用性和前景。

微软OmniParser的发布,无疑为AI代理技术的发展注入了新的活力。未来,随着技术的不断成熟和应用场景的不断拓展,OmniParser有望在更多领域发挥重要作用,为人们的生活和工作带来更多便利和效率。