Graphusion:用零样本LLM构建非结构化文本知识图谱

许多基于大型语言模型(LLM)的知识图谱构建(KGC)框架侧重于局部视角,仅从单个句子或文档中提取知识三元组,缺少一个融合过程来将知识整合到一个全局知识图谱中。

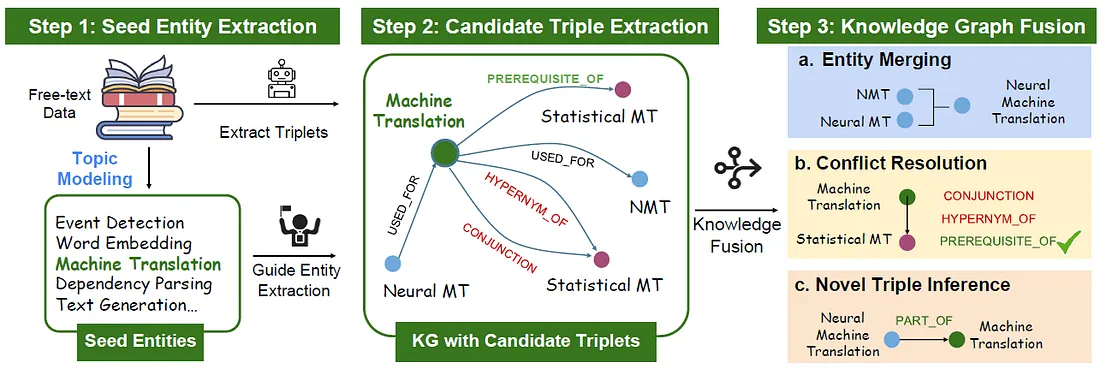

本文介绍了Graphusion,这是一个从零文本开始的零样本KGC框架。它包含三个步骤:第一步,我们使用主题建模提取一系列种子实体,以指导最终的知识图谱包含最相关的实体;第二步,我们使用LLM进行候选三元组提取;第三步,我们设计了新颖的融合模块,该模块提供了提取知识的全局视图,包括实体合并、冲突解决和新三元组发现。

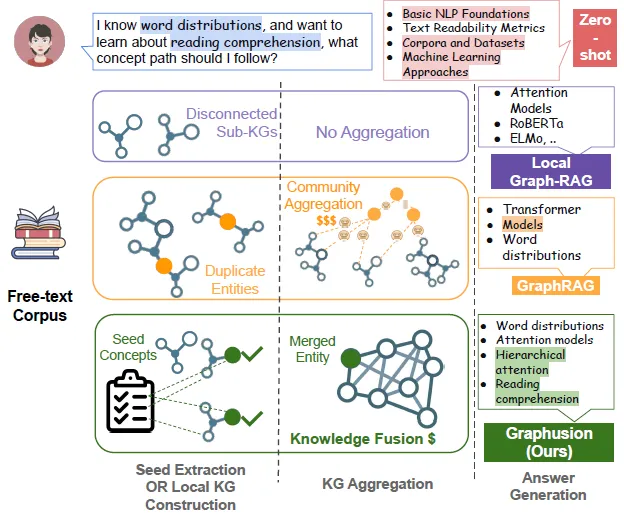

下图展示了零样本LLM、局部图-RAG、GraphRAG和Graphusion框架在将LLM应用于KGC时的差异。局部图-RAG主要从孤立的角度关注知识提取,而GraphRAG能够从全局视角总结信息。然而,我们的方法Graphusion则包含了一个知识融合步骤,能够直接将局部知识整合到全局上下文中。

Graphusion:零样本知识图谱构建

介绍了用于构建科学知识图谱的Graphusion框架,如下图所示:

这种方法解决了零样本知识图谱构建(KGC)中的三个关键挑战:

- 输入由自由文本而非预定义的实体列表组成。

- 关系包含多种类型,且它们之间可能存在冲突。

- 输出不是单一的二进制标签,而是一系列三元组,这使得评估更具挑战性。

i) 问题定义

- 知识图谱(KG)定义为一系列三元组的集合KG = {(hi, ri, ti) | hi, ti ∈ E, ri ∈ R, i = 1, 2, ..., n},其中E是实体集合,R是可能的关系集合,n是KG中三元组的总数。

- 零样本KGC的任务是接收一组自由文本T,并生成跨越KG的一系列三元组(h, r, t)。

- 定义了7种关系类型:先决条件、用于、比较、连接、下位词、评估为和部分。

ii) 步骤1:种子实体生成

- 采用种子实体生成方法,从自由文本中高效提取领域内实体。

- 使用BERTopic进行主题建模,以识别每个主题的代表性实体。这些代表性实体作为种子实体,表示为Q。

- 初始化的种子实体确保了实体提取的高相关性,并为后续的三元组提取提供了一定的精确度。

iii) 步骤2:候选三元组提取

- 步骤1中获得的种子实体将指导我们进行实体提取。

- 首先指示大型语言模型(LLM)提取领域内实体,然后识别这些实体与q之间可能的关系。

- 然后,我们要求LLM发现新的三元组,即使q最初并未包含在内。这种方法确保了种子实体在指导领域内实体提取方面发挥主导作用。

- 设计提取提示如下:

Given a context {context} and a query entity {query}, do the following:

1. Extract the query entity and in-domain entities from the context,

which should be fine-grained...

2. Determine the relations between the query entity and the extracted

entities, in a triplet format:(<head entity>, <relation>, <tail entity

>)...

{Relation Definition}

3. Please note some relations are strictly directional...

4. You can also extract triplets from the extracted entities, and the

query entity may not be necessary in the triplets.- 在处理完来自种子实体列表的所有查询后,我们保存所有候选三元组。我们将这个由LLM零样本构建的知识图谱表示为ZS-KG。

iv) 知识图谱融合

- 上一步提取的三元组提供了每个查询实体的局部视图,而非全局视角。

- 在两个实体之间提取的关系可能是冲突的、多样的或错误的,例如(神经摘要方法,用于,抽象式摘要)和(神经摘要方法,下位词,抽象式摘要),这将在融合步骤中解决。

- 融合方法有助于调和冲突的关系,有效地整合多样或错误的关系,并最终提供对实体对的全局理解。

- 对于每个查询实体q,我们首先从ZS-KG中查询,并获得一个包含q的子图:

LLM-KG = {(h, r, t) ∈ ZS-KG | h = q 或 t = q}

- 可选地,如果有一个专家标注的知识图谱GE可用,我们也将查询一个子图,标记为E-G。

- 此外,我们再次从自由文本({背景})中对q进行动态检索,以帮助LLM更好地理解如何解决冲突的三元组。

融合步骤侧重于三个部分:

- 实体合并:合并语义上相似的实体,例如NMT与神经机器翻译;

- 冲突解决:对于每对实体,解决任何冲突并选择最佳的一个;以及

- 新颖三元组推理:从背景文本中提出新的三元组。

使用以下融合提示:

Please fuse two sub-knowledge graphs about the entity: {entity}.

Graph 1: {LLM-KG}

Graph 2: {E-G}

Rules for Fusing the Graphs:

1. Union the entities and edges.

2. If two entities are similar, or refer to the same entity, merge

them into one entity, keeping the one that is meaningful or specific.

3. Only one relation is allowed between two entities. If a conflict exists,

read the ### Background to help you keep the correct relation...

4. Once step 3 is done, consider every possible entity pair not covered in

step 2. For example, take an entity from Graph 1, and match it with a

entity from Graph 2. Then, please refer to ### Background to summarize

new triplets.

### Background:

{background}

{Relation Definition}实验

i) 知识图谱构建

a) 数据集

选取2017年至2023年ACL会议的程序论文,共包括4605篇有效论文。

b) 实现

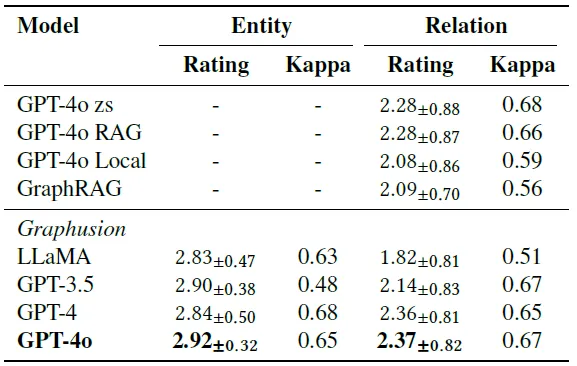

在四种不同的大型语言模型(LLM)设置上实现Graphusion:LLaMa3-70b、GPT-3.5、GPT-4和GPT-4o。

c) 基线

与局部图模型(GPT-4o Local)进行比较,该模型等同于没有融合步骤(步骤3)的Graphusion模型。

d) 结果

下表显示了评分和专家的一致性分数。

在所有测试的方法中,基于GPT-4o的Graphusion在实体和关系评分方面均取得了最高性能。

值得注意的是,当省略融合步骤时,性能从2.37显著下降到2.08,这表明融合步骤在提升Graphusion中关系质量方面起着至关重要的作用。

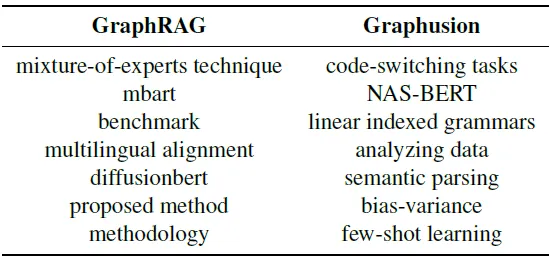

e) 案例分析:实体提取

我们检查了由GraphRAG和Graphusion提取的一组随机实体,结果基于GPT-4o作为主干模型,如下图所示

GraphRAG有时会提取过于笼统的术语,如“benchmark(基准)”和“methodology(方法)”,这些术语在语料库中频繁出现。在后续实验中

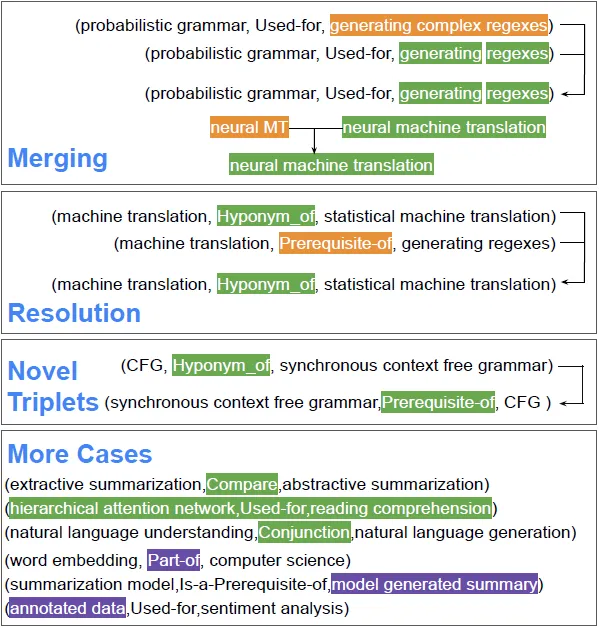

f) 案例分析:融合

下图展示了基于GPT-4o模型的Graphusion的案例分析:正确的部分用绿色高亮显示,已解决和合并的部分用橙色高亮显示,而不太准确的部分则用紫色高亮显示。

我们的融合步骤合并了相似的实体(如“neural MT”和“neural machine translation”),并解决了关系冲突(如“Prerequisite_of”和“Hyponym_of”)。此外,它还能够推断出输入中不存在的新颖三元组。

然而,在实体识别方面,它可能会输出不太准确的三元组,例如粒度较差的实体(如“annotated data”、“model generated summary”)和识别出非常远的关系(如将“word embedding”归类为计算机科学的一部分)。

ii) 链接预测

- 给定一个实体对(A, B),任务是确定两个给定实体之间是否存在关系r。例如,要学习POS标注的实体,必须先了解Viterbi算法。最初,会提供一个预定义的实体集C。

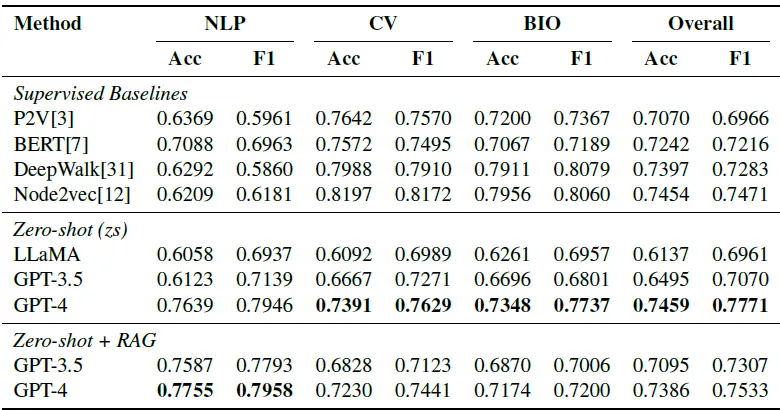

- 我们设计了一个LP提示来解决这个任务,并在一个科学基准数据集LectureBankCD上进行了全面评估,该数据集包含三个领域(NLP、计算机视觉(CV)和生物信息学)中的实体对和先决条件标签。

- 下表显示了LectureBankCD测试集上所有领域的链接预测结果,包括报告的准确率(Acc)和F1分数。

LLM方法优于传统的监督学习基线,这表明LLM在知识图谱构建方面,尤其是关系预测方面,具有实现更高质量的潜力。

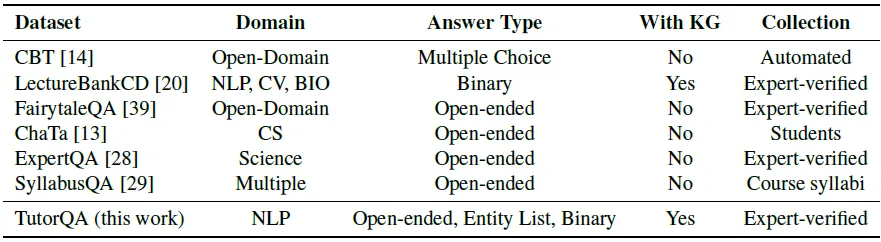

TutorQA:科学知识图谱问答基准

- 本文介绍了TutorQA基准,这是一个为科学知识图谱问答(KG QA)设计的问答数据集。

- TutorQA包含六个类别,总共有1200个经过人类专家验证的问答对,这些问题模拟了课堂上通常遇到的问题。

- 这些问题超越了简单的课程大纲询问,涵盖了更复杂和具有挑战性的主题,这些主题需要知识图谱推理,以及文本理解和问答方面的熟练度。

- 下表显示了与其他类似基准的比较:教育或通用问答基准。

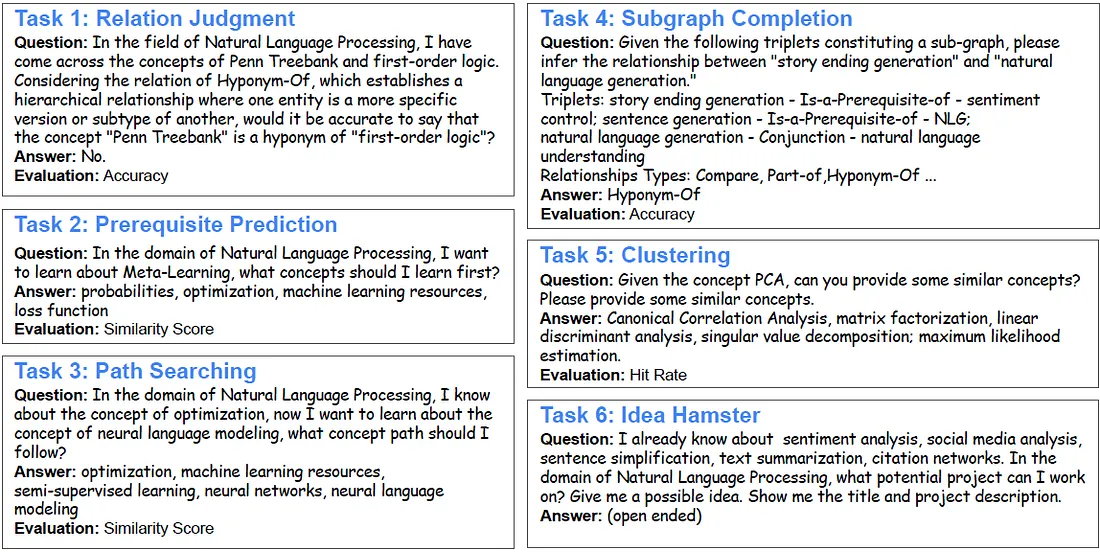

设计不同难度级别的问题,并将它们分为6个任务,下图总结了这些任务并给出了示例数据:

i) 任务

任务包括:

- 任务1:关系判断。该任务是评估连接两个实体的给定三元组是否准确。

- 任务2:先决条件预测。此任务通过为学生规划出他们需要先学习的关键实体,以帮助他们理解复杂的目标主题。

- 任务3:路径搜索。此任务通过从图中绘制路径,帮助学生识别理解新目标实体所需的一系列中介实体。

- 任务4:子图补全。该任务涉及通过识别子图中实体之间的隐藏关联来扩展知识图谱。

- 任务5:相似实体。此任务要求识别与核心思想相关联的实体,以加深理解和增强学习,从而有助于创建相互关联的课程。

- 任务6:创意激发者。此任务鼓励参与者将所学的实体应用到实际情境中,开发项目提案,并提供示例和成果来激发创造力。

ii) 结果

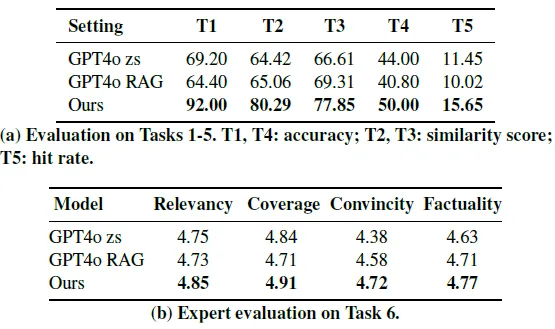

下表中的分析比较了基于Graphusion和两个基线(包括GPT-4o零样本(zs)和带有RAG的GPT-4o(RAG))的结果。

我们的方法结合Graphusion构建的知识图谱在任务1到任务6中相较于基线方法均表现出显著提升。

iii) 案例研究:任务2和任务3(实体数量)

在下图中,我们评估了GPT-4o零样本(zs)和我们的Graphusion框架在任务2和任务3的回应中创建的实体平均数量。这两个任务都要求模型给出一系列合理的实体。

结果显示,在没有知识图谱检索信息的增强下,GPT-4o在生成的回应中倾向于提及更多的实体(任务2:11.04个,任务3:11.54个),这些实体可能是不相关的或过于宽泛的。

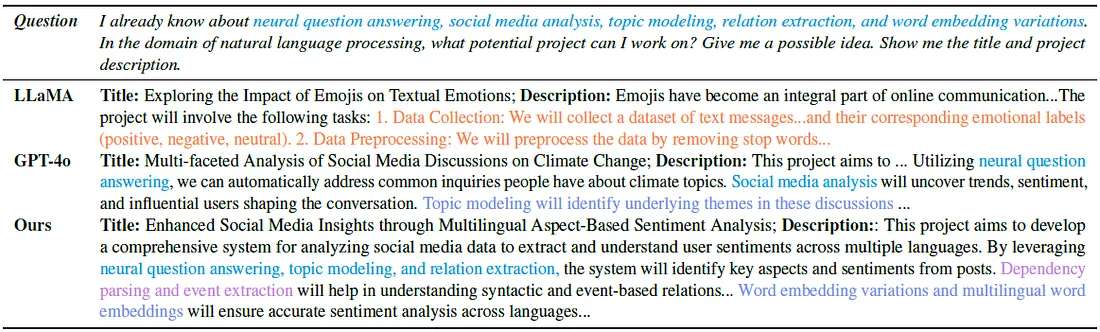

iv) 案例研究:任务6(答案中扩展的相关实体)

下表展示了TutorQA任务6的案例研究:LLaMA、GPT-4o以及我们结合Graphusion构建的知识图谱的流水线方法(部分)。

借助Graphusion构建的知识图谱,模型提供了一个更加全面的解决方案,它不仅详细阐述了初始查询的实体,还引入了从恢复的图(如依赖解析和事件抽取)中获取的额外实体(以淡紫色突出显示)。

结论

我们提出了Graphusion,该方法利用大型语言模型(LLMs)从自由文本中构建科学知识图谱。通过三个关键步骤:种子实体生成、候选三元组提取和知识图谱融合,Graphusion从全局视角构建知识图谱,解决了传统知识图谱构建(KGC)方法的局限性。