OpenAI开源SimpleQA新基准,测试AI语言模型回答准确性

近日,一项由OpenAI进行的新研究揭示了AI语言模型在回答事实问题时的局限性。该研究利用OpenAI自家的SimpleQA基准测试,对多个先进的AI语言模型进行了评估,结果却令人惊讶。

SimpleQA测试涵盖了科学、政治和艺术三个领域的4,326个问题,每个问题都经过精心设计,确保只有一个明确的正确答案。为了验证答案的准确性,还邀请了两位独立的评审人员进行审核。

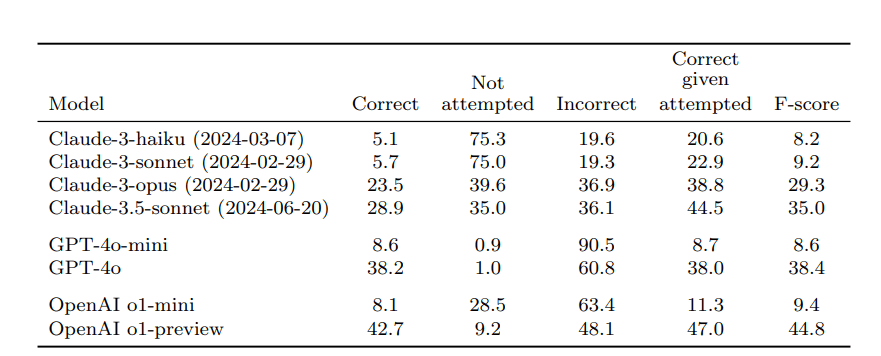

然而,即便是OpenAI的最佳模型o1-preview,在测试中的成功率也仅为42.7%。紧随其后的是GPT-4o模型,其正确率为38.2%,而更小的GPT-4o-mini模型的准确率更是低至8.6%。同样参与测试的Anthropic公司的Claude模型表现也不尽如人意,其顶级模型Claude-3.5-sonnet的正确率仅为28.9%,错误率高达36.1%。

这项测试专门衡量的是AI模型在训练过程中获得的知识,而不涉及模型在获得额外上下文、互联网访问或数据库连接时提供正确答案的能力。因此,研究人员强调,用户应将AI模型视为信息处理器,而非独立的知识来源。为了获得最佳结果,最好提供可靠的数据,而不是仅仅依赖AI模型内置的知识。

这一研究结果引发了广泛的担忧。许多人,尤其是学生,正在将这些AI系统作为独立的研究和学习工具,因为他们相信这些系统大多数情况下能给出准确答案。然而,测试结果表明,这种做法存在很大的风险。数据显示,AI模型在独立进行事实查证或验证方面根本不够可靠。

此外,研究还发现,AI语言模型在回答问题时明显高估了自己的能力。当研究人员要求模型对自己的答案进行评分时,AI模型总是给出过高的准确性得分。为了系统地衡量这种过度自信,研究人员让模型对每个问题重复回答多次,结果发现,即使模型重复给出相同的答案,其实际成功率仍然低于模型对自身性能的预测。

这一发现进一步加剧了人们对AI语言模型可靠性的担忧。许多专家呼吁,在使用AI模型时,应保持谨慎,并结合其他可靠的信息来源进行验证。同时,研究人员也将继续努力,提高AI模型的准确性和可靠性,以更好地服务于人类社会。