Nvidia研发小型神经网络,高效控制人形机器人

2024年10月31日 由 daydream 发表

519

0

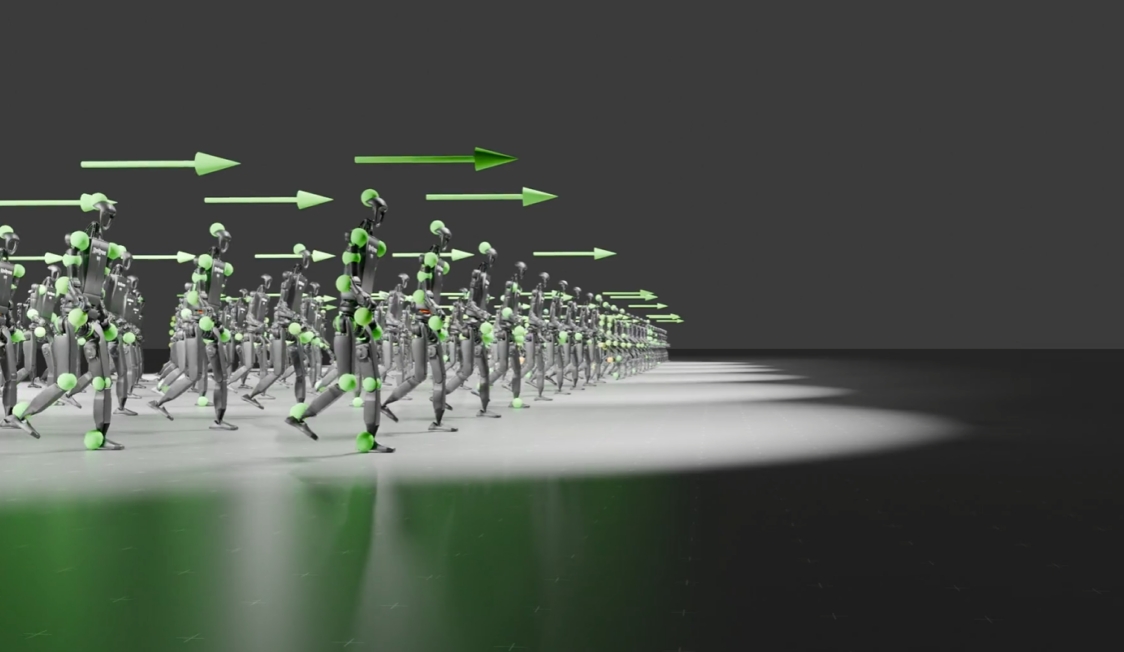

Nvidia的研究人员开发了一种小型神经网络,该网络在控制人形机器人方面表现优于专业系统,同时资源消耗却远低。该系统支持多种输入方式,包括虚拟现实(VR)头盔和动作捕捉技术。

这款名为HOVER的新系统,仅需150万参数即可处理复杂的机器人动作。相比之下,常见的大型语言模型则使用数百亿参数。

研究团队在Nvidia的Isaac模拟环境中对HOVER进行了训练,该环境可将机器人动作加速10000倍。据Nvidia研究人员Jim Fan介绍,这意味着在虚拟空间中一年的训练时间,在实际计算中仅需一个图形处理器(GPU)50分钟即可完成。

HOVER系统具有小巧且多功能的特点。Fan表示,HOVER无需微调即可实现从模拟环境到实体机器人的零样本迁移。该系统可接受来自多个来源的输入,包括来自Apple Vision Pro等扩展现实(XR)设备的头部和手部追踪、来自动作捕捉或RGB摄像头的全身位置、来自外骨骼的关节角度以及标准操纵杆控制。

在使用每种控制方法时,HOVER的表现均优于专为单一输入类型构建的系统。论文第一作者Tairan He推测,这可能是因为该系统对平衡和精确肢体控制等物理概念有广泛的理解,并将其应用于所有控制类型。

HOVER系统基于开源的H2O和OmniH2O项目构建,可与任何能在Isaac模拟器中运行的人形机器人配合使用。Nvidia已在GitHub上发布了相关示例和代码。

文章来源:https://the-decoder.com/nvidia-trains-a-tiny-ai-model-that-controls-humanoid-robots-better-than-specialists/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消