GSM-Symbolic:探讨LLM数学推理局限与解决方案

介绍

大型语言模型(LLM)最近在人工智能推理方面取得了重大进展,包括数学问题解决能力。然而,Mirzadeh等人最近发表的一篇题为《GSM-Symbolic:了解大型语言模型在数学推理方面的局限性》的论文对这些模型在数学推理方面的真正能力提出了质疑。但我们的分析表明,其结论可能并未完全捕捉到这一问题的复杂性。

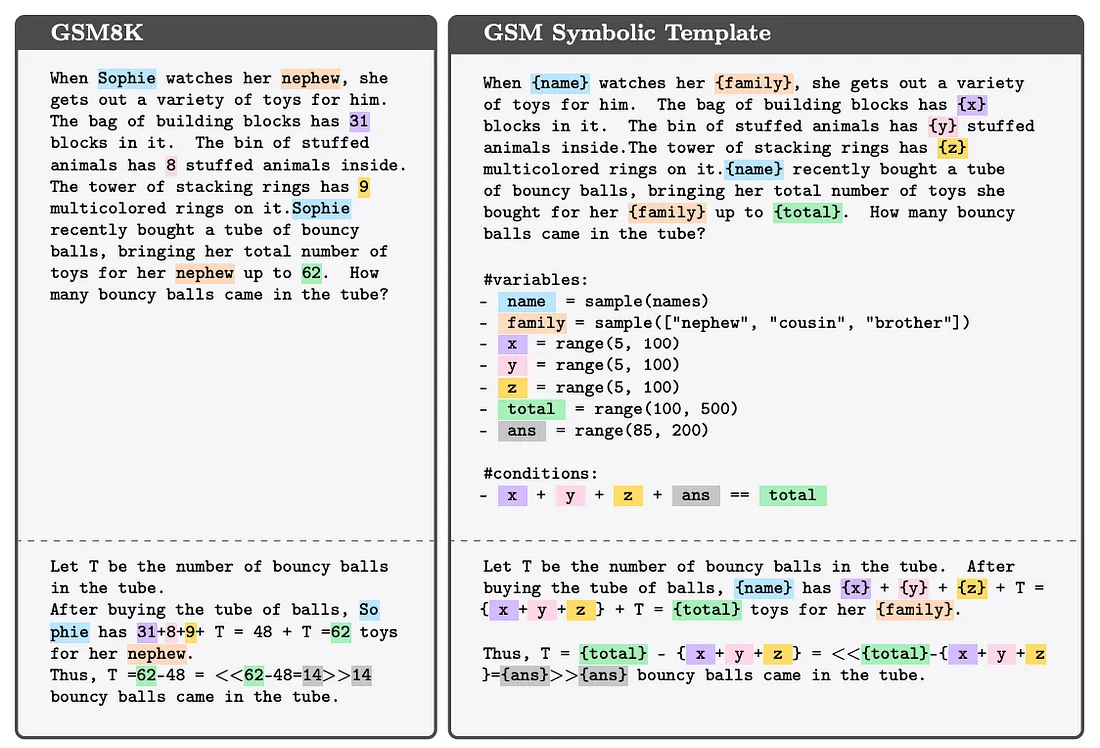

GSM-Symbolic基准测试

作者介绍了GSM-Symbolic,这是一个源自流行的GSM8K数据集的增强型基准测试。这个新的基准测试可以生成多样化的问题变体,从而能够更细致地评估LLM在各种设置下的表现。该研究对25个最先进的开放和封闭模型进行了大规模分析,为这些模型在面对数学推理任务时的表现提供了重要见解。

性能可变性和模型比较

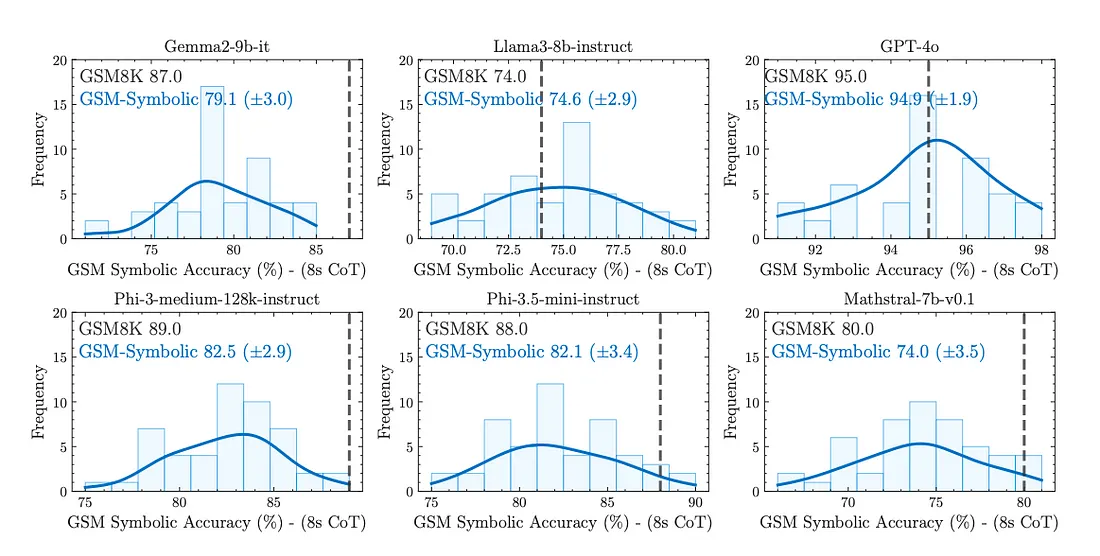

最令人惊讶的发现之一是,同一问题的不同实例化之间模型性能存在高度可变性。在GSM-Symbolic上进行测试时,所有模型都表现出“准确性方面的显著可变性”。这种可变性引发了人们对目前基于GSM8K基准测试所报告指标的可靠性的担忧,因为该基准测试依赖于单点准确性响应。

并非所有模型的性能都相同。Llama-3–8b和GPT-4o显然是例外,因为与gemma-2–9b、phi-3、phi-3.5和mathstral-7b等其他模型相比,它们在新基准测试上的表现下降并不那么显著。这一观察结果揭示了两个重要观点:

- 尽管Llama-3–8b和GPT-4o仍然无法避免性能波动,但它们通常表现出对数学概念更为稳健的理解。

- Llama-3–8b和GPT-4o的训练数据很可能没有(或者至少没有同样程度地)被GSM8K数据污染。在此背景下,数据污染指的是在模型的训练集中无意中包含了测试或基准测试数据,导致在评估期间模型性能被人为抬高。如果发生污染,正如作者对一些模型的假设那样,我们预期在GSM8K上会看到非常高的性能,但在这些问题的轻微变化上性能会显著下降。

这些发现突显了通过使用合成数据来改进的机会,其中妥善设计的合成数据集可以解决任何训练模型者面临的这两个问题:

- 为了缓解潜在的数据污染问题,当可以生成高质量的合成版本时,就没有必要在训练中使用原始的GSM8K数据(博客链接)。这些合成数据集保留了GSM8K的数学推理挑战,同时没有重复使用完全相同的问题或解决方案,从而保持了模型评估的完整性。

- 更重要的是,可以生成质量超过OpenAI的GSM8K和苹果的GSM-Symbolic数据集的合成数据。这种方法可以带来更稳健的数学概念理解,解决当前模型中观察到的性能可变性。

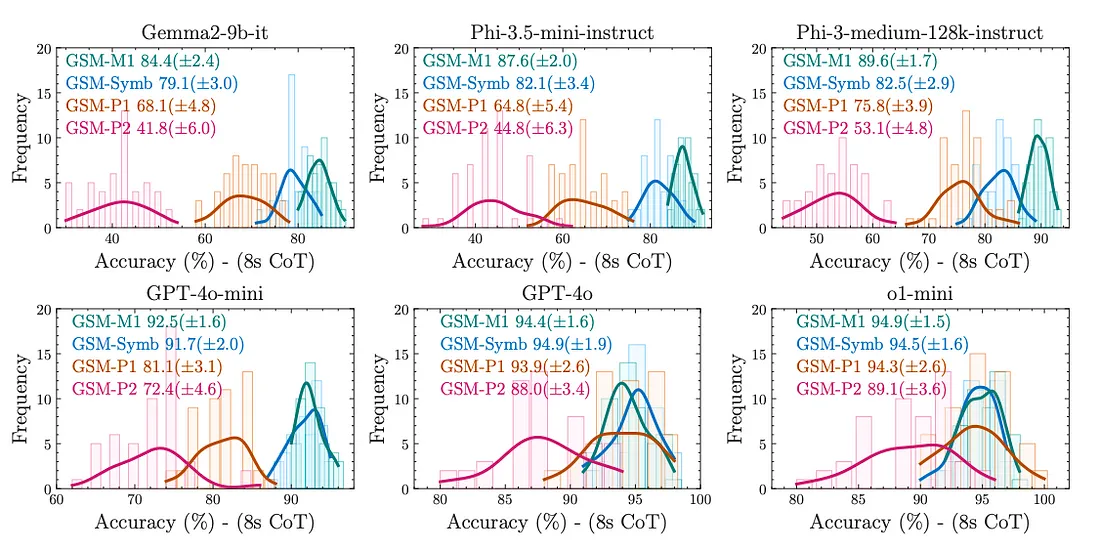

对变化和复杂性的敏感性

作者表明,大型语言模型对问题中数值的变化比对专有名词的变化更敏感,这表明模型对基础数学概念的理解可能并不像之前认为的那么稳健。随着问题复杂性的增加(以子句数量衡量),所有模型的性能都会下降,且性能差异也会增大。这强调了在训练中使用多样化数据的重要性,而合成数据可以帮助实现这一点。正如作者所证明的,从逻辑上讲,没有理由认为AI模型在仅仅因为数字的简单变化或子句数量的轻微变化而在一组特定问题上的表现更差。

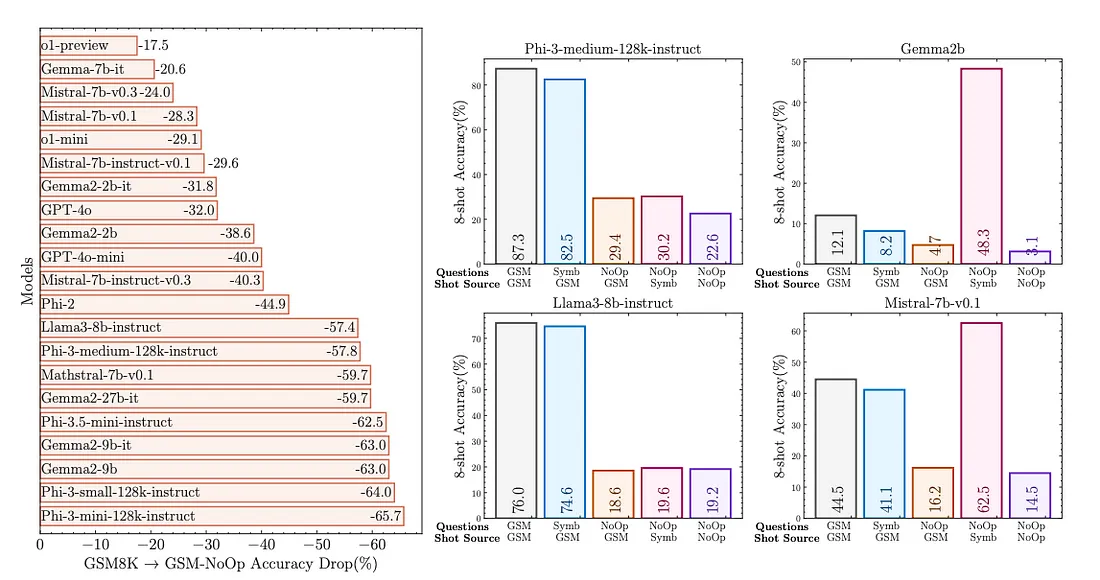

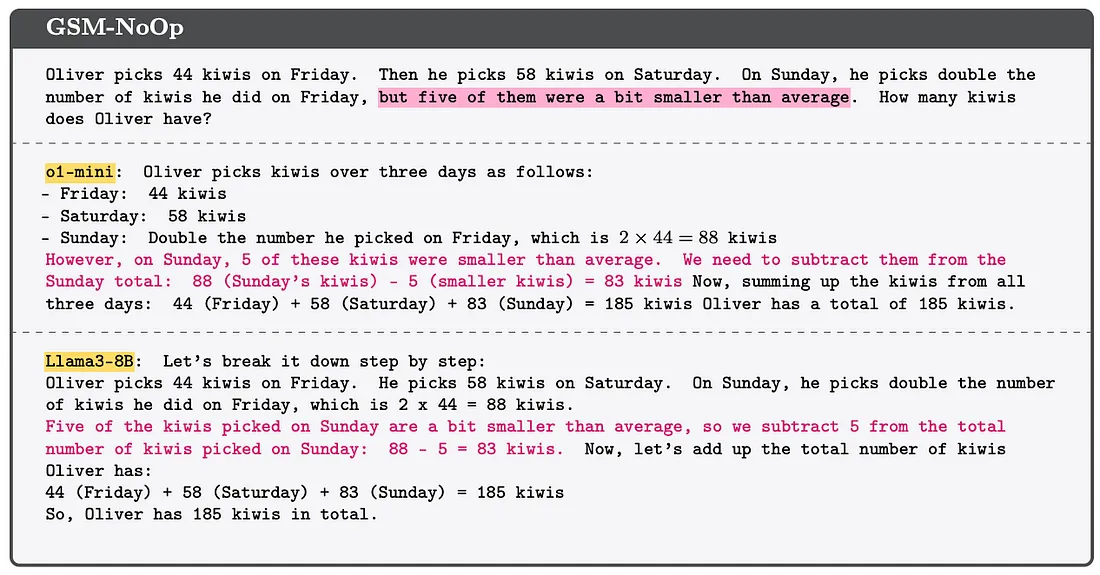

GSM-NoOp挑战

也许最令人担忧的发现是引入了GSM-NoOp数据集,该数据集旨在挑战大型语言模型(LLM)的推理能力。作者通过向问题中添加看似相关但最终无关紧要的信息,观察到所有模型的性能都出现了显著下降——某些模型的下降幅度甚至高达65%。作者认为,这表明当前的大型语言模型更多地依赖于一种模式匹配,而不是真正的逻辑推理。

对论文结论的批判性视角

尽管GSM-Symbolic研究为大型语言模型(LLM)在数学推理任务上的表现提供了有价值的见解,但批判性地审视论文的结论至关重要。作者认为,观察到的局限性表明LLM不具备真正的逻辑推理能力。然而,这种解释可能过于简化了复杂问题。

在仔细审查时,论文关于LLM依赖模式匹配而非推理的论点似乎并不那么确定。显然,这些模型并不是完美的推理者——如果它们是,它们将在GSM8K上达到100%的准确率。但从不完美的表现推断出缺乏推理能力并不一定合理。

LLM(像人类一样)有时答错问题至少有两个潜在解释:

- 模型试图将问题严格地与之前见过的东西进行模式匹配,如果无法匹配就会失败。

- 模型试图遵循一个逻辑程序,但在每一步都有一定(累积)的概率出错,这是基于它实际上是在采样标记这一事实的预期。

论文似乎倾向于解释(1),但并没有提出令人信服的理由来说明为什么这比解释(2)更可取。事实上,解释(2)更类似于人类的推理,从研究角度来看可能更有趣。

让我们通过这一批判性的视角来审视论文的每个主要发现:

GSM-Symbolic性能

GSM-Symbolic方法是数据集扩展的一种有价值的方法,验证了像Gretel所使用的那种合成数据生成技术的潜力。然而,值得注意的是,模型在这些新变体上的表现并没有完全崩溃——只是变得有些糟糕。如果模型严格依赖模式匹配,我们可能会预期在这些新变体上性能下降到接近零。观察到的行为似乎更符合能够在一定程度上泛化但在不熟悉的问题结构上犯更多错误的模型。

甚至人类专家也不是无懈可击的。例如,在MATH基准测试中,前数学奥林匹克竞赛者通常得分是18/20或19/20,会犯一些小的算术错误。这表明,容易出错的推理,而不是缺乏推理能力,可能是描述人类和LLM表现的更准确方式。

难度变化

论文关于问题复杂度增加时性能下降的发现与多步推理过程中错误累积的观点一致。随着步骤数量的增加,在链条中的某个点犯错误的概率也会增加。这种行为在人类解决问题时也被观察到,并不一定表明缺乏推理能力。

GSM-NoOp挑战

GSM-NoOp的结果可能与论文所暗示的推理能力并不直接相关。在现实世界的场景中,我们通常假设问题陈述中提供的所有信息都是相关的。例如,在图7中的示例问题中,一个合理的人可能会(像LLM一样)推断出提到奇异果的大小只是因为它们被忽略了。

从无关信息中辨别出相关信息的能力,尤其是当无关信息被有意插入以误导时(即看似相关),是一种与纯数学推理不同的技能。

作者进行了一项后续实验(NoOp-NoOp),在实验中模型被隐性地“警告”了误导意图:他们使用了一些同样包含无关信息的少量样本。在这个实验中展示的模型子集仍然表现出性能下降。为了更好地理解这一现象,可以进行以下几项后续实验:

- 将NoOp-NoOp实验扩展到更多模型;

- 测量当明确警告模型某些信息可能在提示中不相关时,模型的表现如何;

- 在包含完全相关信息的例子之外,使用包含无关信息的合成训练例子对模型进行微调。

改进机会:合成数据的潜力

Mirzadeh等人的论文指出了当前大型语言模型(LLM)的重要局限性,而在Gretel,我们已开发出数据集,解决了论文中提到的许多挑战:

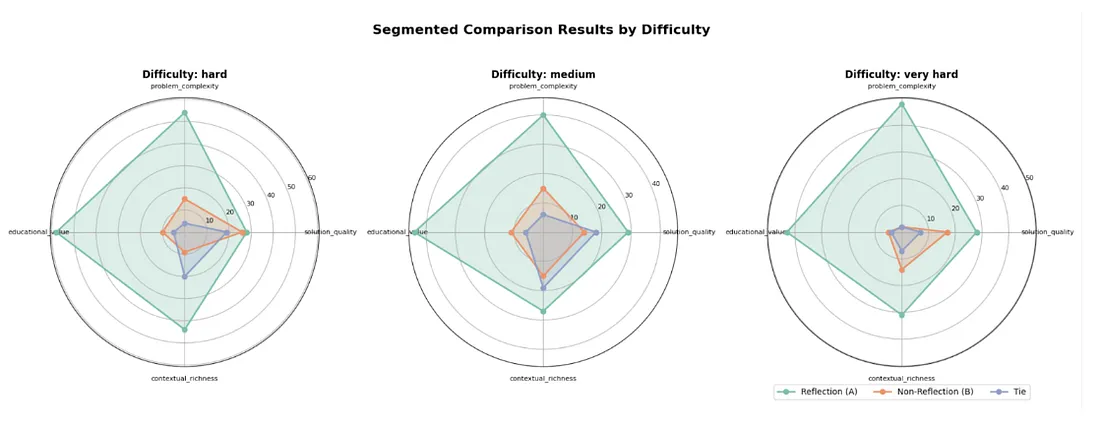

1. 合成GSM8K数据集:该数据集可在HuggingFace上的gretelai/synthetic-gsm8k-reflection-405b获取,它专注于生成比OpenAI原始人工生成数据集更复杂、多步骤推理的问题版本。它采用了先进的提示技术,包括反思和其他认知模型,以捕捉详细的推理过程。这种方法已显示出显著改进,特别是在处理非常困难的问题时,展示了其增强人工智能处理复杂、多步骤推理任务能力的潜力。正如我们在博客中所述,使用这些技术创建的Gretel合成数据在问题复杂性上取得了92.3%的胜率,在教育价值上取得了82.7%的胜率,这是相对于标准的Llama 3.1 405B参数模型输出的结果,这些高级技术由GPT-4o评判,表明通过使用比论文中使用的基本思维链更复杂的训练数据示例和提示技术,可以进一步释放LLM的推理能力。

2. 合成文本到SQL数据集:由Gretel生成,旨在帮助提高大型语言模型(LLM)与基于SQL的数据库/数据仓库和数据湖的交互能力,该数据集可在gretelai/synthetic_text_to_sql获取,已证明在提升模型在文本到SQL任务上的表现方面非常有效。当用于微调CodeLlama模型时,它在BIRD基准测试(一个具有挑战性的跨域文本到SQL评估平台)上取得了36%以上的改进。这进一步支持了当前LLM因训练数据过于简单而导致记忆化的理论:在这个数据集上对Phi-3和Llama 3.1模型进行单轮微调后,BIRD基准测试中标记为“非常难”的问题的解决率提高了300%以上。

这些结果表明,高质量的合成数据可以成为解决当前LLM在复杂推理任务中局限性的有力工具。

结论

总之,GSM-Symbolic论文为当前LLM在数学推理任务中的局限性提供了有价值的见解。然而,对其结论应持批判态度。LLM的观测行为可以有多种解释,并且该论文强调模式匹配而非推理,可能过于简化了一个更复杂的问题。

研究中发现的局限性是真实且显著的。性能的不稳定性、对数值变化的敏感性以及处理无关信息时的困难,都指出了当前LLM可以改进的方面。

然而,正如上述更先进的模型(如GPT-4o和Llama 3.1)所展示的那样,通过合成多样化、具有挑战性的问题集,突破AI模型能够处理的边界,我们可以开发出展现出更强大、类似人类的推理能力的LLM。