Run AI推出开源解决方案Model Streamer,六倍提升模型加载速度

在人工智能与机器学习日新月异的领域中,高效部署与运行模型成为了成功的核心要素。数据科学家与机器学习工程师时常面临的一大挑战,便是模型加载进行推理的过程既慢且繁琐。无论模型是存储于本地还是云端,加载效率低下都会成为制约因素,导致生产效率下降,延迟有价值见解的产出。当这一挑战延伸至现实应用场景时,问题更为凸显,因为用户期望的推理既快速又可靠。因此,优化不同存储方案下的模型加载时间,无论是本地部署还是云端环境,一直是众多团队亟待解决的重要课题。

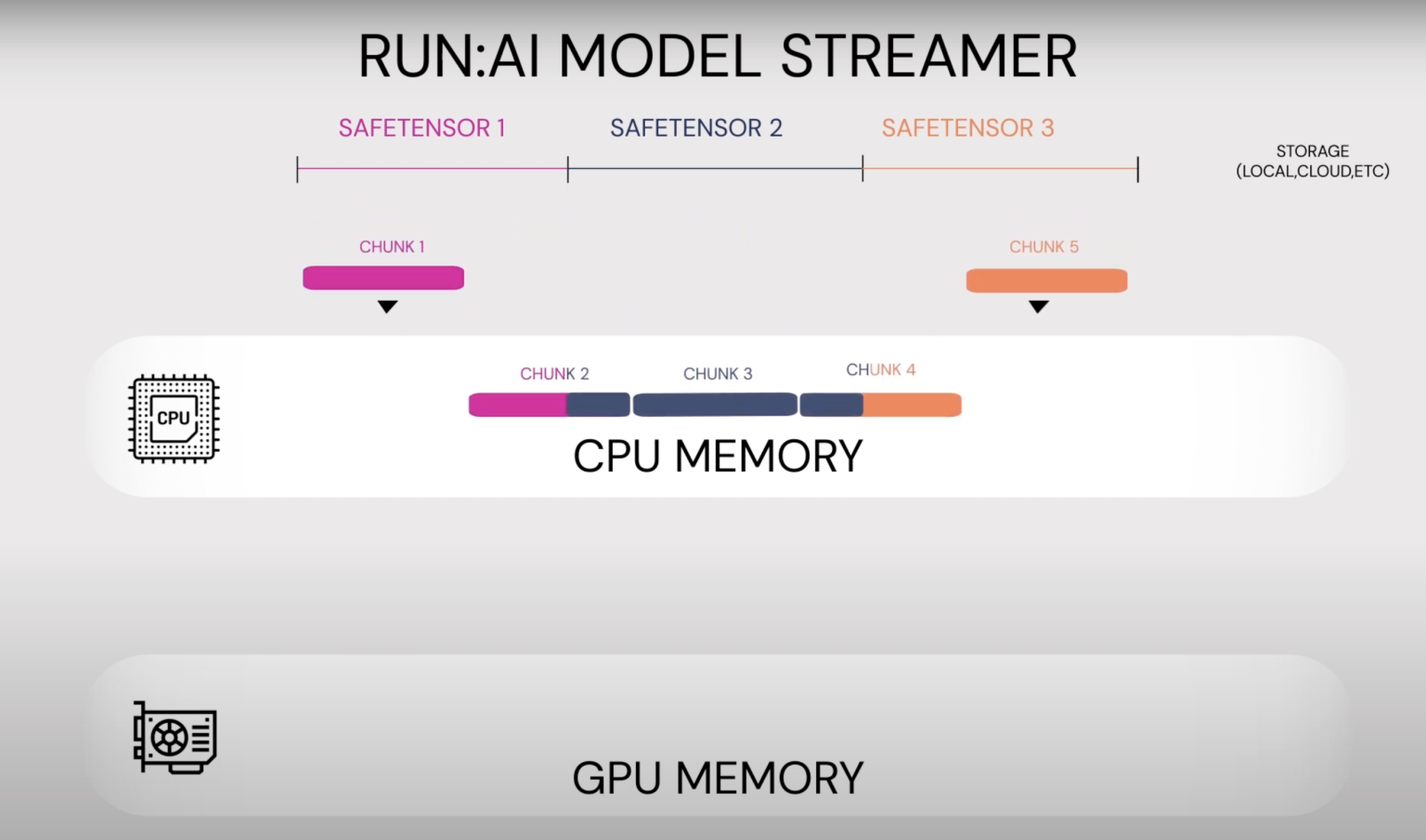

Run AI近期推出了一款开源解决方案——Run AI: Model Streamer,旨在显著缩短模型加载时间,助力AI领域克服这一技术难题。该工具通过提供高速且优化的模型加载方式,不仅加速了部署流程,还使其更加顺畅。Run AI以开源形式发布此工具,赋予了开发者在各类应用中创新利用的能力,彰显了其致力于让先进AI技术普及并高效服务于每个人的决心。

Run AI: Model Streamer凭借多项关键优化,实现了对传统模型加载方法的超越。其最突出的优势在于,能将模型加载速度提升至原来的六倍。该工具兼容所有主流存储类型,包括本地存储、云解决方案、Amazon S3以及网络文件系统(NFS),确保了开发者无需担忧兼容性问题,无论模型身处何处。此外,Run AI: Model Streamer能够与流行的推理引擎无缝整合,省去了繁琐的模型格式转换步骤。例如,Hugging Face的模型可直接加载,无需任何转换,极大地减少了部署过程中的障碍。这种本地兼容性让数据科学家与工程师能够更专注于创新,而非模型集成的细节。

Run AI: Model Streamer的实际性能优势不容忽视。Run AI的基准测试结果显示,从Amazon S3加载模型,传统方法耗时约37.36秒,而使用Run AI: Model Streamer则仅需4.88秒;从SSD加载模型的时间也从47秒缩短至7.53秒。这些显著的性能提升,在需要快速模型加载的可扩展AI解决方案中尤为重要。通过最小化加载时间,Run AI: Model Streamer不仅提升了个人工作流程的效率,还增强了依赖快速推理的AI系统的整体可靠性,如实时推荐引擎或关键医疗诊断系统。

Run AI: Model Streamer以其可靠且高速的模型加载解决方案,解决了AI工作流程中的关键瓶颈。高达六倍的加载速度提升以及在不同存储类型间的无缝集成,使得该工具在提升模型部署效率方面颇具潜力。直接加载模型而无需格式转换进一步简化了部署流程,让数据科学家与工程师能够专注于他们最擅长的领域——解决问题并创造价值。通过开源这一工具,Run AI不仅推动了社区内的创新,还为模型加载与推理设立了新的标准。随着AI应用的日益普及,Run AI: Model Streamer等工具将在确保这些创新快速高效地发挥全部潜力方面发挥至关重要的作用。