大型语言模型的改进与新框架提出:提升小规模模型在特定推理任务中性能

近年来,大型语言模型(LLMs)在自然语言理解和生成方面展现出了卓越的能力。研究人员不仅探索了LLMs在文本预测领域的潜力,还发现了其在软件API函数调用等方面的意外能力,这为GPT-4插件功能的推出提供了有力支持。此外,LLMs还成功集成了网络浏览器、翻译系统、对话状态跟踪(DST)和机器人等工具,进一步拓宽了其应用范围。

尽管LLMs在复杂推理方面取得了有希望的结果,但在数学问题解决和逻辑能力方面仍面临严峻挑战。为了应对这些挑战,研究人员提出了利用函数调用技术,使LLMs能够执行特定函数并利用其输出来辅助完成各种任务。这些函数涵盖了从基本算术运算到更高级方法的广泛领域。然而,仅依赖大型模型进行特定任务处理存在低效性,因为大型模型在训练和推理过程中都需要大量的计算资源,且训练成本高昂。

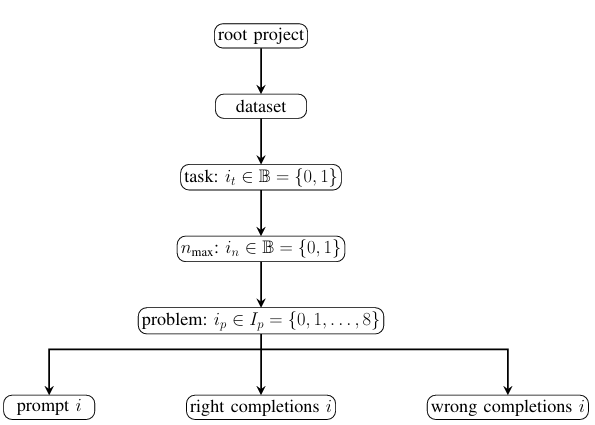

为了克服大型LLMs的缺点,研究人员提出了一种新的框架,旨在训练较小的LLMs在特定的推理任务中进行函数调用。该框架通过引入一个代理程序,将可用函数的描述和示例注入到提示中,从而查询LLMs并创建正确和错误推理链完成的数据集。这种方法不仅降低了运营成本,还保持了核心功能的有效性。

具体而言,该框架的流程包括四个阶段:首先,定义任务和问题,以评估大型语言模型在各种推理领域的能力;其次,设置每个任务特定的函数,允许LLM解决推理步骤,管理链条流程并验证结果;接着,选择一个预训练的大规模LLM,使用思维链提示方法生成正确和错误完成的数据集;最后,使用直接策略优化(DPO)算法在创建的数据集上对较小的LLM模型进行微调。

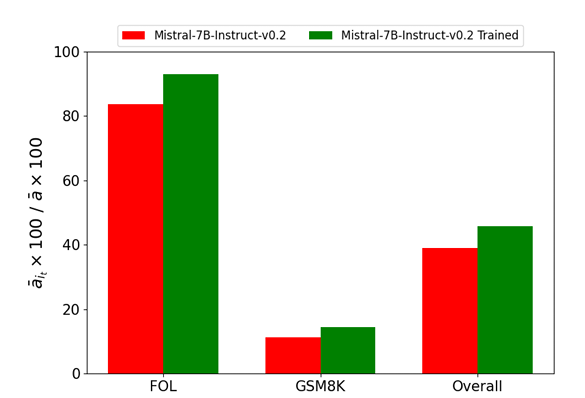

实验部分涉及在一阶逻辑(FOL)和数学问题上测试模型。结果表明,在FOL任务中,模型的准确性得到了显著改善,数学任务中的增益也适中,并通过Wilcoxon检验确认了统计学显著性。此外,数据增强和单个GPU的微调进一步扩展了数据集并优化了Mistral-7B模型的性能。

研究人员提出的这一新框架有效改进了小规模LLMs在特定逻辑和数学推理任务中的函数调用能力。这种方法不仅减少了对大型模型的需求,还提高了相关任务的性能。实验结果表明,在FOL任务上,小规模模型的性能有了显著提升,准确率接近完美。展望未来,该框架在更广泛的推理任务和函数类型中的应用前景广阔,值得进一步探索。