亚马逊首席执行官:未来大型语言模型训练能耗惊人

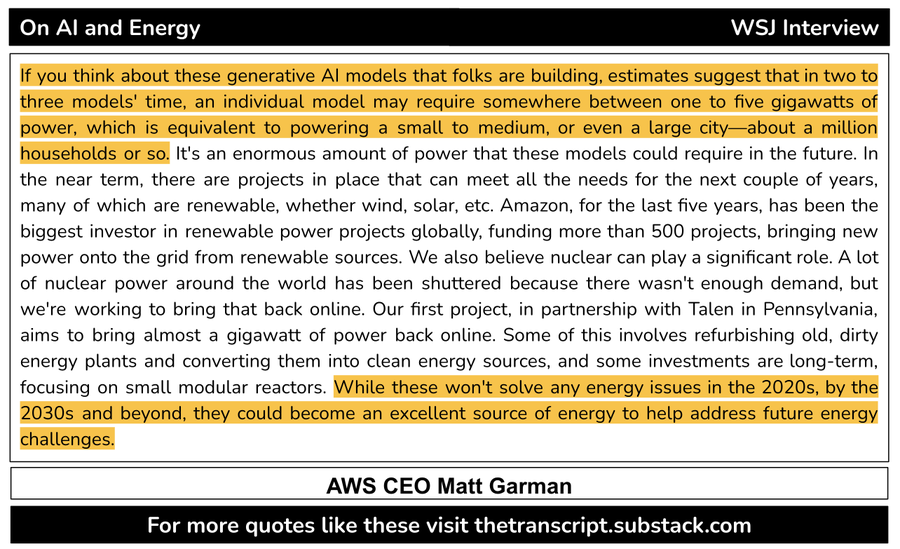

亚马逊网络服务(Amazon Web Services)首席执行官Matt Garman近日估计,未来两三代的大型语言模型(LLM)训练所需的能量将与大城市的能量消耗相当。据The Transcript在X(前Twitter)平台上发布的报道,Garman在接受《华尔街日报》(WSJ)采访时透露,训练一个大型语言模型可能需要1到5千兆瓦的电力,为此,AWS正积极投资电力项目,以满足这一不断增长的需求。

以Meta的Llama LLM为例,该公司于2023年2月发布了首款模型,随后在7月推出了Llama 2,今年4月中旬又发布了Llama 3。若其他LLM也按照这样的训练节奏推进,那么平均每七个月,我们就可能见证新一代模型的诞生。相比之下,LLM领域的先驱OpenAI在2020年6月发布了GPT-3,而在2023年3月才推出了GPT-4。尽管OpenAI在2022年也发布了GPT-3.5,但这更多是对GPT-3的改进,而非全新的一代。因此,OpenAI花费了近三年的时间才推出了下一代模型。

从这些信息中,我们可以推断,在当前的硬件条件下,典型的新一代LLM模型大约需要一到两年的时间来训练。虽然人工智能公司正在使用更多的人工智能GPU进行模型训练,但这些LLM模型,如未来的Llama-4,也将变得更加复杂,可能需要超过100,000个英伟达H100 GPU的集群来支持。由于计算能力的限制,OpenAI已将其ChatGPT-5模型的发布推迟到了2025年。据此推测,大约五年后,我们可能会达到所需的五千兆瓦电力要求。

这将为OpenAI、Microsoft、亚马逊、谷歌和甲骨文等科技巨头提供时间窗口,以增加能源产能。Garman表示,AWS正在资助500多个项目,旨在将可再生能源引入电网,这对数据中心至关重要。因为部署可再生能源需要时间,而传统能源如煤炭和天然气则会产生大量温室气体排放。在争夺人工智能主导权的竞争中,能源问题已成为一个关键议题。即使谷歌也未能达到其气候目标,其数据中心能源需求的增加导致排放量从2019年增长了48%。甚至有前谷歌首席执行官建议放弃气候目标,全力推动人工智能的发展,以期在未来解决气候危机。

然而,这些人工智能巨头已经意识到了能源供应网络(或缺乏)的威胁。因此,除了中期投资可再生能源外,其中几家公司还开始投资于核能发展。微软已经签署了协议,计划重新启动三里岛核反应堆以满足其数据中心的需求,而谷歌和甲骨文都计划建造自己的小型核反应堆。此外,传统核电厂行业的老牌参与者威斯汀豪斯也在研发易于部署的微型反应堆,旨在为下一代人工智能数据中心提供能源。

目前,能源供给限制已成为人工智能发展的瓶颈,尤其是部署新基础设施(如发电厂、输电线路、变压器等)需要很长时间。虽然人工智能公司可以使用便携发电机和其他非可再生能源来满足短期的电力需求,但这并非长远之计。因此,我们对于持续推动人工智能发展的唯一希望,就是这些替代性的可再生能源能够尽快上线并发挥作用。