如何缩减人工智能模型大小成研究热点,量化技术备受瞩目

2024年11月05日 由 neo 发表

433

0

人工智能模型,特别是大型语言模型(LLM),对GPU内存的需求极为庞大。以2024年7月发布的LLaMA 3.1模型为例,其80亿参数的版本便需16GB内存以16位浮点权重表示;而参数规模更庞大的4050亿参数版本,则需810GB的16位浮点数内存。

在大型机器学习模型中,权重通常以32位浮点数形式存在。现代模型的权重数量动辄数亿至数千亿,乃至数百万亿之巨。训练和运行这些庞然大物,资源消耗极为惊人:

- · 强大的计算能力不可或缺。

- · GPU内存需求巨大。

- · 能源消耗同样惊人,尤其是32位浮点数的大量计算(如矩阵乘法)和数据传输(模型数据从内存至处理单元的复制)更是能耗大户。

高度资源密集性带来了两大弊端:

- · 训练成本高昂且速度缓慢,使得新研究和开发只能由预算雄厚的团队承担。

- · 预测阶段需依赖昂贵且专业的硬件(如专用GPU服务器),无法在普通笔记本电脑或手机等消费者设备上运行。

因此,终端用户和个人设备往往只能通过付费API服务访问AI模型,这不仅导致用户体验不佳,还为基于AI的软件开发者带来了预算限制。若能在消费者设备上本地运行AI模型,这些问题或将迎刃而解。

鉴于此,减小AI模型尺寸已成为当前研究和开发的热点。本系列文章将探讨减小模型尺寸的方法,首篇便聚焦于量化技术。以下是对本系列文章内容的概览:

- · 减小模型大小的方法概述:介绍了减小模型尺寸的不同途径,并着重阐述了量化作为最有前景的方法及其研究现状。

- · 量化AI模型权重:通过数值示例,直观展示了量化的算术原理。

- · 量化神经网络模型:深入探讨了量化在神经网络模型中的应用,包括基本数学原理及如何训练模型以在量化权重推理过程中保持优异表现。

- · 不同的量化方法:详细解析了不同类型的量化,如不同精度、粒度、确定性和随机量化,以及训练过程中的量化策略。

- · 极限量化:1位AI模型:介绍了二进制量化,即将模型权重从32位浮点数缩减为二进制数。同时,展示了二进制量化的数学基础及BERT二进制量化的研究方法。

- · 理解使用1位权重的大型语言模型:阐述了将大型语言模型(LLMs)量化为1位(二进制)权重的最新研究成果,特别是BitNet这一成功尝试。

- · 理解1.58位语言模型:讨论了将神经网络模型,尤其是LLMs,量化为使用三位权重({-1, 0, +1})的1.58位量化,并展示了其极具前景的结果。

减小模型尺寸的方法多种多样,旨在摆脱对昂贵硬件的依赖,使人工智能应用更加普及,并加速新模型的研发与采用。其中,低秩分解、剪枝、知识蒸馏及量化等方法备受瞩目。

- · 低秩分解:通过分解高维张量为较小维度的张量组合,提高计算效率。

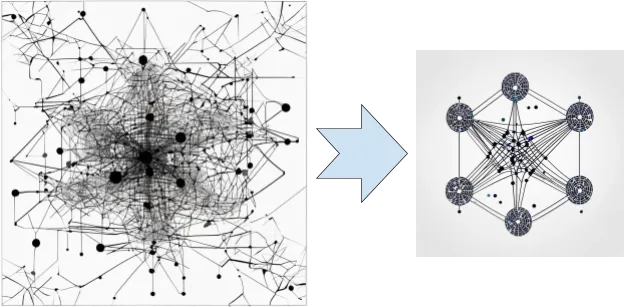

- · 剪枝:通过删除神经网络中的冗余连接,减小网络规模和复杂性。

- · 知识蒸馏:以较小的神经网络复制较大且更复杂神经网络的行为,但学生网络往往难以在未见数据上推广。

- · 量化:通过降低模型权重的精度至8位整数甚至二进制,以不牺牲模型准确性的前提下减小模型尺寸。量化技术之所以有效,部分原因在于权重的相对值和统计特性比其实际值更为重要。

量化推理是指在量化模型上进行预测的过程,其中部分数据流采用较低精度,而偏置和累加器输出则保持高精度。

本文旨在探讨减小AI模型尺寸的需求,并概述了实现这一目标的方法。量化作为目前最成功的减小模型尺寸并保持准确性的方法,受到了广泛关注。本系列文章将深入探讨量化背后的数学原理、训练量化模型的过程等子主题,为读者提供全面了解语言模型极端量化的背景知识。由于这是一个活跃的研究领域,不同研究者正采用创新方法以追求更佳成果。

文章来源:https://towardsdatascience.com/reducing-the-size-of-ai-models-4ab4cfe5887a

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消