Meta AI视频生成技术新突破:AdaCache加速高质量视频生成

视频生成技术正迅速成为人工智能研究的热点,特别是在创建时间上一致、高保真度的视频方面。这一领域致力于生成能够在帧之间保持视觉连贯性并随时间保留细节的视频序列。机器学习模型,特别是扩散变换器(DiTs),已成为这一领域的强大工具,其生成质量超越了以往的方法,如GAN和VAE。然而,随着模型复杂度的提升,生成高分辨率视频的计算成本和延迟成为亟待解决的关键挑战。当前,研究人员正致力于提升这些模型的效率,以实现更快、实时的视频生成,同时保持高质量标准。

高质量视频生成模型面临的一个紧迫问题是资源密集性。生成复杂、视觉吸引人的视频需要强大的处理能力,特别是对于处理较长、高分辨率的视频序列的大型模型而言。这些需求减缓了推理过程,使得实时生成成为一大难题。许多视频应用需要既能快速处理数据又能在帧之间保持高保真度的模型。因此,如何在处理速度和输出质量之间找到最佳平衡点成为了一个关键问题。通常,更快的方法会牺牲一些细节,而高质量的方法则往往计算复杂且速度较慢。

为了优化视频生成模型,研究人员引入了各种方法,旨在简化计算过程并减少资源使用。传统方法,如步骤蒸馏、潜在扩散和缓存等,虽对实现这一目标有所贡献,但存在局限性,如适应每个视频序列独特特征的灵活性较弱。这往往导致处理效率低下,特别是在处理复杂性、运动和纹理差异很大的视频时。

Meta AI公司和Stony Brook大学的研究人员提出了一种创新解决方案——自适应缓存(AdaCache)。AdaCache无需额外训练,即可加速视频扩散变换器的处理。它是一种无需训练的技术,可集成到各种视频DiT模型中,通过动态缓存计算来简化处理时间。AdaCache通过适应每个视频的独特需求,将计算资源分配在最有效的位置上,旨在优化延迟的同时保持视频质量。这使得AdaCache成为一种灵活、即插即用的解决方案,能够改善不同视频生成模型的性能。

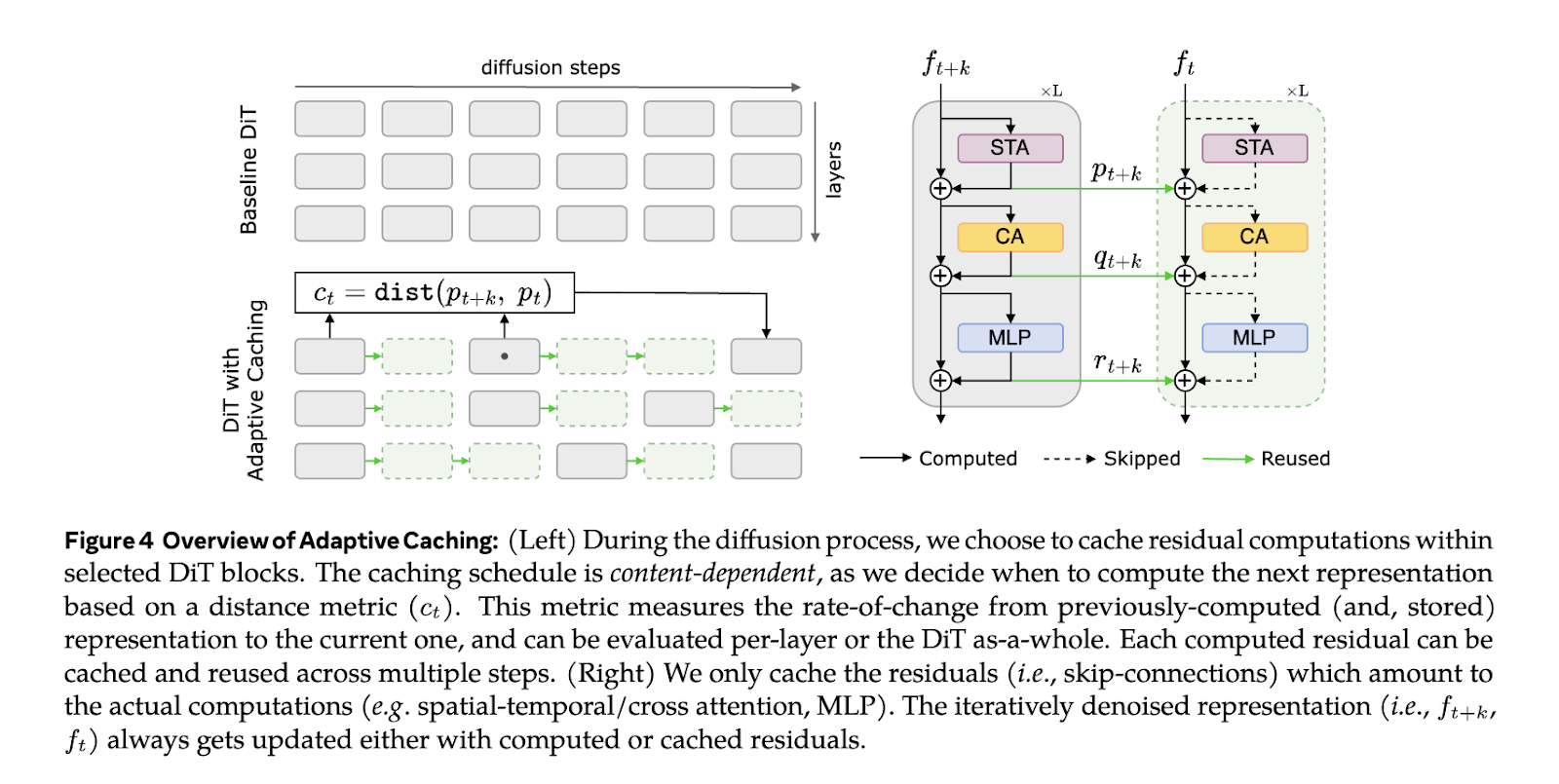

AdaCache通过在变换器架构中缓存某些残差计算,允许这些计算在多个步骤中重复使用,从而避免了冗余的处理步骤,这是视频生成任务中的常见瓶颈。该模型使用一个针对每个视频量身定制的缓存计划,确定重新计算或重复使用残差数据的最佳点。该计划基于一个评估帧之间数据变化率的指标。此外,研究人员还将运动规范化(MoReg)机制纳入AdaCache中,将更多的计算资源分配给需要更精细关注细节的高运动场景。通过使用轻量级的距离度量和基于运动的规范化因子,AdaCache在速度和质量之间取得了平衡,根据视频的运动内容调整计算重点。

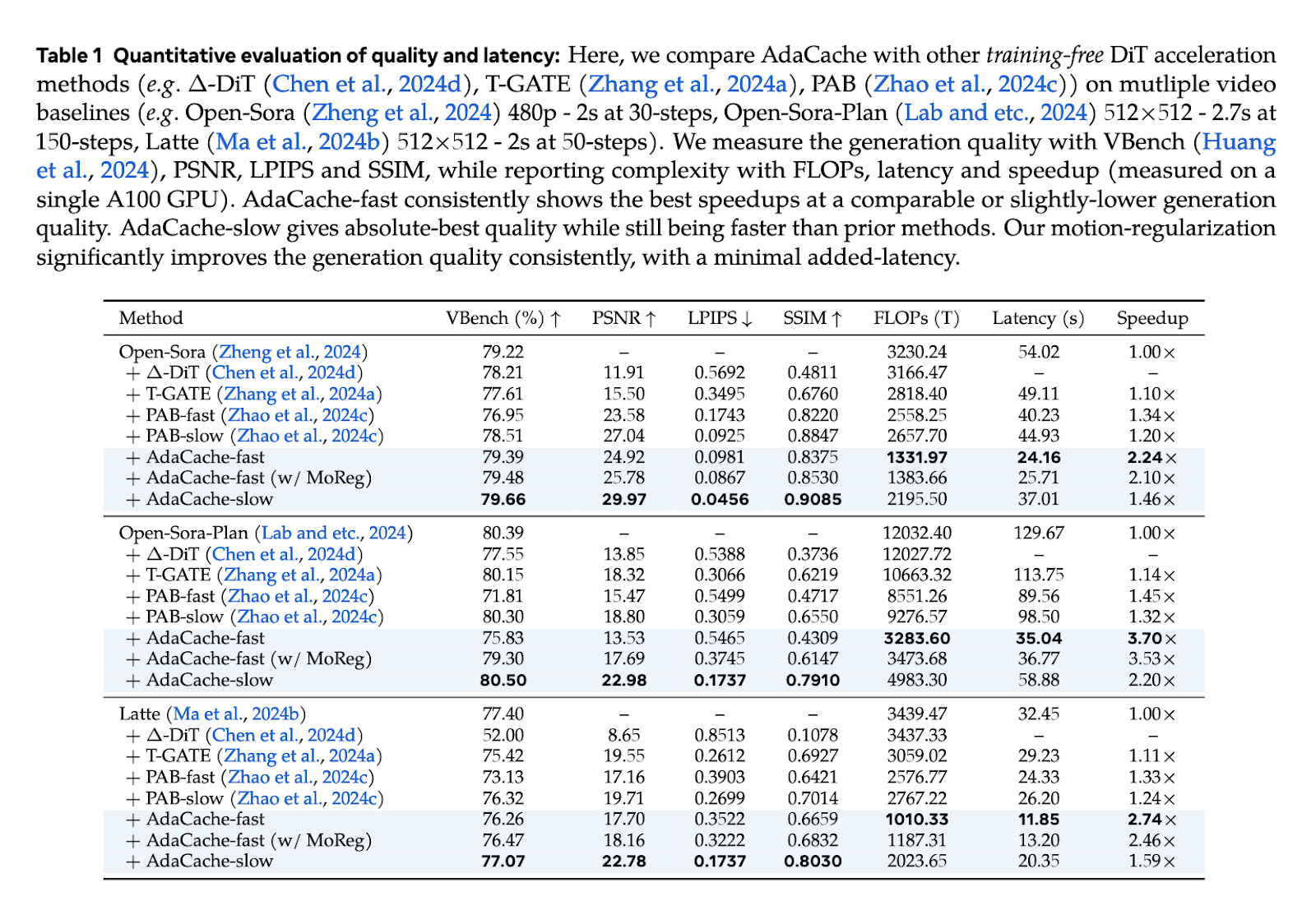

研究团队进行了一系列测试来评估AdaCache的性能。结果显示,AdaCache显著提高了多个视频生成模型的处理速度和质量保持能力。例如,在涉及Open-Sora的720p 2秒视频生成的测试中,AdaCache的速度比以前的方法提高了多达4.7倍,同时保持了可比较的视频质量。此外,AdaCache还提供了“AdaCache-fast”和“AdaCache-slow”等变体,根据速度或质量需求提供了选择。通过MoReg机制,AdaCache在视觉评估中与人类喜好密切一致,并且胜过传统的缓存方法。对不同DiT模型的速度基准测试也证实了AdaCache的优越性,加速比范围为1.46倍至4.7倍不等。

总之,AdaCache标志着视频生成领域的重大进展,为处理延迟和视频质量之间的平衡问题提供了一种灵活的解决方案。通过采用自适应缓存和基于运动的规范化,研究人员提供了一种对实时和高质量视频生成的各种实际应用都有效且实用的方法。AdaCache的即插即用性使其能够增强现有的视频生成系统,无需进行大量的重新训练或定制,这使其成为未来视频生成领域的一种有前途的工具。