AMD推出首个完全开源10亿参数大型语言模型AMD OLMo

AMD近日正式推出了其首个完全开源的10亿参数大型语言模型(LLM)系列——AMD OLMo。该模型旨在适用于各种应用场景,并在AMD的Instinct MI250 GPU上进行了预训练。据称,AMD OLMo模型具备强大的推理、指令遵循和对话能力。

AMD此举旨在提升其在人工智能行业的地位,并为客户提供在AMD硬件上部署这些开源模型的机会。通过开源数据、权重、训练方案和代码,AMD希望开发者不仅能够复制这些模型,还能在其基础上进行进一步的创新。除了数据中心应用外,AMD还使OLMo模型能够在配备神经处理单元(NPU)的AMD Ryzen AI个人电脑上进行本地部署,使开发者能够在个人设备上充分利用AI模型。

多阶段预训练

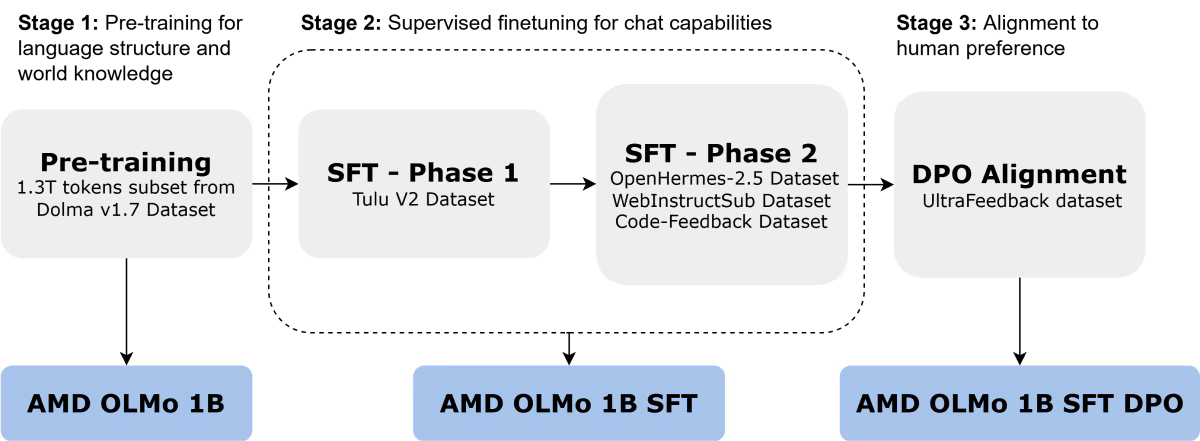

AMD OLMo模型在大规模数据集(包含13万亿个令牌)上进行了训练,使用了16个节点,每个节点配备四个AMD Instinct MI250 GPU(总计64个处理器)。该模型的训练过程分为三个阶段:

- · 初始的AMD OLMo 1B模型在Dolma v1.7的子集上进行了预训练,这是一个仅解码器的转换器,专注于预测下一个令牌,以捕捉语言模式和一般知识。

- · 第二个版本是AMD OLMo 1B进行监督微调(SFT),首先在Tulu V2数据集上进行训练,然后在OpenHermes-2.5、WebInstructSub和Code-Feedback数据集上进行进一步训练,以提升其指令遵循能力,并提高在科学、编码和数学任务上的性能。

- · 在微调后,使用UltraFeedback数据集对AMD OLMo 1B SFT模型进行了人类喜好的调整,生成了最终的AMD OLMo 1B SFT DPO版本,以优先考虑与典型人类反馈一致的输出。

性能结果

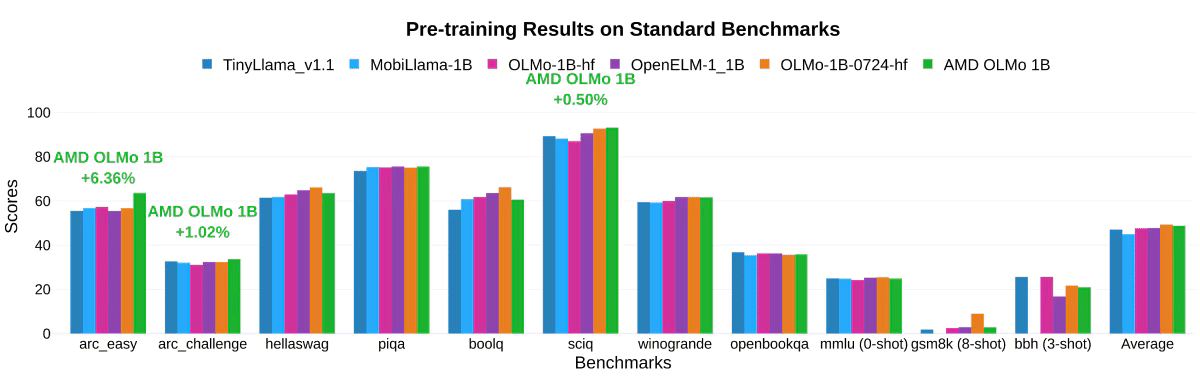

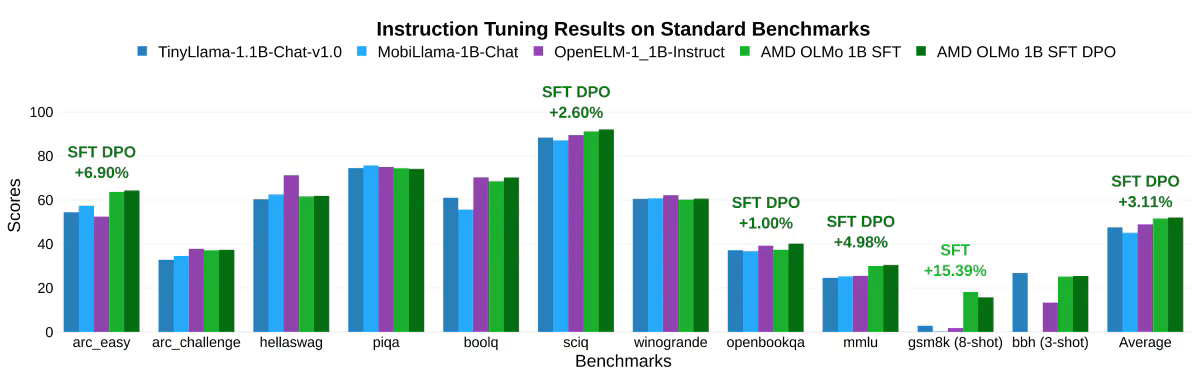

在AMD自己的测试中,AMD OLMo模型在一般推理能力和多任务理解等标准基准测试中表现出色,与类似规模的开源模型(如TinyLlama-1.1B、MobiLlama-1B和OpenELM-1_1B)相比具有竞争力。

- · 两阶段SFT模型显示出显著的准确性提升,MMLU得分增加了5.09%,GSM8k增加了15.32%,这充分展示了AMD训练方法的有效性。

- · 最终的AMD OLMo 1B SFT DPO模型在各项基准测试中平均超过其他开源对话模型至少2.60%。

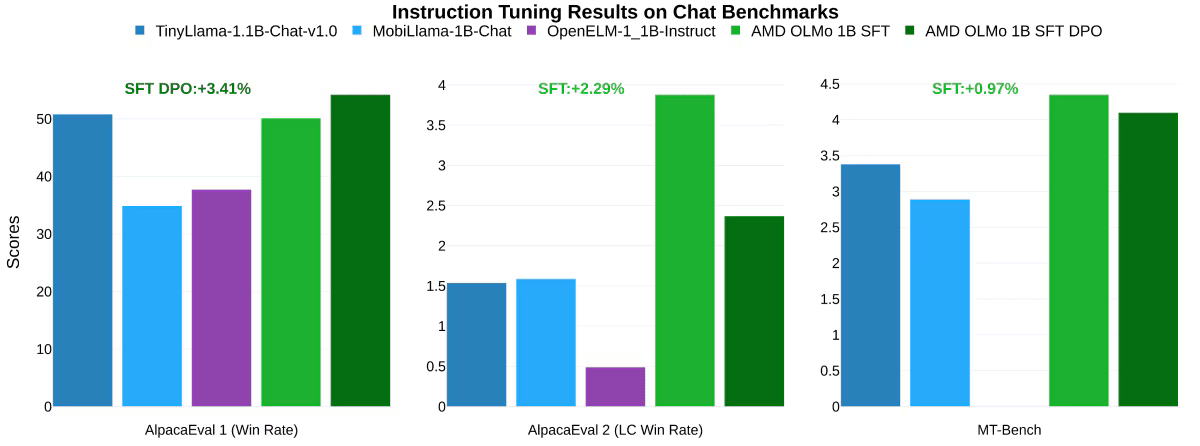

在对话基准测试的指令调优结果方面,特别是将AMD OLMo 1B SFT和AMD OLMo 1B SFT DPO模型与其他指令调优模型进行比较时,AMD的模型在AlpacaEval 2 Win Rate指标上的表现超过最接近的竞争对手3.41%,在AlpacaEval 2 LC Win Rate指标上超过2.29%。此外,在衡量多轮对话能力的MT-Bench测试中,SFT DPO模型的性能较最接近的竞争对手提高了0.97%。

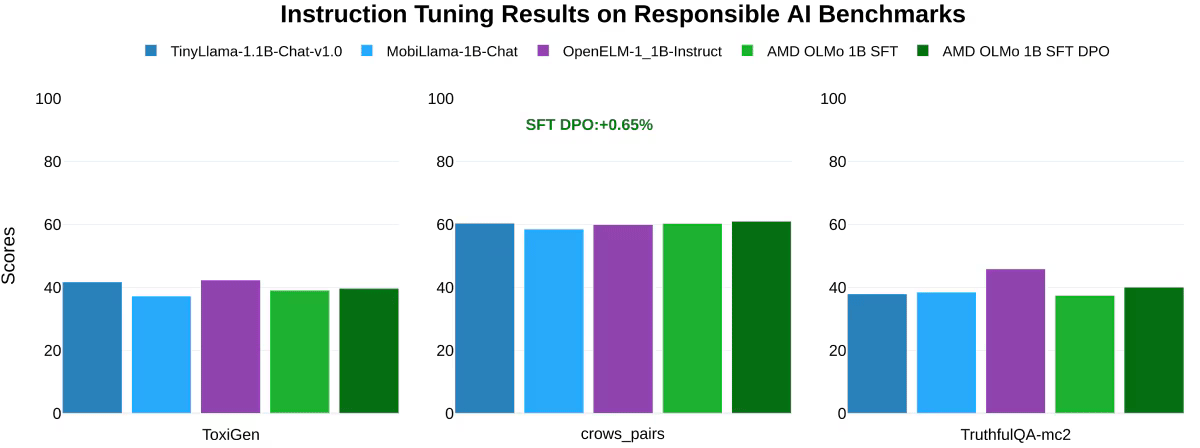

此外,AMD还在负责任的人工智能基准测试中进行了测试,包括衡量有毒语言的ToxiGen(分数越低越好)、评估偏见的crows_pairs和评估回答真实性的TruthfulQA-mc2。结果发现,AMD OLMo模型在处理道德和负责任的人工智能任务方面与类似模型不相上下。

AMD OLMo的推出标志着AMD在人工智能领域迈出了重要一步,为用户和开发者提供了更加多样化和高效的AI解决方案。