微软发布LLM2CLIP:开启跨模态表示新篇章

在当今科技日新月异的时代,CLIP作为最重要的多模态基础模型之一,正引领着图像与文本融合的新潮流。通过利用大规模的图像-文本对进行简单的对比学习,CLIP成功地将视觉和文本信号融合到共享特征空间中,展现出强大的跨模态表示能力。

作为一个功能强大的检索器,CLIP能够支持包括零样本分类、检测、分割以及图像-文本检索在内的多种任务。同时,作为特征提取器,CLIP在图像理解、视频理解和文本到图像/视频生成等跨模态表示任务中也占据了主导地位。其独特之处在于能够连接图像与自然语言,通过捕捉人类知识中的详细文本描述,为视觉编码器提供了全新的视角。

随着大型语言模型(LLM)的迅猛发展,语言理解与生成的边界不断被拓宽。LLM强大的文本处理能力为CLIP带来了新机遇,尤其是在处理长且复杂的标题时,能够弥补原始CLIP的短板。同时,LLM的广泛知识库也提升了训练效率。然而,尽管LLM理解能力卓越,但其文本生成方式可能导致输出不够清晰,且将LLM与CLIP结合也面临诸多挑战。

为了克服这些挑战,同济大学和微软公司的研究人员进行了深入研究,并提出了LLM2CLIP方法。该方法通过整合大型语言模型来增强视觉表示学习,用LLM的广泛知识替换原始的CLIP文本编码器,并增强了CLIP的视觉编码器。这一创新不仅大胆替换了原编码器,还针对潜在挑战提出了经济实惠的微调策略。

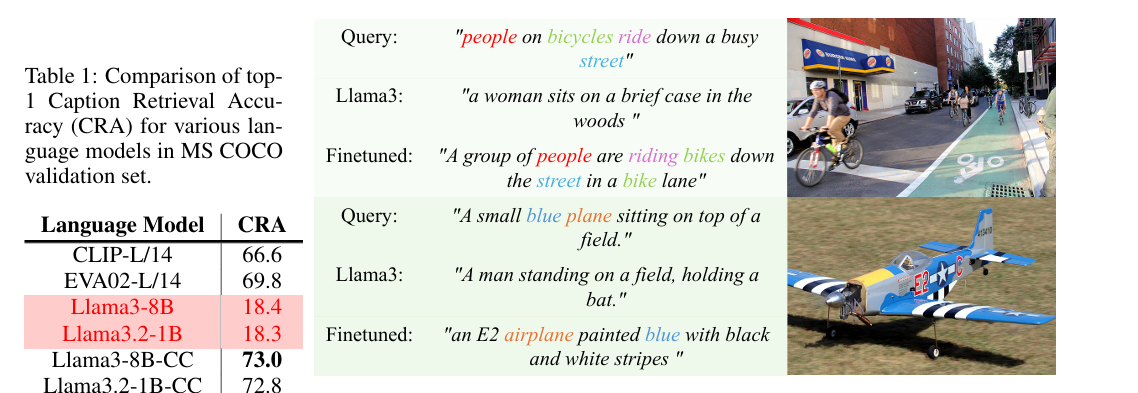

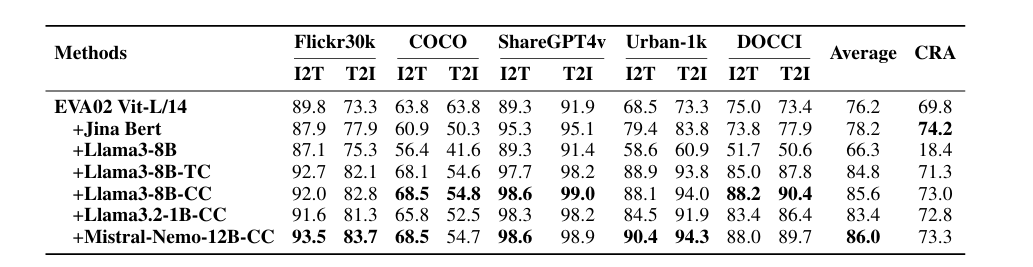

LLM2CLIP方法通过引入标题对比微调技术,成功解决了LLM作为CLIP文本编码器时遇到的困难,大大提高了LLM区分标题的能力。实验表明,该方法在图像-文本匹配等任务中表现优异,甚至超过了现有的最先进模型。通过将改进后的LLM与预训练的CLIP视觉编码器相结合,LLM2CLIP框架创建了一个强大的跨模态模型,且在计算上保持高效,成本增加最小。

在实验过程中,研究人员尝试了不同大小的数据集进行微调,以改善图像-文本匹配性能。结果显示,经过LLM2CLIP训练的模型在图像到文本和文本到图像检索等任务中均优于标准CLIP和EVA模型,凸显了将大型语言模型与图像-文本模型整合的优势。

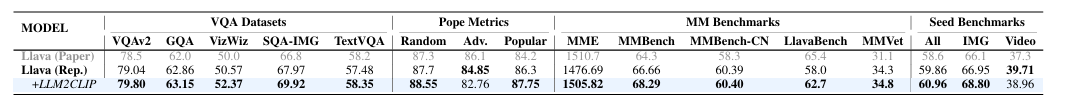

值得一提的是,LLM2CLIP方法不仅提高了长文本和短文本检索任务的性能,还将仅在英语数据上训练的CLIP模型转变为最先进的跨语言模型。在与Llava 1.5等模型进行多模态训练后,LLM2CLIP在几乎所有基准测试中均优于CLIP,显示出性能的显著整体改善。

研究人员计划使用更大的数据集从头开始训练LLM2CLIP,以获得更好的结果和性能。这项工作不仅为CLIP训练提供了新思路,也为跨模态表示的广泛应用奠定了坚实基础,预示着跨模态技术的新篇章即将开启。