混合Transformer (MoT)开启多模态AI效率新时代

介绍

近年来,多模态基础模型已成为人工智能领域的一项突破性进展,使单个模型能够处理和理解如文本、图像甚至语音等多种数据类型。这些模型在内容创作、图像生成到复杂的跨模态翻译任务等应用领域具有巨大潜力,人工智能可以在这些任务中解读和生成不同格式的信息。然而,尽管这些功能前景广阔,但训练大型多模态模型却面临着巨大的计算和可扩展性挑战。与仅在单一数据类型上训练的单模态模型不同,多模态模型需要庞大的数据集和巨大的计算能力来处理不同模态的不同结构和特征。

传统密集Transformer模型面临的最大障碍之一是“一刀切”的方法。这些模型在不同的模态上应用相同的参数和训练技术,这往往导致资源使用效率低下和训练动态冲突。例如,在同一个模型中处理文本、图像和语音可能会产生瓶颈,从而降低训练速度并增加计算成本。随着对多模态人工智能需求的增长,找到一种更高效的解决方案来平衡高性能与合理的计算成本至关重要。

混合 Transformers (MoT) 是一种专为应对这些挑战而设计的新型稀疏架构。与密集模型不同,MoT 通过“特定于模态的参数解耦”引入了一种处理多模态输入的独特方法,其中对每种数据类型使用单独的参数集。这不仅可以减少计算负荷,还可以单独优化每种模态,从而在不牺牲质量的情况下提高效率。在本文中,我们将探讨混合 Transformers 模型如何重新定义多模态基础模型,以极低的计算成本提供高性能。

传统密集模型在多模态学习中的问题

- 高计算成本:传统密集Transformer模型在所有数据模态(如文本、图像、语音)上应用相同的参数和架构。这导致了计算资源的使用效率低下,因为每种模态都有其独特的特性,需要不同的优化方法。

- 冲突的训练动态:当密集模型同时处理多个模态时,可能会遇到冲突的训练动态。这意味着为一个模态优化模型可能会对其他模态产生负面影响,从而降低模型的整体有效性,并需要更多的资源进行微调。

- 资源密集型扩展:为了在多模态任务上实现高性能,密集模型需要大量的数据和计算能力。例如,Chameleon这一密集多模态模型需要9.2万亿个标记才能达到与在远少于此的标记上训练的单模态模型相当的性能。

- 跨模态的统一处理:密集模型对所有输入进行统一处理,将文本、图像和语音视为相似类型的数据,尽管它们在结构上存在差异。这种统一的方法可能导致效率低下,并限制模型在单个模态中的表现。

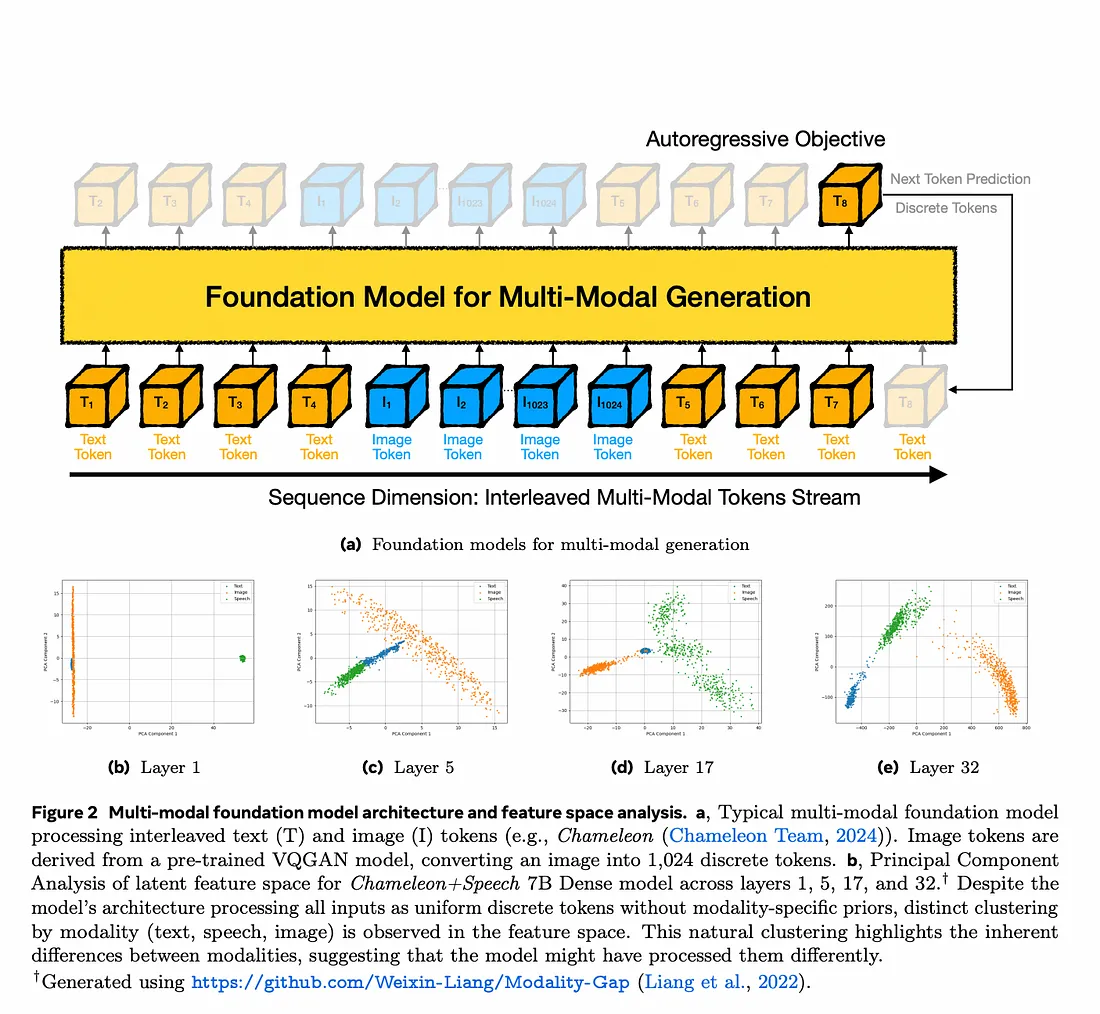

如上图所示,该模型将文本和图像标记(如单词和图像片段)的混合序列作为单个流进行处理。它采用自回归方法,预测序列中的下一个标记,无论是文本还是图像的一部分。图像会使用预训练模型被分解成离散的标记(如图像块列表),以便模型可以像处理文本一样处理图像。

当模型在各层中处理数据时,它自然开始在特征空间中将不同类型的标记(文本和图像)分组到不同的簇中,尤其是在更深的层中。这显示了模型在区分数据类型方面的能力不断增强。尽管这个模型对所有数据都进行统一处理,但它仍然学会了在内部区分文本和图像,这表明添加模态特定的组件(如混合物Transformer中的组件)可能会进一步增强这种分离并提高效率。

对稀疏架构的需求日益增长:稀疏架构,如混合专家(Mixture-of-Experts,MoE)模型,旨在通过每种模态只激活模型参数的一个子集来解决这些问题。然而,MoE模型面临着专家利用不均衡等挑战,需要复杂的路由算法,这会增加进一步的计算负载。

为了应对这些挑战,开发了混合物Transformer(Mixture-of-Transformers,MoT)架构作为一种稀疏、多模态模型。通过基于模态解耦参数,MoT降低了计算需求,并缓解了密集架构中出现的训练冲突。以下部分将探讨MoT的架构以及它在处理文本、图像和语音任务时令人印象深刻的效率,同时不影响性能。

混合 Transformer(MoT)简介

混合物Transformer是什么?

- MoT是一种稀疏、多模态的Transformer架构,专门设计用于解决多模态模型的扩展挑战。

- 与传统的密集 Transformer 不同,MoT 引入了特定于模态的参数解耦。这意味着 MoT 不会在所有模态中使用同一组权重,而是为每种模态(例如文本、图像、语音)分配不同的参数。

模态特定参数解耦

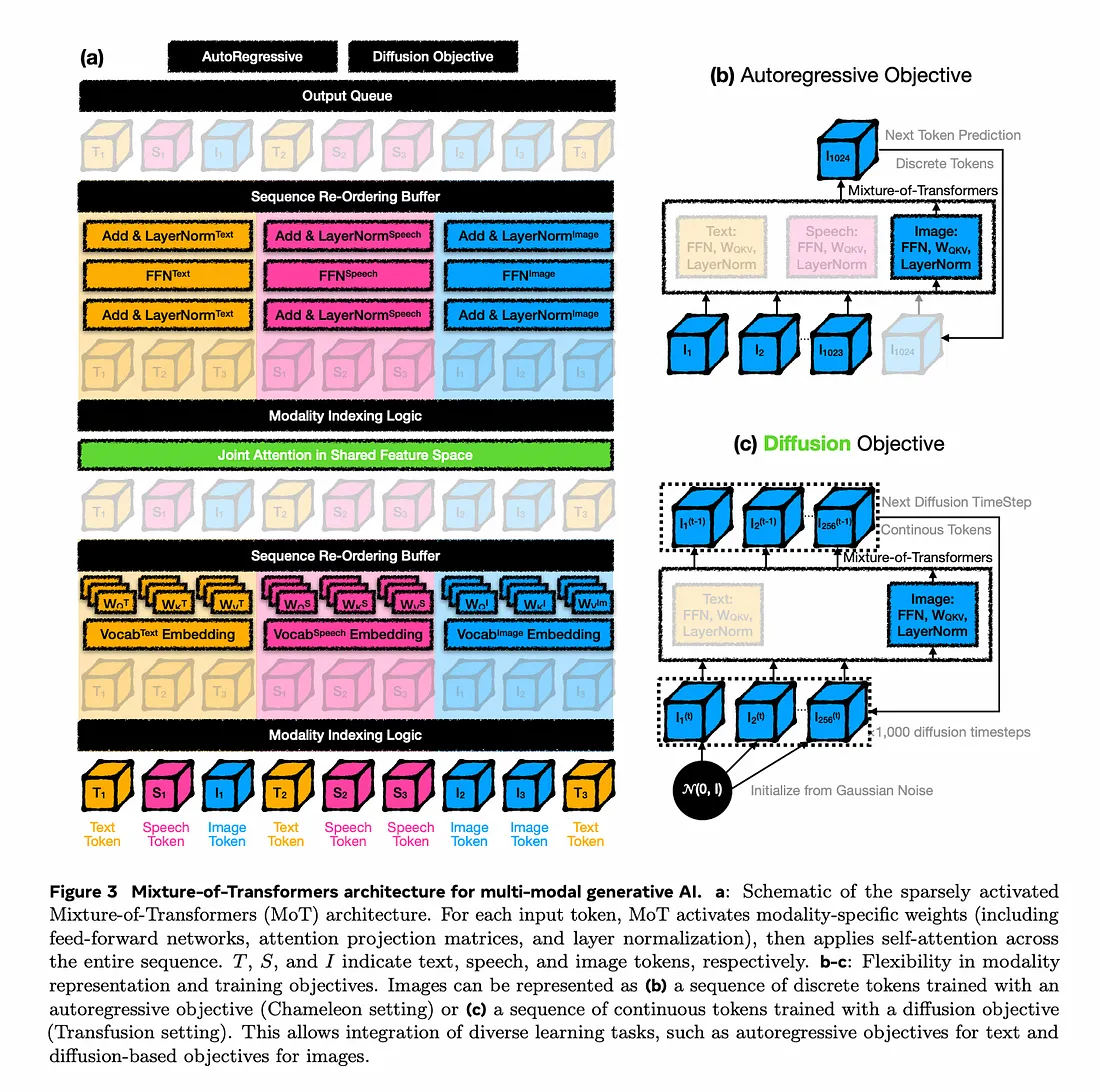

MoT 在关键领域按模态解耦参数:前馈网络、注意力矩阵和层规范化。每种模态(文本、图像、语音)都有一组专用于这些组件的参数,这使得它能够更有效地处理每种类型的数据。

这种方法允许对每种模态进行专门处理,同时仍保持对整个输入序列的全局自注意力。这意味着,尽管模型对每种模态都有单独的路径,但它仍然可以在统一的框架中捕获跨模态的关系

稀疏、高效处理

MoT的架构实现了参数的稀疏激活,这极大地降低了模型的整体浮点运算次数(FLOPs),同时保持了准确性。例如,在Chameleon设置(专注于文本和图像生成任务)中,MoT实现了与密集模型相当的性能,但仅使用了55.8%的FLOPs。当添加语音作为第三种模态时,MoT仅使用37.2%的FLOP就实现了与密集模型相当的性能。

跨模态的全局自注意力

尽管MoT使用了模态特定的参数,但它仍然在整个输入序列上保持全局自注意力。这一特性使MoT能够连贯地处理多模态数据,捕捉跨模态关系,同时保留每种模态的独特属性。这对于复杂的多模态任务尤其有价值,如结合文本、图像和语音信息生成描述。

灵活适应不同模态和目标

MoT旨在处理每种模态的多样化任务和目标。MoT架构适应不同类型的训练目标:

- 自回归目标:用于文本生成等任务,模型基于离散标记预测序列中的下一个标记。这对于生成文本或其他序列数据很有用。在这种情况下,图像标记被表示为离散标记(例如,从预训练的VQGAN模型生成)。

- 扩散目标:对于图像生成,模型可以使用基于扩散的方法,这涉及在多个步骤中逐渐从噪声中精炼出图像。这种设置使图像能够具有连续表示,从而提高图像质量和一致性。

这种适应性使MoT适用于广泛的多模态应用,从文本和图像生成到多目标训练设置。

MoT计算算法

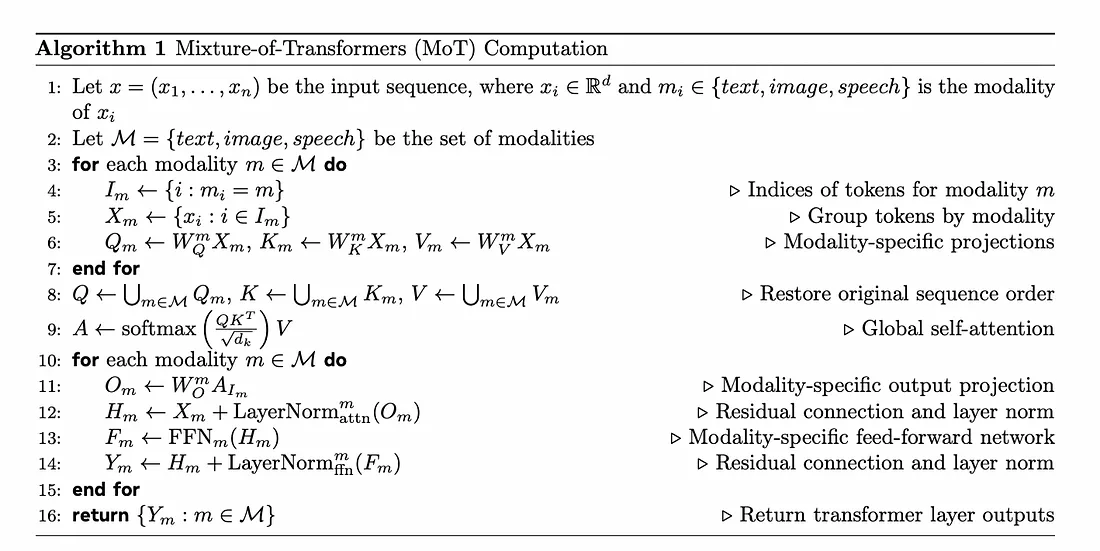

该算法描述了 Mixture-of-Transformers (MoT) 模型的计算过程,该模型是一种稀疏多模态转换器,旨在处理多种数据类型(模态),如文本、图像和语音。以下是算法中每一行的分步说明:

1. 定义输入序列:输入序列被表示为一系列标记,x=(x1,…,xn),其中每个标记xi属于特定的模态(文本、图像或语音)。

2. 模态集合:M\mathcal{M}M代表模态集合,包括文本、图像和语音。

3-7. 按模态分组和投影:

对于M中的每个模态m:

- 第4步:识别属于当前模态m的标记索引。

- 第5步:将当前模态的标记分组。

- 第6步:对查询(Qm)、键(Km)和值(Vm)应用模态特定的投影。这些投影创建了特定于每种模态的标记表示,使模型能够以不同的方式处理每种数据类型。

8. 重建完整序列:在分别对每个模态进行投影后,将Q、K和V的投影统一成一个序列,恢复所有模态中标记的原始顺序。

9. 全局自注意力:使用统一序列计算全局自注意力。这一步允许序列中的所有标记进行交互,无论它们属于哪个模态,从而实现跨模态学习。

10-15. 应用模态特定层:

对于每个模态m:

- 第11步:对注意力结果应用模态特定的输出投影。

- 第12步:添加残差连接和模态特定的层归一化。

- 第13步:将归一化后的输出通过模态特定的前馈网络(FFN)。

- 第14步:对FFN的输出应用另一个残差连接和层归一化。

16. 返回输出:最后,算法返回通过Transformer层处理后的每个模态的输出。

结论

总之,混合物Transformer(MoT)架构在多模态生成式AI方面取得了重大进展。通过将模态特定层与共享注意力机制相结合,MoT能够在单个模型内高效地处理多种数据类型——文本、语音和图像。这种方法使得每个模态都能得到最优处理,保留了每种数据类型的独特特性,同时实现了有意义的跨模态交互。

MoT支持不同训练目标(如文本的自回归目标和图像的基于扩散的目标)的灵活性,进一步凸显了其通用性和适应性。凭借其高效、稀疏的设计,MoT不仅降低了计算需求,还提高了多模态任务的性能,使其成为需要高效率、可扩展性和多模态理解的新一代AI模型的有前途的解决方案。