顶尖研究团队联合推出新型视觉语言模型LLaVA-X1,实现突破性自主推理

近日,由北京大学、清华大学、鹏城实验室、阿里巴巴达摩院及美国理海大学(Lehigh University)的科研团队携手合作,成功研发出LLaVA-X1模型。这是全球首个具备自发性(Spontaneous,具体含义见文末解读)特性的系统性推理视觉语言模型,其功能与GPT系列中的GPT-X1模型类似,但专注于视觉与语言的交叉领域。

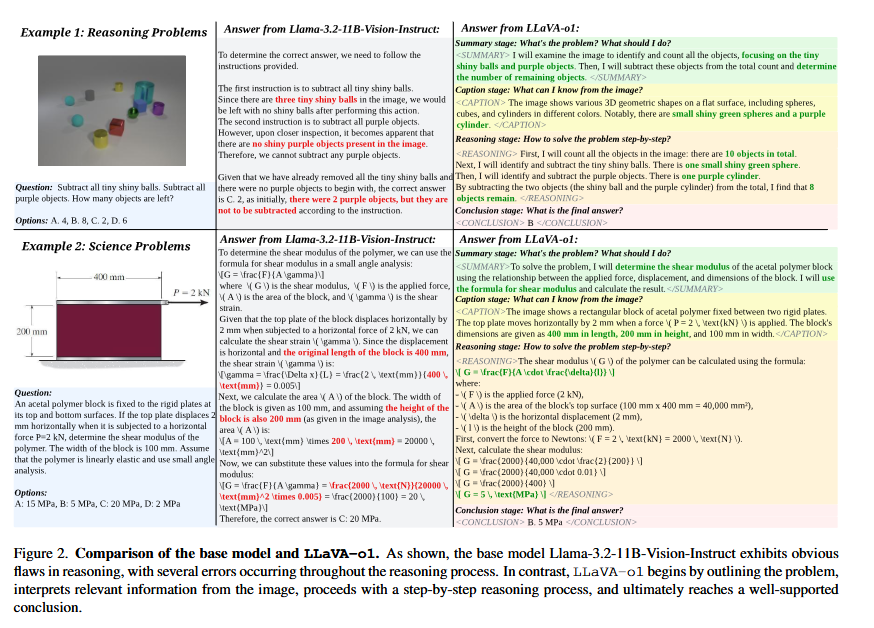

LLaVA-X1是一款创新的视觉语言模型(VLM),旨在实现自主且多阶段的推理过程。该模型拥有惊人的110亿参数,基于先进的Llama-3.2-Vision-Instruct架构进行开发,精心设计了四个核心推理阶段:总结(overview)、描述(narration)、推理(deduction)及结论(conclusion)。

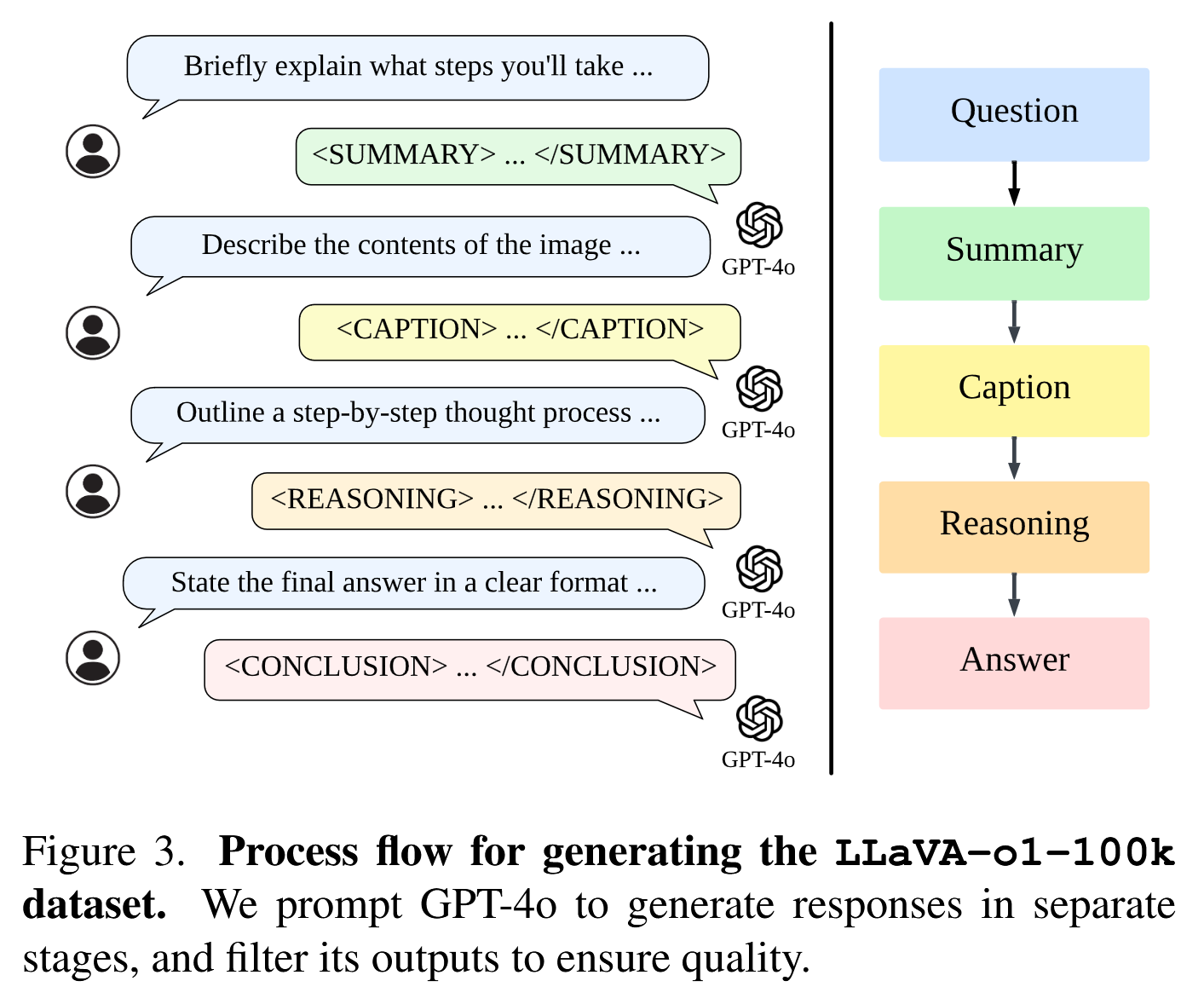

为了进一步提升LLaVA-X1的性能,研究团队采用了名为LLaVA-X1-100k的专属数据集进行微调。这一数据集融合了视觉问答(VQA)的丰富资源与GPT-4X生成的结构化推理注释,为模型提供了全面的训练素材。

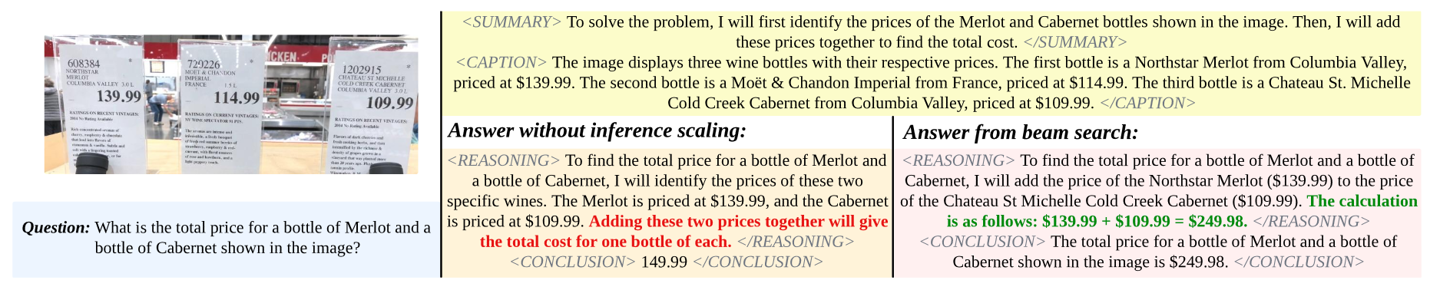

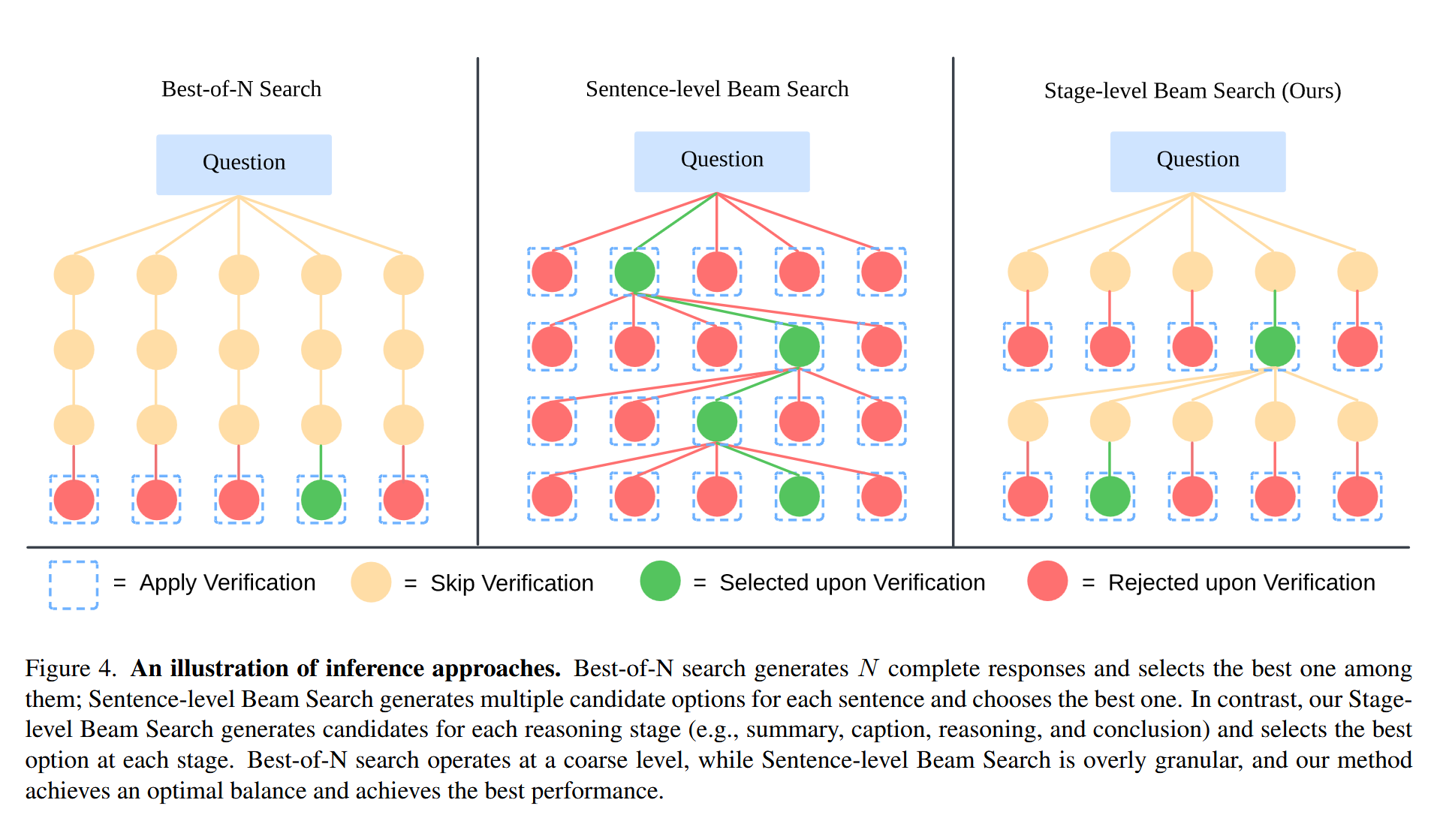

在推理机制上,LLaVA-X1引入了阶段级束搜索(stage-level beam search)技术,这一创新使得模型能够在每个推理阶段生成多个候选答案,并从中筛选出最优解。这一特性极大地增强了模型在处理复杂任务时的能力,尤其是在复杂视觉问答场景中,LLaVA-X1成功突破了传统视觉语言模型的局限。

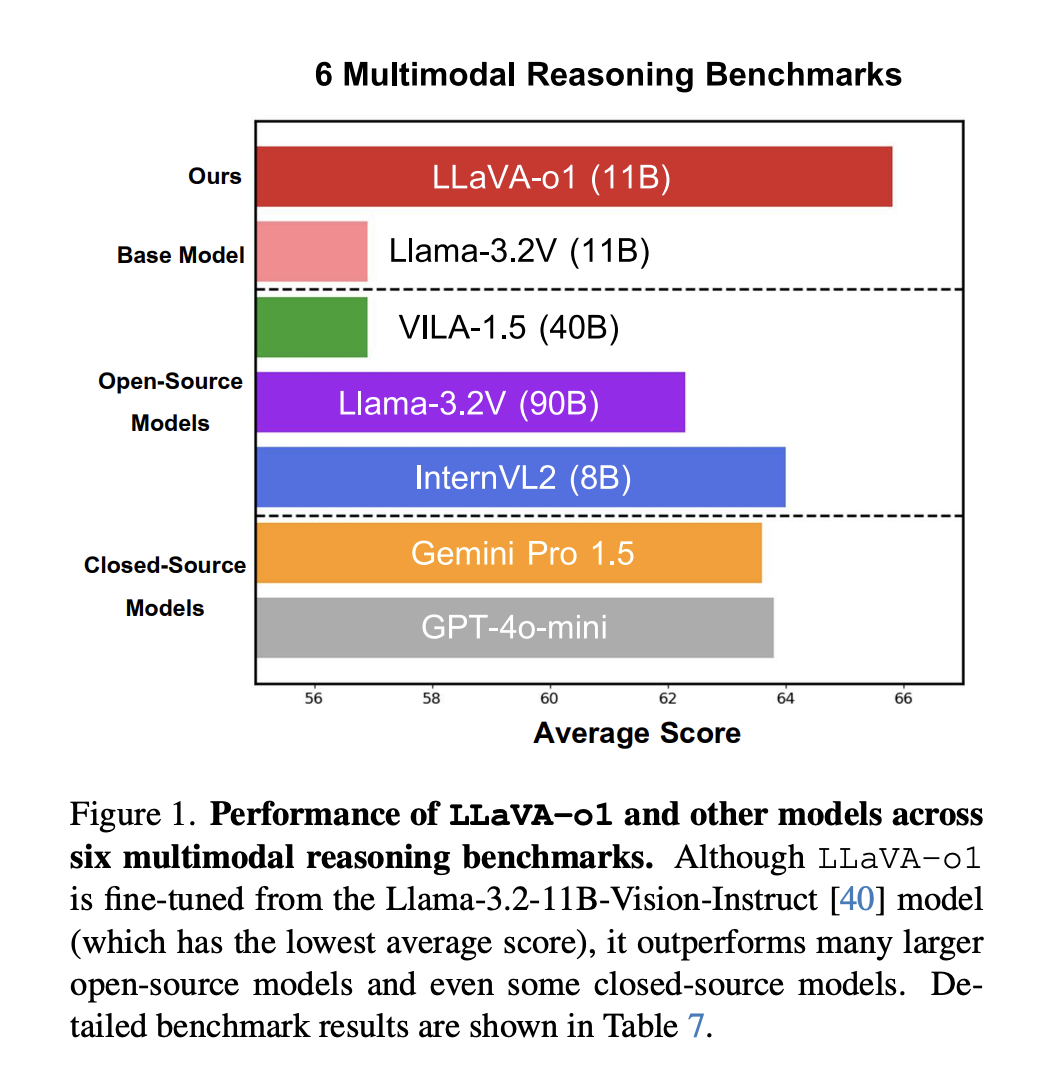

与基础模型相比,LLaVA-X1在多模态推理基准测试中表现出色,性能提升了8.9%,超越了众多大型且闭源的竞争对手。这一成就不仅验证了LLaVA-X1的卓越性能,也展示了其在视觉语言模型领域的领先地位。

LLaVA-X1的推出填补了文本与视觉问答模型之间的空白,其在多个基准测试中的优异表现,特别是在数学和科学视觉问题的推理领域,彰显了结构化推理在视觉语言模型中的重要性。这一成果不仅为人工智能领域带来了新的突破,也为未来的智能应用开发提供了广阔的前景。

关于自发性人工智能(Spontaneous AI),它指的是能够模拟动物自发行为的人工智能系统。这一领域的研究聚焦于如何通过机器学习和复杂时间模式的设计,创造出具有自发行为的机器人或智能系统。LLaVA-X1的推出,标志着自发性人工智能在视觉语言模型领域迈出了重要的一步。