SEALONG:提升法学硕士长上下文推理能力的方法

现有方法通常涉及使用合成数据对大型语言模型(LLM)进行微调,这依赖于人类专家或如GPT-4等高级模型的标注,从而限制了进一步的进步。为了解决这一问题,本文提出了SEALONG方法,这是一种使LLM在长文本推理中实现自我提升的方法。该方法包括为每个问题采样多个输出,使用最小贝叶斯风险(Minimum Bayes Risk)对这些输出进行评分,然后基于这些输出进行监督微调或偏好优化。

LLM在长文本推理中的潜力

i) 长文本推理的提示策略

研究了以下策略:

a) 默认策略:向LLM提供长文本和一个问题。

b) 直接回答:要求LLM基于长文本直接回答问题。

c) 分步思考:向LLM提供文本、问题以及一个指示,要求其分步进行思考。

d) 事实与反思:向LLM提供长文本、问题以及一个指示,要求其首先从长文本中识别相关信息,然后进行分步推理并提供答案。

e) 计划与解决:向LLM提供长文本、问题以及一个指示,要求其首先制定计划,然后按照计划分步解决问题。

ii) LLM正确进行长文本推理的潜力

- 使用温度采样为每个问题生成多个输出,使用SubEM对每个输出进行评估,并将得分最高的输出指定为最佳样本。

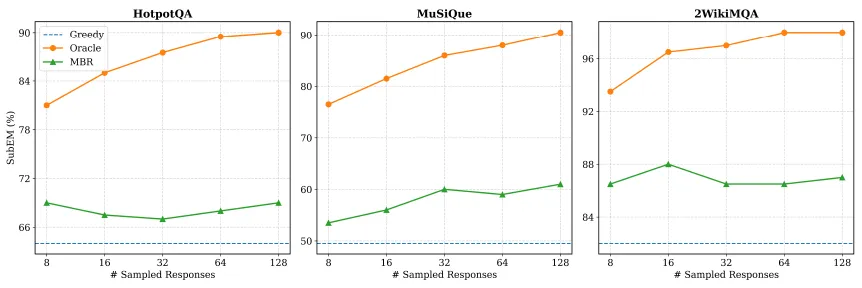

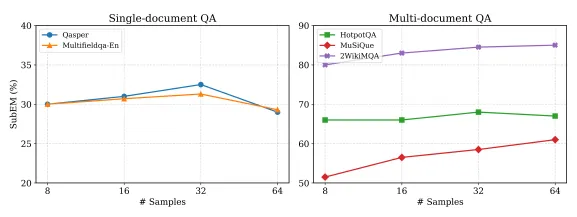

- 下图显示了增加采样输出的数量可以提高最佳样本和MBR解码的性能,结果基于Llama-3.1–8B-Instruct模型。

上图显示,即使只有8个输出,最佳性能(oracle performance)与贪婪搜索(greedy search)之间也存在显著差距。当样本数量增加到128个时,正确率达到了90%以上。

上述结果强调了LLM在长文本推理方面的潜力,并激励我们开发能够使LLM在这一领域自我提升的方法。

SEALONG

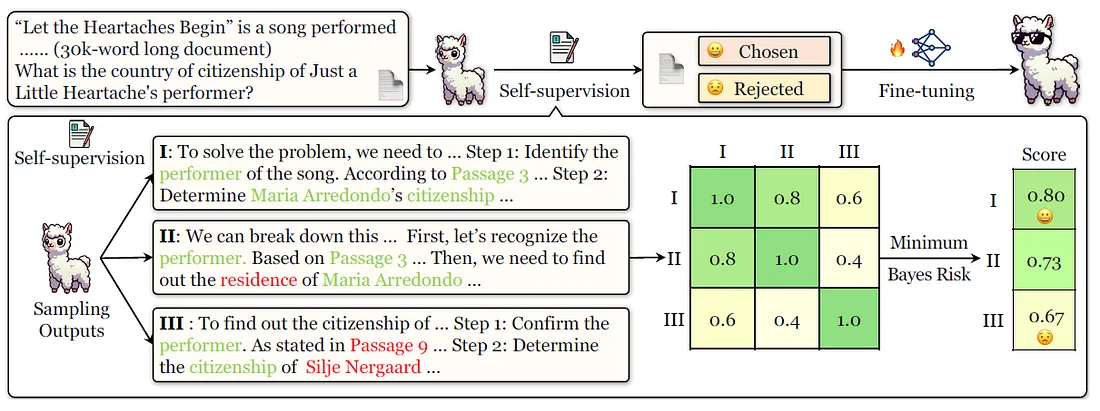

SEALONG方法概述如下图所示:

SEALONG方法包含以下两个阶段:

i) 自监督阶段

- 首先,利用“计划与解决”提示策略,为每个问题及其对应的长文本采样多个推理轨迹。

- 基于正确的推理轨迹通常表现出更高的语义一致性这一想法,我们使用最小贝叶斯风险(MBR)来为每个输出分配一个分数,这个分数会优先考虑与其他输出一致性更高的输出。

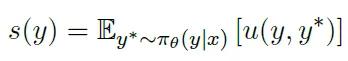

- 在MBR中,一个输出的质量是通过模型分布下其预期效用来评估的。

s(y) 是赋给输出 y 的分数,其中 x 表示输入,包括长文本、问题和指令。项 π

θ(y∣x) 代表LLM的策略分布,而效用度量 u(y,y ∗ ) 则基于 y∗ 来评估 y。

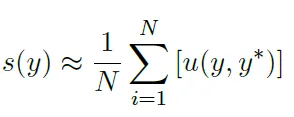

- 我们使用蒙特卡洛方法,通过 N 个采样输出来近似这个期望值,以衡量两个输出之间的一致性:

- 我们使用了一个轻量级的基于RoBERTa的模型来嵌入输出,并通过内积来衡量它们之间的相似性。

- 我们为每个输出 y 分配了一个分数 s(y),并选择分数最高的输出,这被称为MBR解码。

ii) 微调阶段

a) 监督微调

- 接下来,我们使用得分最高的输出进行微调。

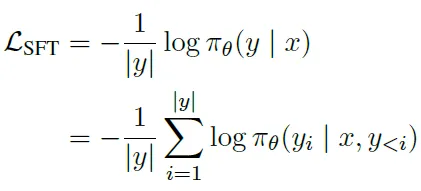

- 通过最小化输出的负对数似然来进行微调,具体如下:

其中 y 表示MBR解码的输出。

b) 偏好优化

- 或者,也可以进行偏好优化,以强化倾向于高得分的输出,并降低低得分输出的可能性。在这里,我们同时使用了高得分和低得分的输出。

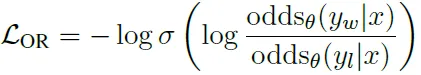

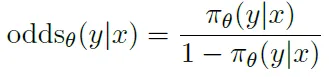

- 由于其在实证中的优异表现,我们采用了单体优势比偏好优化(ORPO)算法。ORPO引入了一个优势比损失,以最小化优选输出 yw和较不优选输出 yl之间的负对数优势比。

其中,σ 表示sigmoid函数,而oddsθ(y∣x)衡量的是y被生成的可能性与不被生成的可能性的比值。

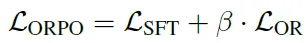

- ORPO的最终目标结合了SFT(监督微调)损失和OR(优势比)损失,通过超参数β来控制它们的相对重要性。

- 在这项实现中,我们将MBR解码的输出作为yw,并随机选择一个低得分的输出作为yl。

实验

i) 实现

- SEALONG需要查询和长文本对来合成训练数据。

- 我们利用了MuSiQue的训练数据集,其中每个问题都与几个维基百科文档相关。

- 为了达到上下文中指定的标记数量,我们随机抽取了一些不相关的文档,将它们与相关文档混合并拼接成一个单一的上下文。

- 我们使用MuSiQue中的原始问题,但不使用标注的答案,而是依赖LLM来产生自监督。

- 我们使用Llama-3.1模型和Qwen-2.5模型进行实验,并使用jina-embeddings-v3作为句子嵌入模型。

- ORPO被用作默认的微调方法。

ii) 结果

a) SEALONG提升了各种模型

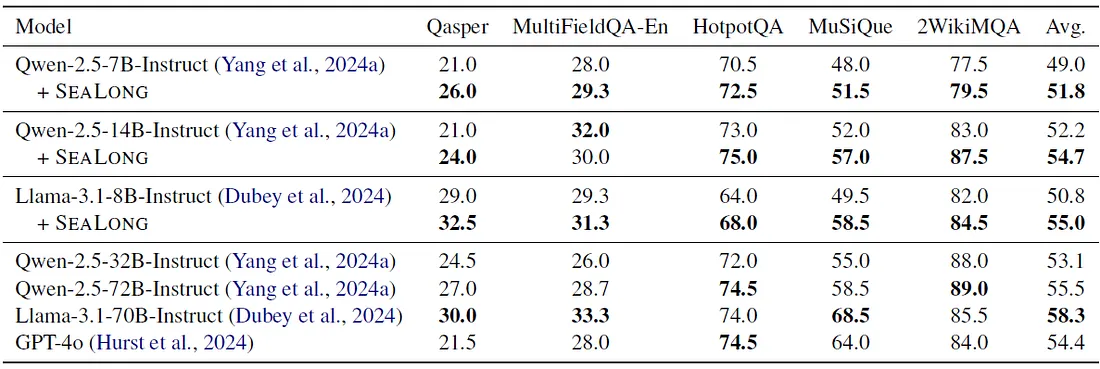

- 下表显示了评估结果,其中使用了子字符串精确匹配(SubEM)作为评估指标。

- SEALONG带来了显著的改进:当在Qwen-2.5-7B-Instruct上实施时,它缩小了与Qwen-2.5-14B-Instruct之间的性能差距(51.8对比52.2);当应用于Qwen-2.5-14B-Instruct时,它甚至超过了Qwen-2.5-32B-Instruct的性能(54.7对比53.1)。

- 在Llama-3.1-8B-Instruct上,SEALONG实现了4.2的绝对改进,超越了GPT-4o。

b) SEALONG与以往数据集的比较

我们将SEALONG与几个以往的数据集进行了比较,结果基于在相应数据集上微调后的Llama-3.1-8B-Instruct模型。

我们观察到SEALONG带来了性能提升(从50.8提升到55.0),这表明自我改进是有前景的。

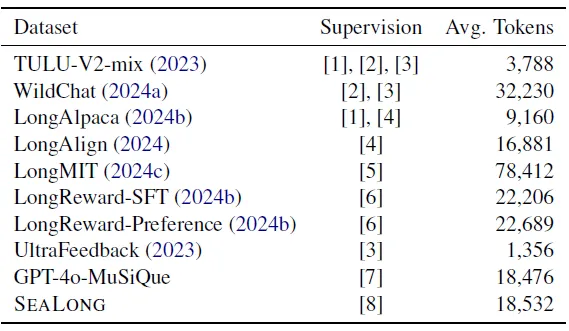

数据集统计信息如下表所示:

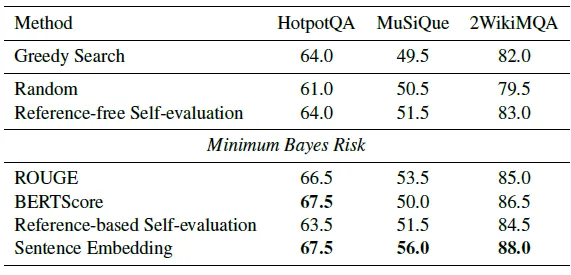

c) 评分方法

比较了各种评分方法和贪婪搜索。每种评分方法都对从Llama-3.1–8B-Instruct中采样的16个输出进行了评估。

结果显示,基于MBR的方法优于无参考的自我评估,即使使用简单的基于N-gram的ROUGE也是如此。

d) 合成示例的数量

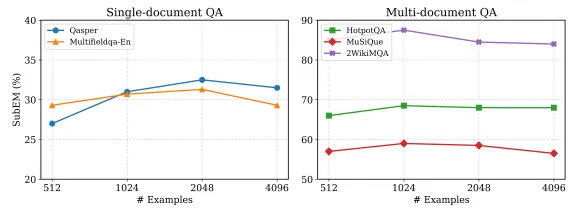

下图显示了SEALONG在不同数量的合成训练示例下的长文本性能,评估基于在相应数据集上微调的Llama-3.1–8B-Instruct模型。

SEALONG展现出了强大的数据效率,仅需1K个示例就能达到有竞争力的性能,之后增加示例带来的额外收益有限。

e) 每个示例的样本数量

下图显示了SEALONG在数据合成过程中每个示例具有不同样本数量时的长文本性能,评估基于在相应数据集上微调的Llama-3.1–8B-Instruct模型。

将N从8增加到32可以持续提高性能,这可能是因为MBR(最大后验概率)估计更加准确。

f) 短文本性能

提升长文本推理能力不应牺牲短文本性能。

局限性

- 最高MBR得分输出与最优样本之间仍存在显著的性能差距。

- 依赖MuSiQue生成合成数据,而MuSiQue包含的是跨越多个段落的多跳问题,它并未涵盖所有具有挑战性的问题类型,如需要全文推理的问题,这仍然是当前长文本LLM(大型语言模型)的一个关键局限。

- 将SEALONG的实施限制在参数最多为140亿的LLM上,尽管其在更大规模上的有效性值得进一步研究。

结论

我们研究了LLM在长文本推理中自我提升的潜力,并为此提出了SEALONG方法。该方法在多个长文本推理任务上取得了显著改进。