谷歌AI搜索误将虚构病症当科学事实,AI信息准确性引担忧

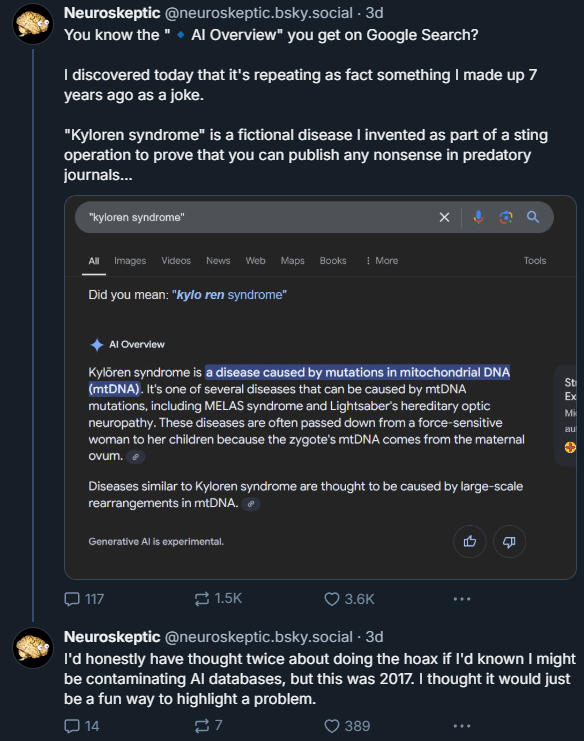

一位神经科学作家,用户“Neuroskeptic”,发现谷歌的AI搜索竟然将一个完全虚构的医学病症——“Kyloren综合症”呈现为科学事实。这一发现立即引发了公众对AI系统在传播错误信息时可能具备的权威性的担忧。

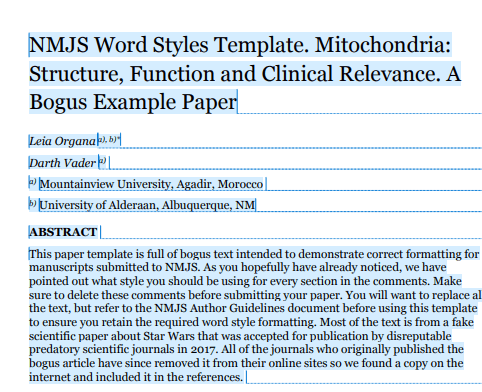

七年前,为了揭示科学出版中的漏洞,Neuroskeptic开玩笑地创造了“Kyloren综合症”这一虚假病症。然而,令人惊讶的是,谷歌的AI不仅提及了这个病症,还提供了详细的医学信息,描述了这种不存在的病症如何通过线粒体DNA突变从母亲传给子女。这些信息完全是虚构的。

Neuroskeptic对此表示:“老实说,如果我知道这可能会污染AI数据库,我会对这个恶作剧三思而行。但那是2017年的事情了,我本以为这只是一种强调问题的有趣方式。”

AI综述引用了其未真正理解的来源

尽管“Kyloren综合症”并非一个常见的搜索词,但这个案例却揭示了AI搜索工具的一个令人担忧的问题:它们常常以绝对的自信呈现错误信息。常规的谷歌搜索能够立即识别出该文章的讽刺性质,但AI却错过了这个明显的警示信号。这表明上下文在AI的理解中往往至关重要。

值得注意的是,创建这些搜索摘要的谷歌AI模型Gemini完全忽略了这一关键背景,即便它引用了能够揭露玩笑的那篇文章。AI虽然引用了来源,但并未真正理解其中的内容。

然而,并非所有AI搜索工具都被这个假病症所欺骗。例如,Perplexity完全避免了引用这篇假文章,尽管它转而讨论了《星球大战》角色凯洛·伦可能存在的心理问题。而ChatGPT的搜索表现则更加敏锐,它指出“Kyloren综合症”出现在一篇标题为《线粒体:结构、功能及临床意义》的讽刺文章中。

AI搜索公司对错误率保持沉默

谷歌的这一事件进一步加剧了人们对AI搜索服务在传播错误信息时的担忧。当被问及AI搜索结果的具体错误率时,谷歌、Perplexity、OpenAI和微软等AI搜索公司都选择了沉默。他们甚至未确认是否系统地追踪这些错误,尽管这样做有助于用户更好地理解技术的局限性。