Hugging Face发布SmolVLM:轻量级视觉语言模型,推动AI普及化

近年来,随着对能够高效处理视觉和语言任务的机器学习模型需求的不断增长,如何在性能和资源需求之间找到平衡,尤其是在笔记本电脑、消费级GPU或移动设备等资源有限的环境下,成为了一个亟待解决的挑战。许多视觉语言模型(VLM)因需要大量的计算能力和内存,而在设备应用中显得不切实际。例如,尽管Qwen2-VL模型性能可靠,但其对昂贵硬件和大量GPU内存的需求,限制了其在实时设备任务中的普及和实用性。因此,市场对能够以最少资源提供强大性能的轻量级模型的需求日益迫切。

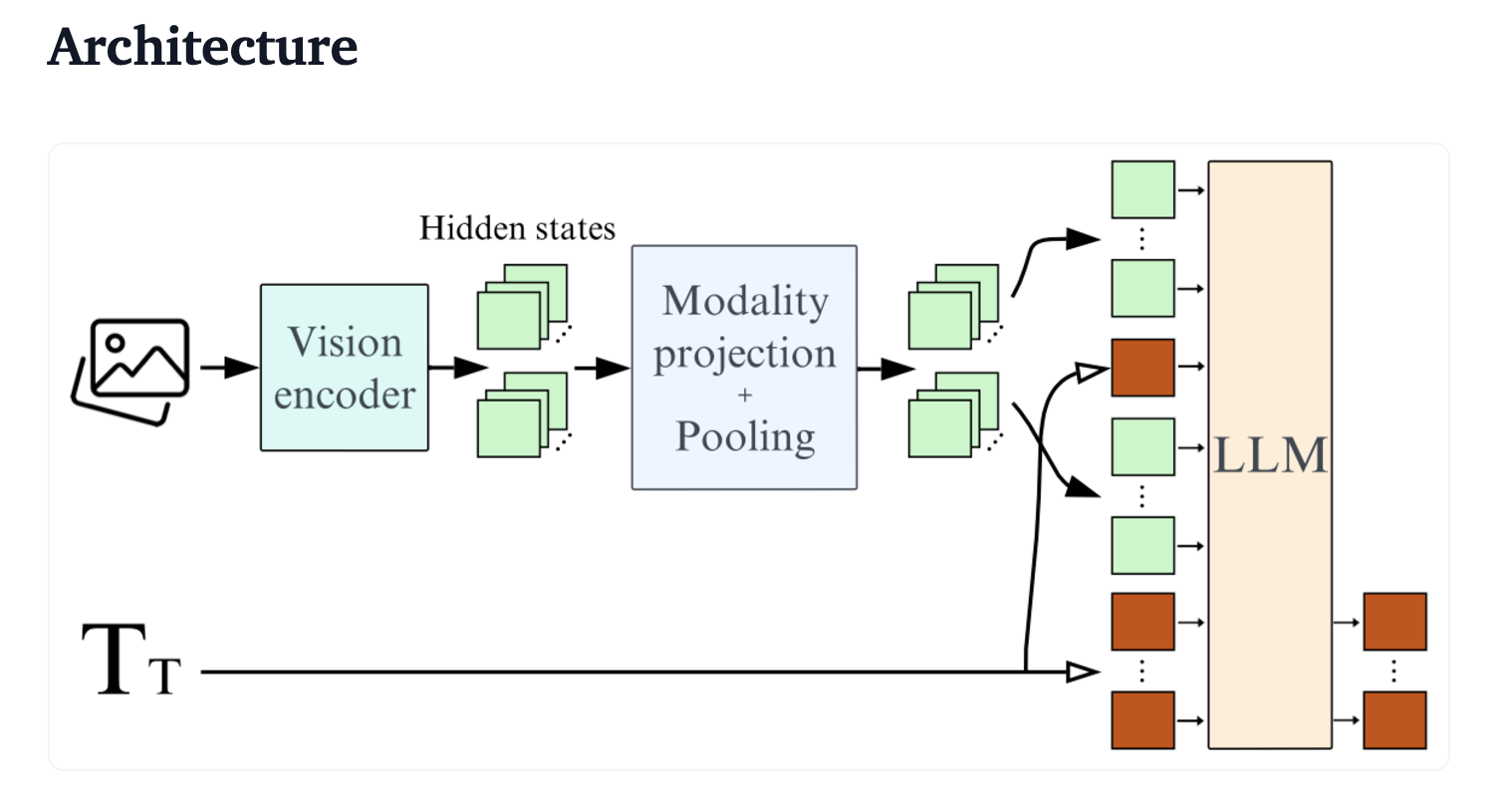

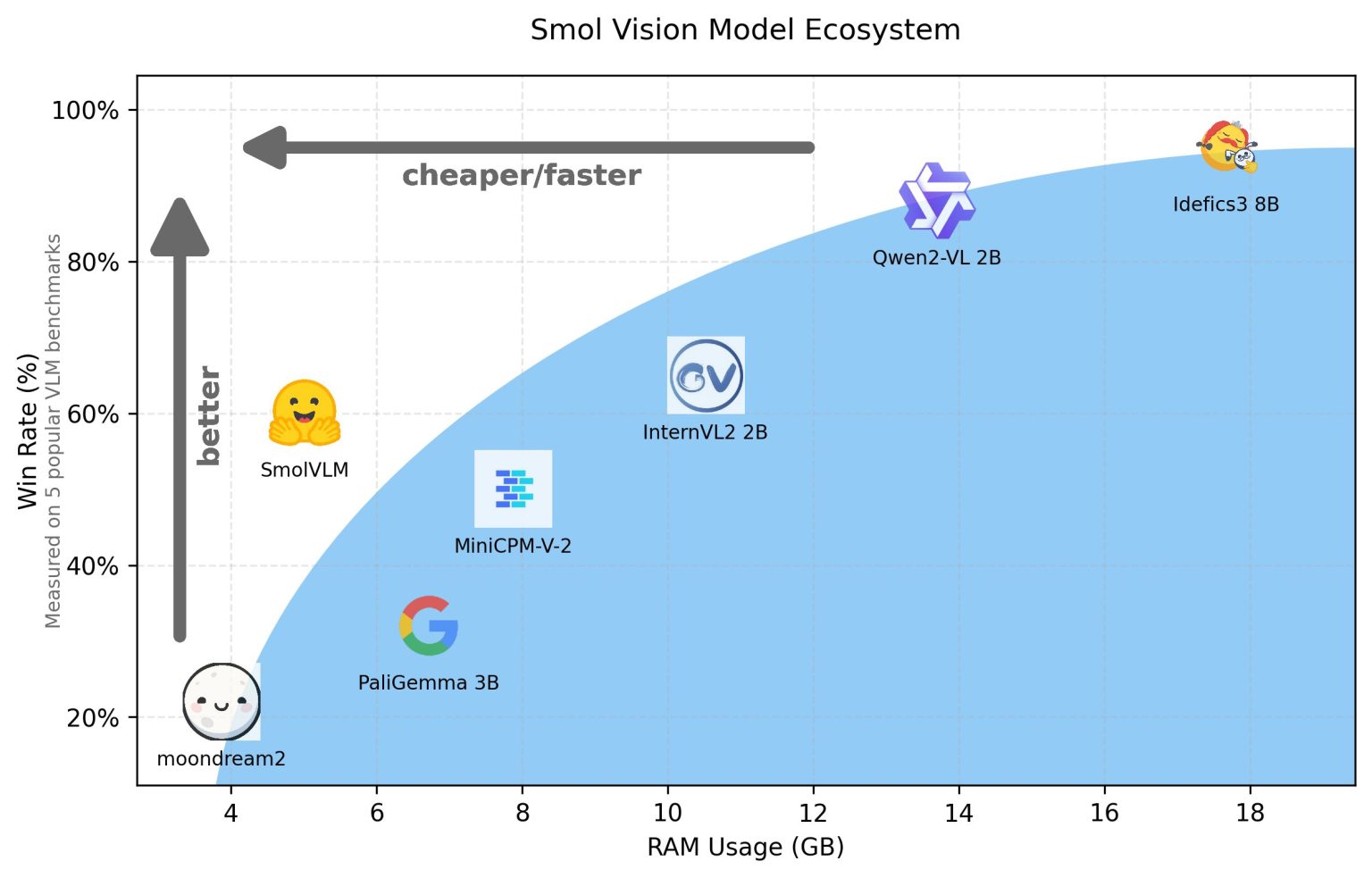

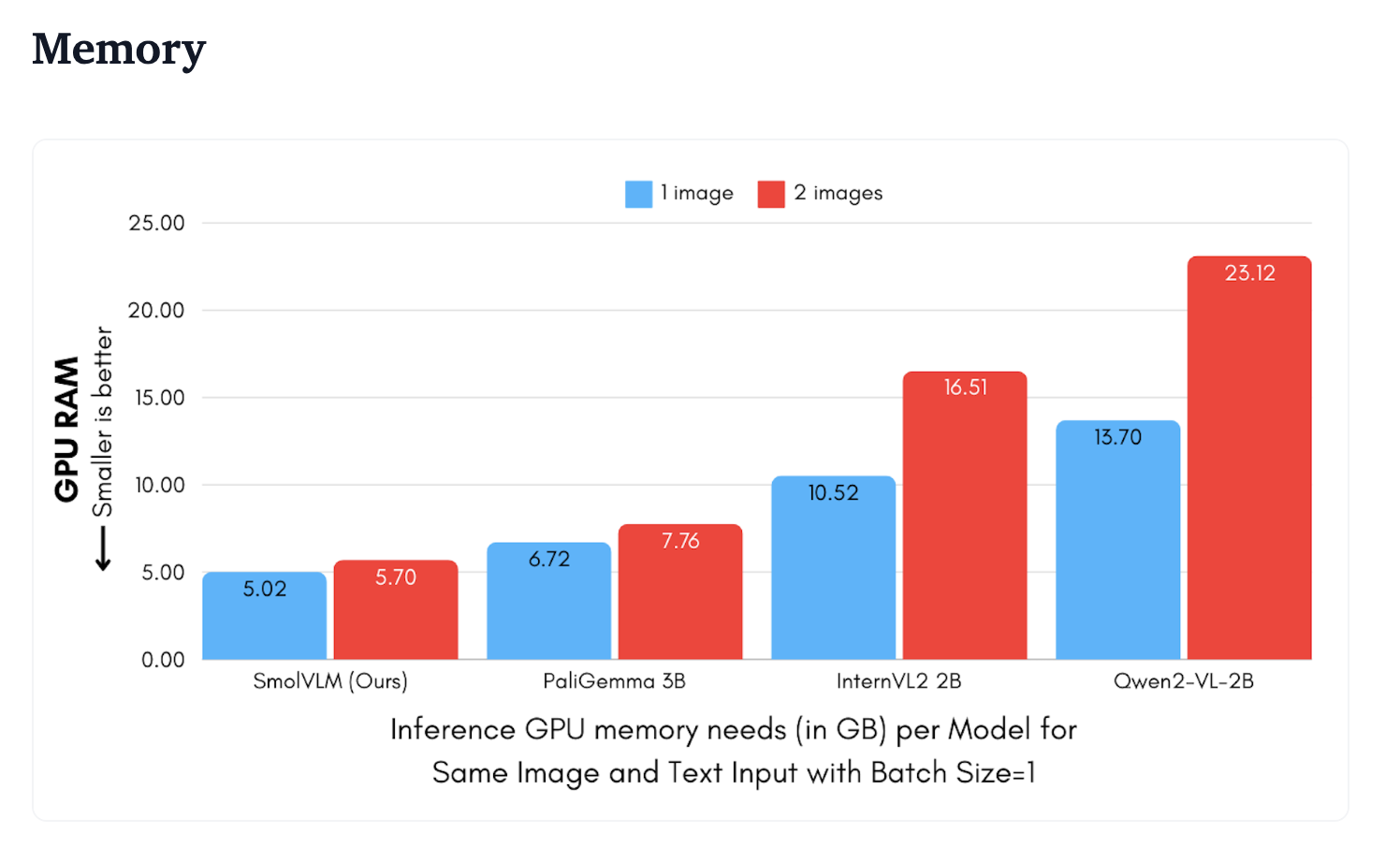

为了满足这一需求,Hugging Face近期发布了SmolVLM,这是一个专为设备推理设计的20亿参数视觉语言模型。与其他在GPU内存使用和令牌吞吐量上相当的模型相比,SmolVLM展现出了更出色的性能。其关键特点在于能够在较小的设备上有效运行,包括笔记本电脑或消费级GPU,同时保持卓越的性能。在相似大小和功能的模型中实现性能和效率之间的平衡是一项极具挑战性的任务,但SmolVLM凭借其优化的架构,成功偏向了轻量级推理,从而实现了这一目标。

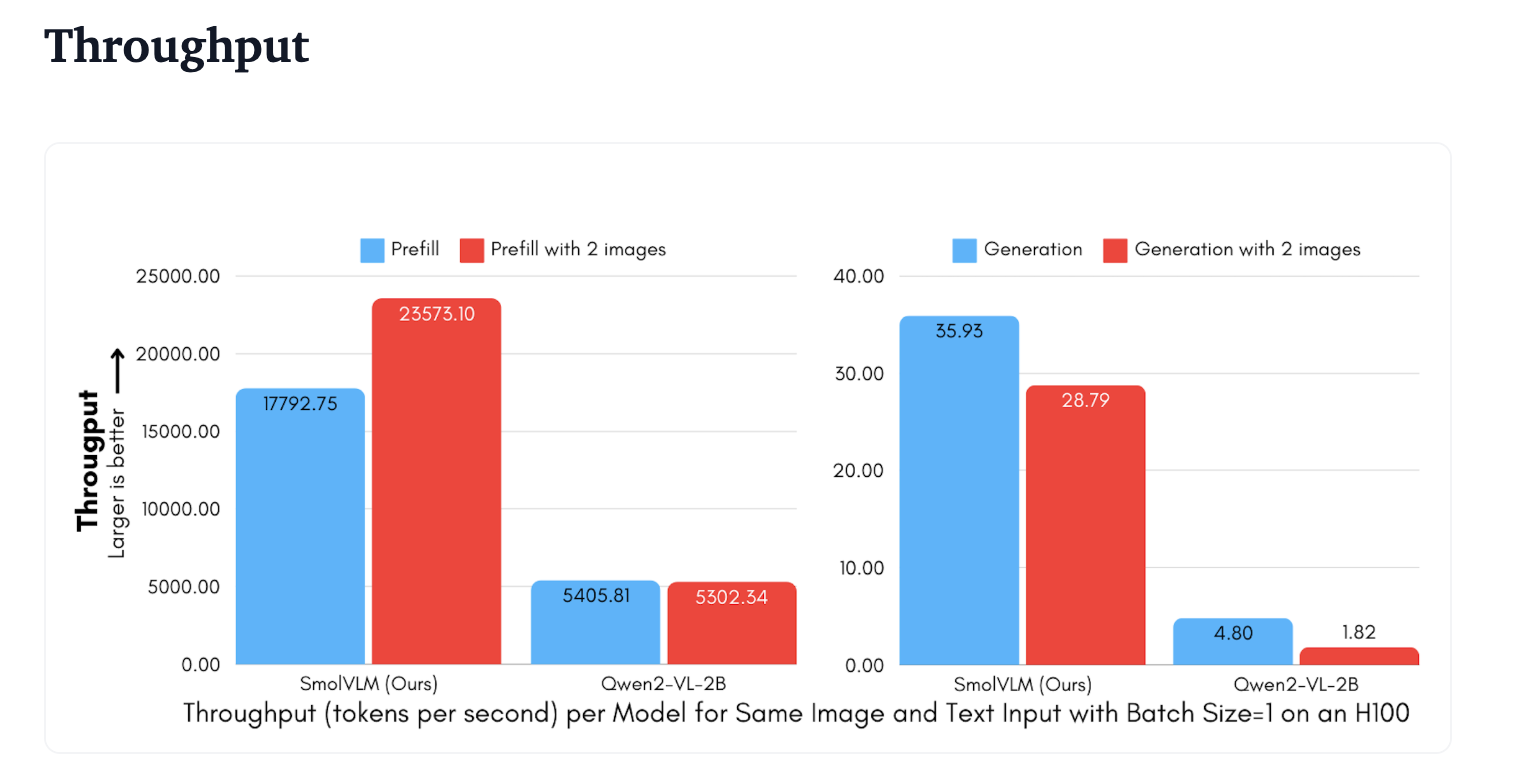

从技术角度来看,SmolVLM的优化架构使其能够高效地进行设备上的推理。它可以在Google Colab上轻松进行微调,使得资源有限的研究人员、开发人员和爱好者也能够进行实验和开发。其轻便性使得它可以在笔记本电脑上平稳运行,或使用消费级GPU处理数百万个文档。SmolVLM的主要优势之一在于其较小的内存占用,这使得它可以部署在以前无法处理类似大小模型的设备上。在令牌生成吞吐量方面,SmolVLM的效率尤为显著,其令牌生成速度比Qwen2-VL快7.5到16倍。这种性能提升主要得益于SmolVLM的简化架构,该架构优化了图像编码和推理速度。尽管与Qwen2-VL具有相同数量的参数,但SmolVLM的高效图像编码可以防止设备超载,这是Qwen2-VL经常导致像MacBook Pro M3这样的系统崩溃所无法比拟的优势。

SmolVLM的重要性在于它能够在不需要高性能硬件的情况下提供高质量的视觉语言推理。这对于希望在视觉语言任务上进行实验研究和开发,但不愿投资于昂贵GPU的研究人员、开发人员和爱好者来说,无疑是一个重大利好。在团队进行的测试中,SmolVLM通过50帧YouTube视频评估展示了其效率,并产生了在CinePile上进一步测试的结果。CinePile是一个评估模型理解电影视觉能力的基准。结果显示,SmolVLM的得分为27.14%,位于两个资源密集型模型InternVL2(2B)和Video LlaVa(7B)之间。值得注意的是,SmolVLM并未在视频数据上进行训练,但在效果上与为此任务设计的模型相当,这充分展示了其鲁棒性和多功能性。此外,SmolVLM在实现这些效率提升的同时,还保持了准确性和输出质量,这凸显了在不牺牲性能的情况下创建更小模型的可能性。

总之,SmolVLM代表了视觉语言模型领域的重大进步。通过在日常设备上运行复杂的VLM任务,Hugging Face填补了当前AI工具领域的一个重要空白。SmolVLM在其类别中与其他模型竞争,并在速度、效能和设备使用的实用性方面经常超越它们。凭借其紧凑的设计和高效的令牌吞吐量,SmolVLM将成为那些需要强大视觉语言处理能力但没有高端硬件设备的人的宝贵工具。这一发展有望扩大VLM的使用范围,使复杂的AI系统更加普及和可访问。随着人工智能变得越来越个性化和普遍化,像SmolVLM这样的模型将为更广泛的受众提供强大的机器学习功能,铺平通往智能未来的道路。