Ai2发布OLMo 2:全面开源的语言模型新版本

2024年11月28日 由 daydream 发表

363

0

近日,AI研究机构Ai2推出了其开源语言模型系列中的最新成员——OLMo 2。与LLama、Gemma等流行的开源权重模型不同,OLMo(全称Open Language Model)不仅提供模型权重,还包含了开发工具、数据集、训练指南等全套资源,实现了全方位的开源。

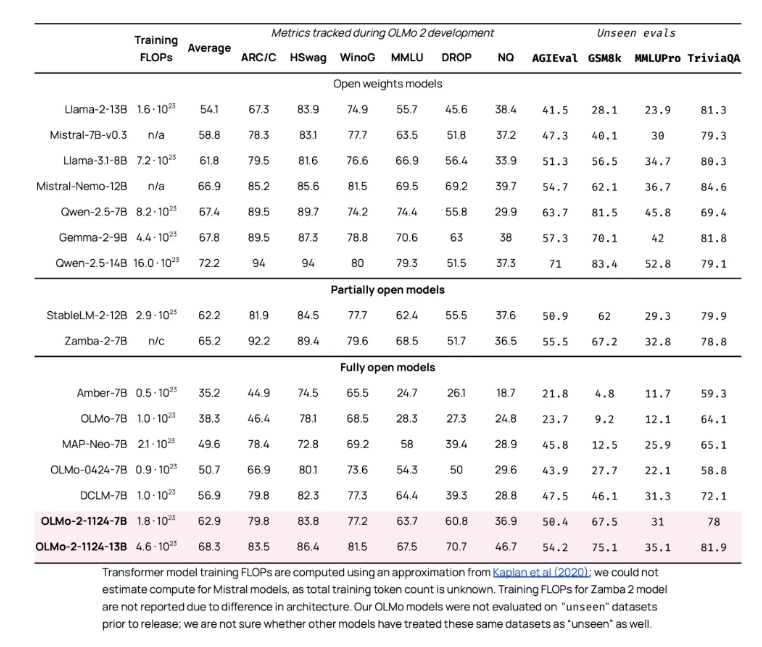

OLMo 2系列包括70亿参数(基础版、指令版)和130亿参数(基础版、指令版)两个版本,均展现出强大性能。其中,70亿参数版本在英语学术基准测试中表现优于Meta的LLama 3.1 80亿参数版本;而130亿参数版本则在训练时使用了更少的计算资源,却超越了Qwen 2.5 70亿参数版本。

此次发布是在今年早些时候推出的首款OLMo模型的基础上进行的。Ai2团队采用了一种创新的双阶段训练策略:首先在大规模数据集(包含3.9万亿个标记)上进行初步训练,随后使用高质量的学术内容、数学练习册和指令集数据进行精细化训练。

为确保训练稳定性,团队进行了关键性调整,以防止长时间训练过程中出现性能下降。这些调整涉及模型架构和训练流程的改进。

此外,OLMo 2的发布还建立在Ai2近期开发的开源训练系统Tülu 3的基础上。Tülu 3作为一个先进的后训练处理过程,使OLMo 2能够执行与世界顶级模型相媲美的指令遵循任务。

本次发布的完整内容包括评估框架和中间检查点,这些工具将帮助研究人员深入了解OLMo 2的性能,并在此基础上进行改进。

研究人员和开发者可通过Ai2的在线平台访问OLMo 2,或从Hugging Face平台下载。该模型采用Apache 2.0许可证,允许任何人无限制地学习、修改或在其基础上进行开发。

文章来源:https://www.maginative.com/article/ai2-releases-olmo-2-the-most-capable-fully-open-ai-model/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消