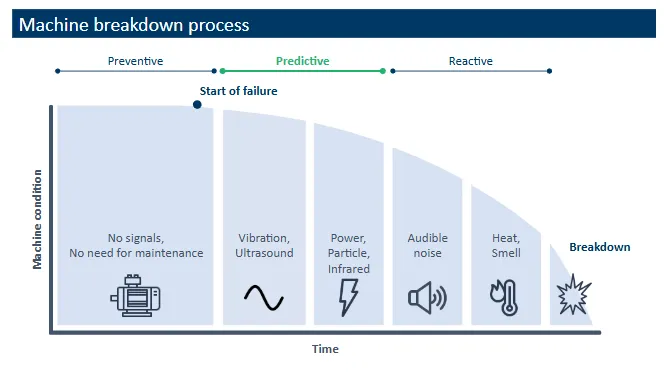

利用无监督学习算法,提升预测性维护效率

在发电行业研究数据科学多年后,我意识到最有效的预测性维护工具是无监督机器学习算法。

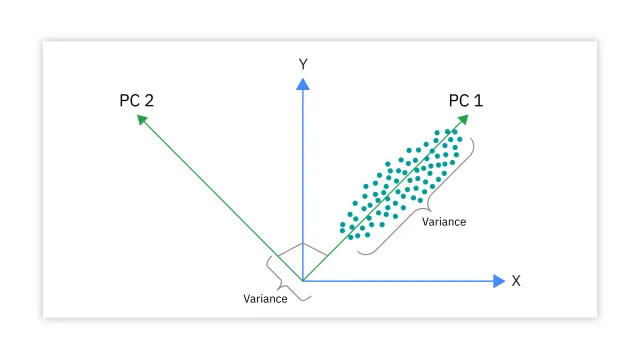

让我们从最古老且最基础的算法之一主成分分析(PCA)开始说起。主成分分析由卡尔·皮尔逊于1901年开发。主成分分析擅长降维,从而降低模型复杂性(即维度灾难),消除多重共线性和过拟合。此外,主成分分析还可以用于可视化和识别趋势、模式或异常值。

主成分分析可以在没有标签的情况下降低维度。它还可以进行因子分析和特征提取。主成分分析会创建新的变量,如主成分,这些变量是原始变量的线性组合。它将高维数据转换为一个具有更少变量的低维数据集。主成分分析是一种用于数据分析的无监督机器学习技术。在学习主成分分析时,有一些关键词需要了解,如特征值、特征向量和协方差。

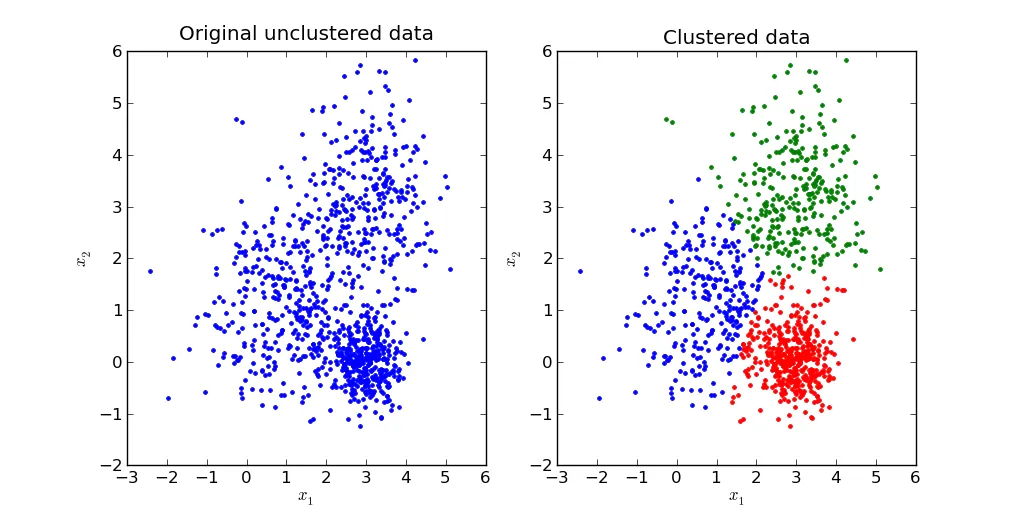

另一种基本的无监督学习技术是k均值聚类。主成分分析用于降低数据的维度,而k均值聚类则根据相似性将数据点分组在一起。它们的目标和方法各不相同。

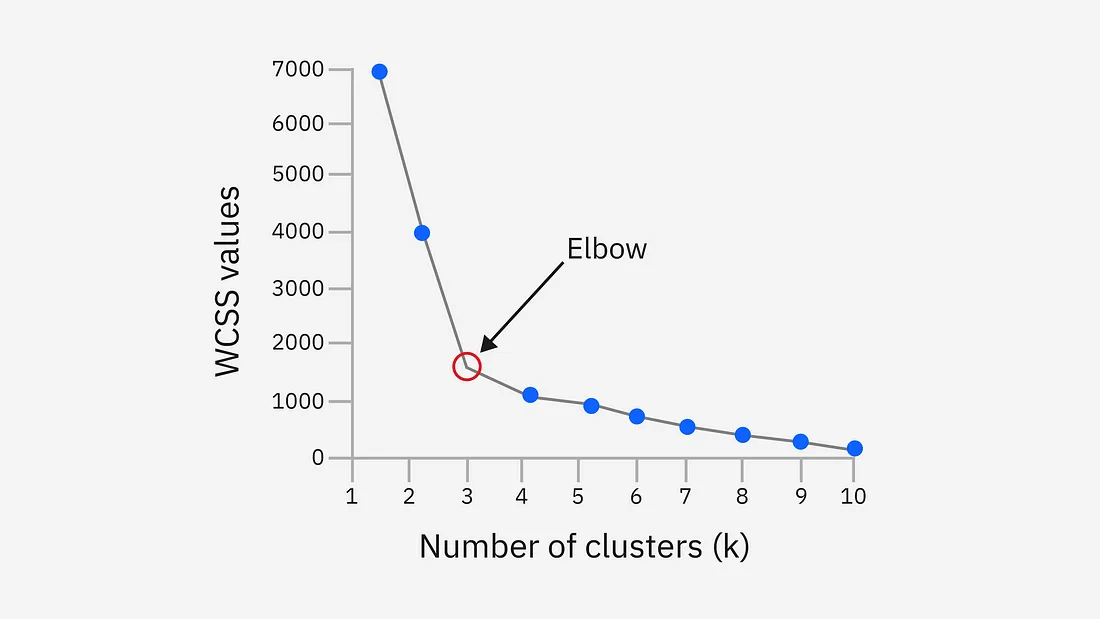

K均值是一种基于质心的迭代聚类算法。质心,或称为聚类中心,根据数据的特性,可以是聚类内所有点的均值或中位数。第一步是初始化k个质心,其中k等于为特定数据集选择的聚类数量。K均值算法中的关键词包括肘部法(Elbow method)和聚类内平方和(WCSS)。

K均值的优点是简单、快速、可扩展性强。

K均值的缺点是依赖于输入参数、在某些数据集上可能表现不佳、受异常值影响显著。

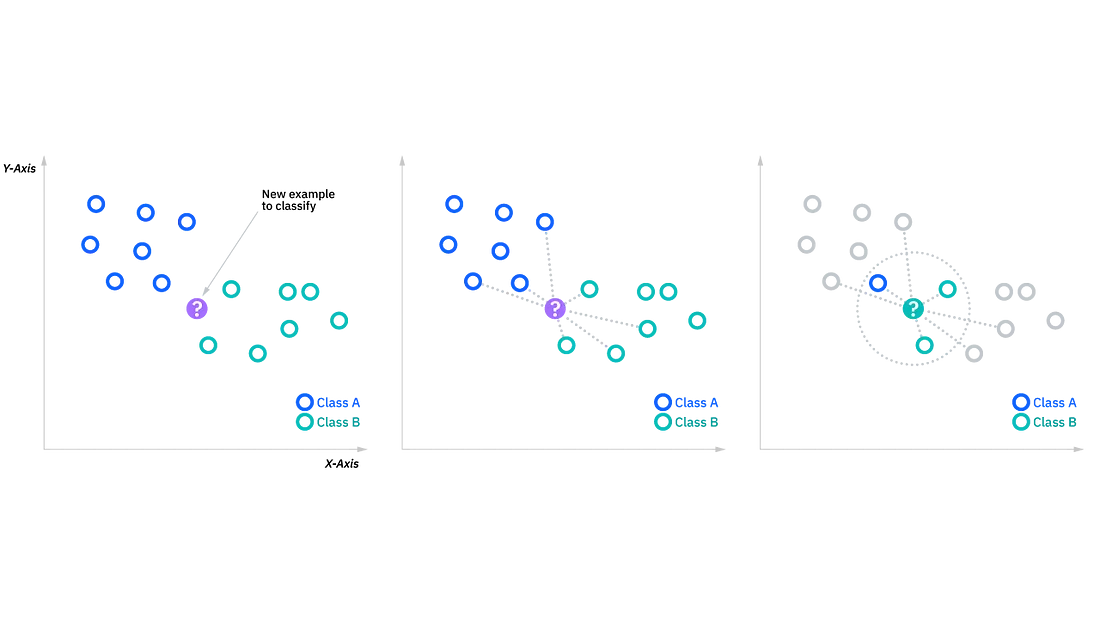

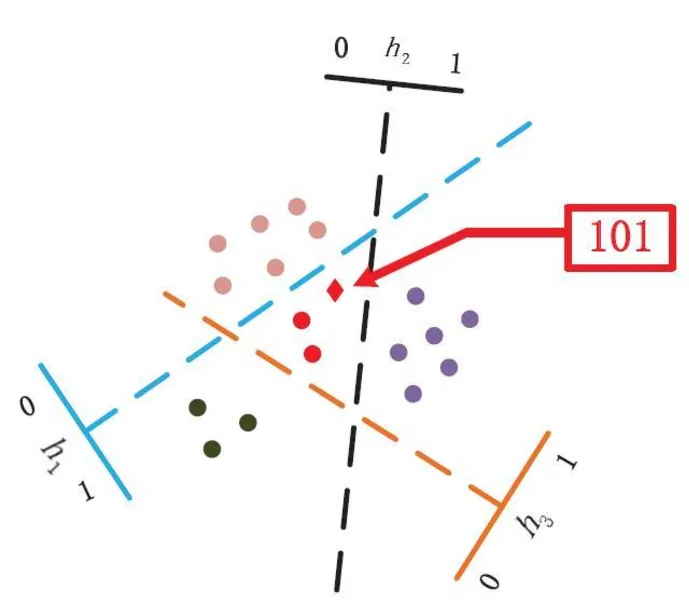

我必须在这里提到K最近邻(KNN)算法。这是预测性维护中最重要的算法之一,也是当今机器学习中使用最广泛、最简单的分类和回归分类器之一。在这种情况下,KNN算法中的k值定义了将检查多少个邻居来确定特定查询点的分类。如果k=1,那么该实例将被分配到与其最近邻居相同的类别中。回归问题使用与分类问题类似的概念,但在这种情况下,会取k个最近邻居的平均值来进行分类预测。KNN的关键词包括多数投票、欧氏距离、曼哈顿距离、明氏距离和汉明距离。

KNN的优点是易于实现、易于适应,且超参数较少。

KNN的缺点是不易扩展、存在维度灾难问题,并且容易过拟合。

注意:虽然KNN是一种监督学习方法,但我们必须提到,其他算法如DBSCAN、OPTICS、SOM、LSH等,在聚类过程后也使用最近邻方法来预测。

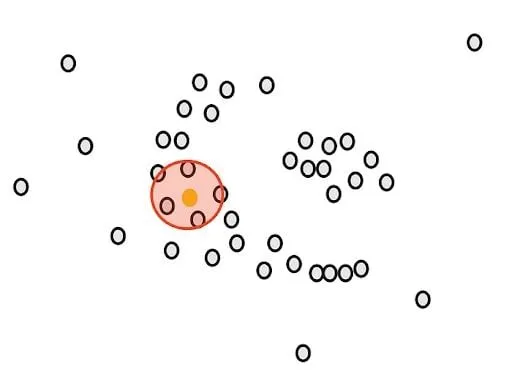

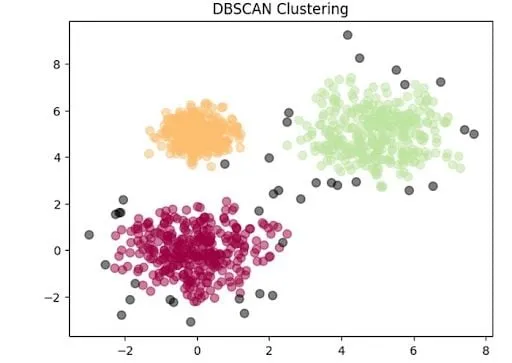

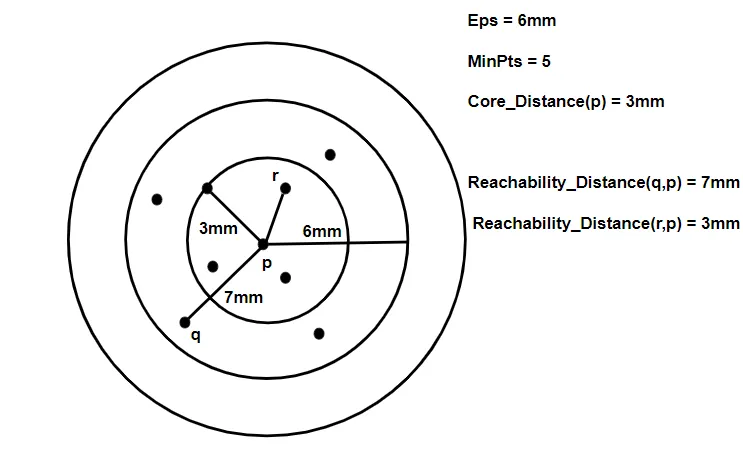

最后一种基本的无监督机器学习算法是基于密度的空间聚类(DBSCAN)。它将聚类定义为数据集中彼此靠近的点较多的区域,而远离任何聚类的点则被视为异常值或噪声。我们的目标是将这些点聚类成密集聚集在一起的组。

圆的半径ε(epsilon)是第一个参数。最小点数m是另一个参数。

DBSCAN的关键词包括核心点、非核心点、边界点和异常值。

DBSCAN是数据清洗和异常值检测的有用工具。

DBSCAN的优点在于其多功能性、对噪声的鲁棒性,以及不需要事先知道最佳聚类数。

DBSCAN的缺点是对超参数的选择敏感,以及在处理密度差异显著的数据集时性能不佳。

更高级的预测性维护算法

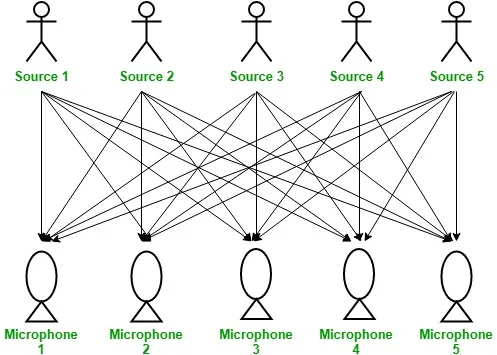

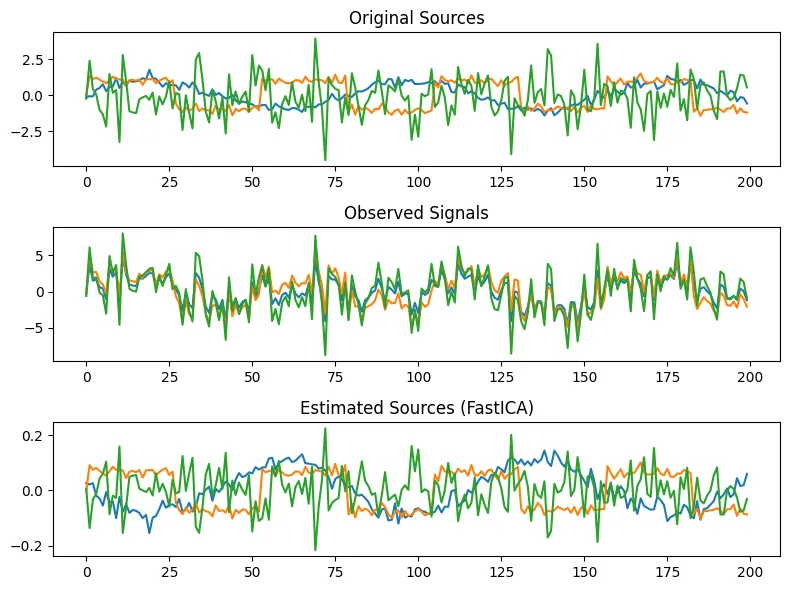

独立成分分析(ICA)是一种在机器学习中使用的统计和计算技术,用于将多元信号分离为其独立的非高斯成分。ICA的关键词是统计独立性和非高斯分布。

ICA的优点包括:它是分离混合信号的有力工具,采用非参数方法,是一种无监督学习技术,对于特征提取非常有用。

ICA的缺点包括:它假设数据是非高斯的,但难以处理非线性混合的数据,计算成本较高,且可能存在收敛问题。

PCA(主成分分析)和ICA(独立成分分析)有什么区别?

PCA侧重于捕捉最大方差并提供不相关的成分,而ICA则专注于提取统计上独立的成分,即使这些成分是相关的。因此,ICA更适合于盲源分离和信号提取任务。

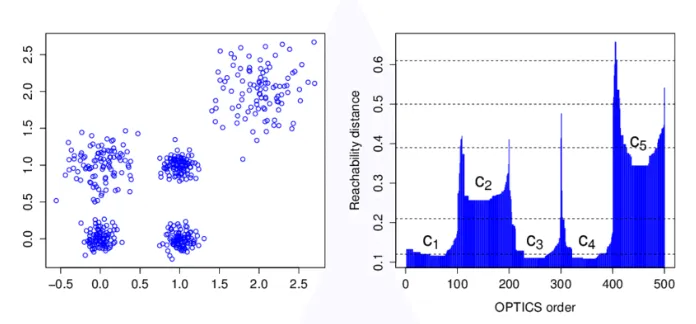

另一种高级算法是排序点以识别聚类结构(OPTICS)。它在DBSCAN聚类的基础上增加了两个更多的概念。它与DBSCAN相似,但可以提取不同密度和形状的聚类。它对于在大规模、高维数据集中识别不同密度的聚类非常有用。OPTICS算法的关键词包括Epsilon、k最近邻、核心距离、可达距离和可达性图。

OPTICS聚类与DBSCAN聚类对比

OPTICS聚类技术相比DBSCAN需要更多的内存,但参数更少。OPTICS在识别不同大小和形状的聚类方面比DBSCAN更有效。DBSCAN明确区分核心点、边界点和噪声点,而OPTICS则不显式地识别噪声点。通常,OPTICS的运行时间复杂度高于DBSCAN。

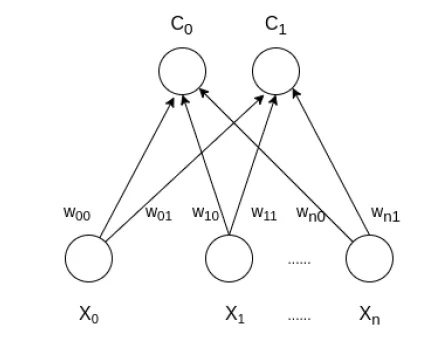

自组织映射(SOM)——Kohonen映射是一种人工神经网络类型,其灵感同样来源于20世纪70年代的神经系统生物学模型。SOM用于聚类和映射(或降维)。SOM包含两层,一层是输入层,另一层是输出层(或称映射层)。

关键词包括欧几里得距离、聚类数C、权重、SOM算法中的学习率α。

局部敏感哈希(LSH)用于近似高维数据点之间的相似性,非常适用于高效地解决最近邻搜索问题。LSH与传统哈希方法的不同之处在于,它的目标是最大化相似项之间的碰撞,而不是最小化碰撞。LSH的关键词包括哈希函数、最近邻、桶和碰撞。

这些算法能够检测异常,并且还能指出哪个特征相对于其他特征产生了更大的偏差。无监督和半监督学习方法为我们提供了强大的工具,以便尽早通知故障。