CLIPS框架引领视觉语言训练新突破,重塑跨模态检索标准

近日,一项由加州圣塔克鲁兹分校(UC Santa Cruz)和爱丁堡大学(University of Edinburgh)的研究人员共同推出的创新视觉语言训练框架——CLIPS,在人工智能领域引起了广泛关注。该框架通过利用合成字幕和新颖的学习方法,成功克服了视觉语言训练中的多项挑战,为跨模态检索任务树立了新的高标准。

网络爬取的图像文本数据集一直是视觉语言模型训练的重要资源,但数据集中存在的噪声和低质量问题,以及图像与文本之间的一致性关联不确定性,限制了模型的能力。为了解决这些问题,研究人员开始探索使用多模态大语言模型(MLLMs)生成的合成字幕来替代原始的网络爬取字幕。然而,当前的方法在处理完整字幕时计算成本高昂,且无法充分利用合成字幕中的全部信息。

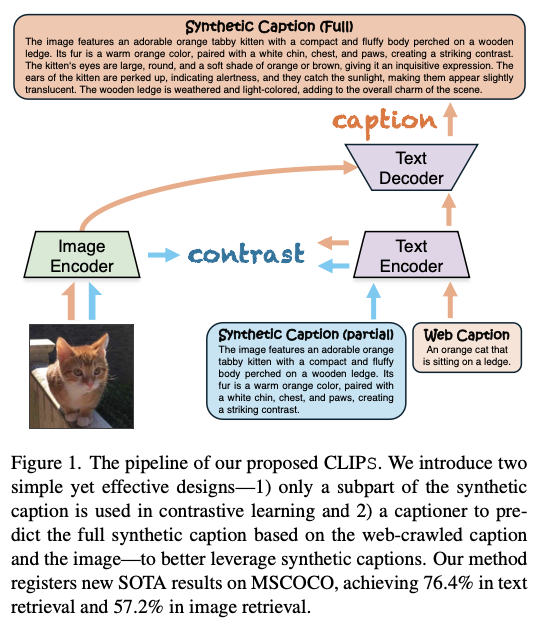

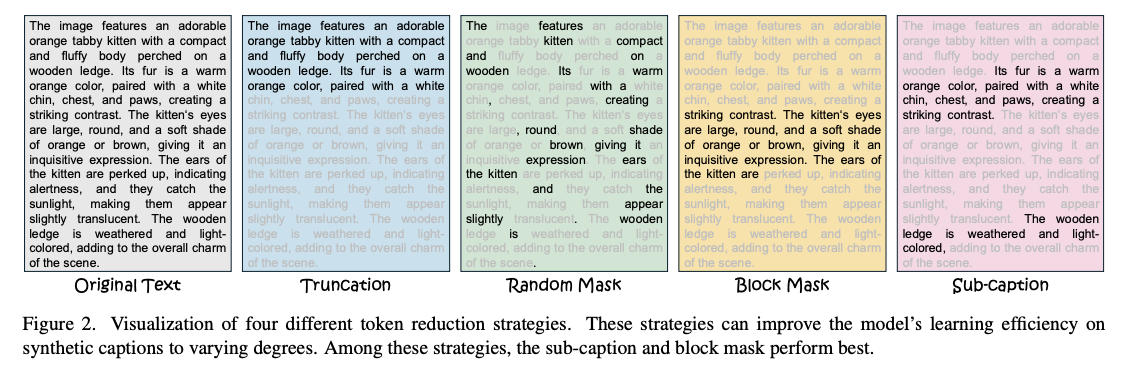

为了克服这些挑战,CLIPS框架应运而生。它采用了局部合成字幕对比学习策略,通过对部分合成字幕进行采样,缩短了输入标记长度,同时提高了性能。这一策略不仅改善了检索准确性,还显著降低了计算成本。此外,CLIPS还引入了自回归字幕生成器,基于网络爬取的字幕及其对应图像生成完整的合成字幕,确保了合成字幕内容的充分利用,丰富了图像与文本之间的语义对齐。

在技术实现上,CLIPS框架采用了子字幕屏蔽策略对合成字幕进行预处理,并结合多正对比损失,实现了原始字幕与缩短字幕的有效对齐。同时,生成框架使用了自回归解码器,通过专门设计的组合掩码进行引导,实现了最佳的标记交互。解码器生成的输出与完整合成字幕对齐,这一训练过程与生成损失函数保持一致。

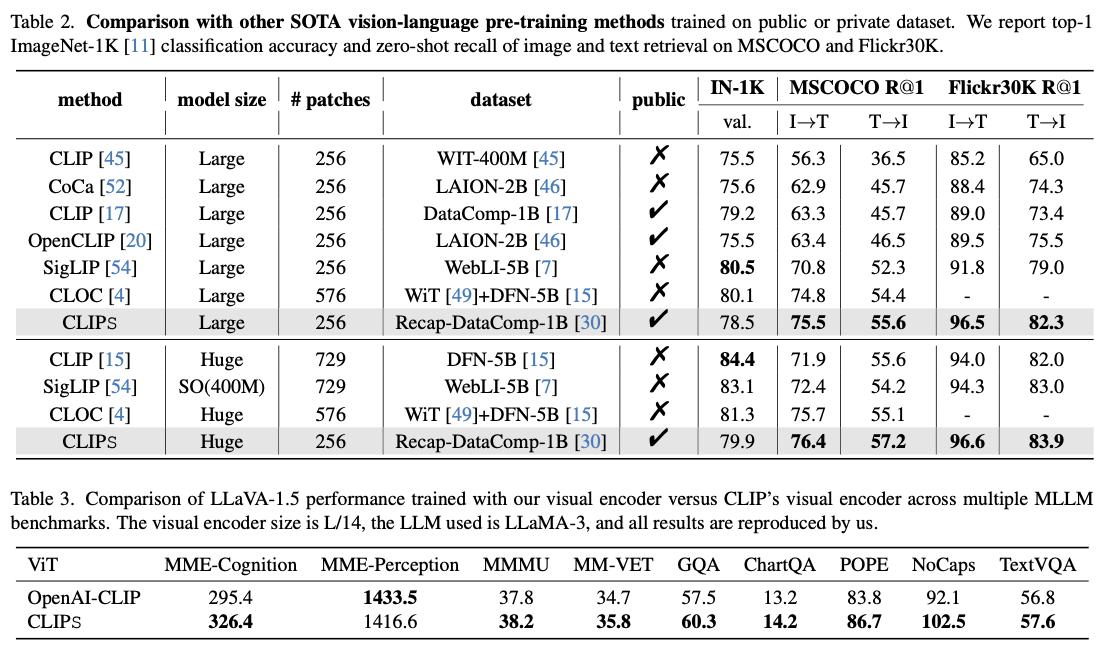

经过在DataComp-1B等大规模数据集上的训练和针对MSCOCO和Flickr30K等基准的评估,CLIPS框架展现出了卓越的性能。在MSCOCO上,CLIPS在文本到图像检索准确性方面提升了超过5%,在图像到文本检索方面提升了超过3%。同样地,在Flickr30K上,该模型在两个方向上的检索准确性均优于竞争框架。此外,CLIPS框架的可扩展性也进一步凸显了其有效性,利用CLIPS训练的较小模型表现甚至优于竞争方法获得的较大模型。

除了检索任务外,CLIPS视觉编码器的整合还显著提高了多模态大语言模型在各种基准下的有效性。这一成果不仅展示了CLIPS框架的灵活性和适应性,还为人工智能领域的多模态应用提供了新的可能性。消融研究也进一步证实了生成建模方法在确保计算效率的同时,在对齐和检索指标方面取得了显著的改进。

CLIPS框架的成功推出,标志着视觉语言训练领域的一次重大突破。它不仅解决了之前尝试所面临的挑战,还通过采用合成字幕和新颖的学习方法,为跨模态检索任务树立了新的高标准。这一框架的推出,无疑是人工智能领域追求多模态应用的重要一步,也将为未来的研究和应用提供新的思路和方向。