LLaVA-CoT:首个具有与GPT-o1类似的分步推理能力的视觉语言模型

当前的视觉语言模型(VLM)在处理复杂的视觉问答任务时,往往难以进行系统和结构化的推理。为了解决这一问题,本文介绍了LLaVA-CoT,它旨在执行自主的多阶段推理。与思维链提示不同,LLaVA-CoT独立地进行概括、视觉解释、逻辑推理和结论生成的顺序阶段。

主要贡献:

- 引入了LLaVA-CoT,这是一种为系统推理而设计的视觉语言模型,在需要结构化思维和推理的任务上表现出色。

- 证明了LLaVA-CoT通过阶段级束搜索在推理时间上是可扩展的。这意味着随着计算资源的增加,我们方法的性能可以进一步提升,使其适用于更复杂的任务和场景。

- 在各种基准测试上的实验表明,我们的方法相对于更大且闭源的模型取得了优越的性能,凸显了LLaVA-CoT在多模态推理中的有效性。

提出的方法

LLaVA-CoT通过逐步的、分阶段的推理过程来增强视觉-语言模型(VLM)的推理能力,并允许有效的推理时间扩展。

i) 通过结构化思维增强推理能力

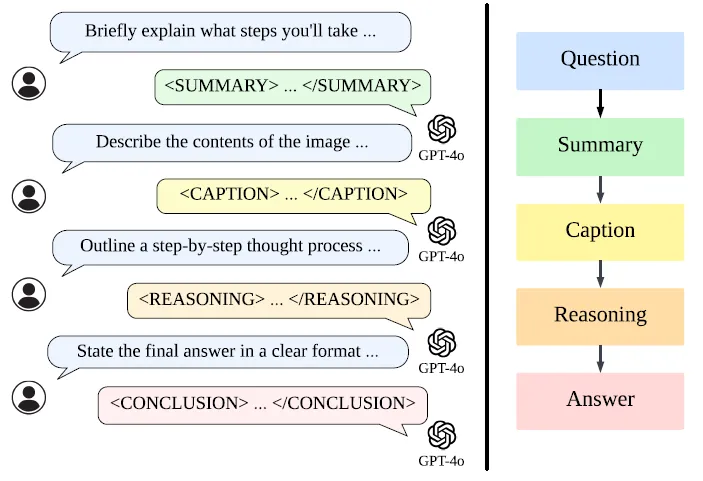

a) 推理阶段

LLaVA-CoT将答案生成过程分解为四个结构化的推理阶段:

- 概括阶段:在这个初始阶段,LLaVA-CoT提供对问题的高层次概括解释,概述它打算解决的主要问题方面。

- 标题阶段:如果存在图像,LLaVA-CoT会提供与问题相关的视觉元素的简洁概述,有助于理解多模态输入。

- 推理阶段:在初始概括的基础上,LLaVA-CoT进行结构化、逻辑化的推理,以得出初步答案。

- 结论阶段:在这个最后阶段,LLaVA-CoT基于前面的推理综合出一个答案。在这里,结论阶段的输出是提供给用户的直接响应,而前三个阶段是内部的“隐藏阶段”,代表LLaVA-CoT的推理过程。

b) 数据准备

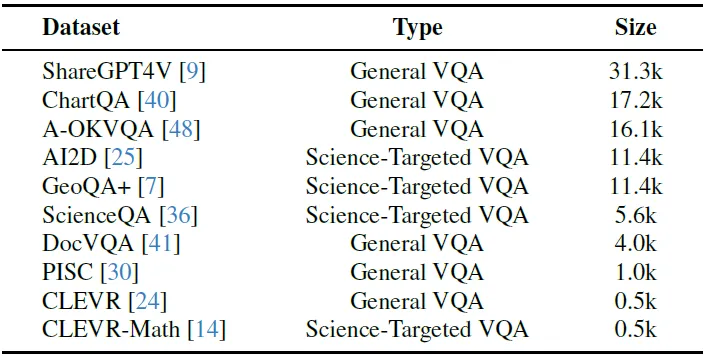

- 编译了一个新的数据集,整合了来自几个广泛使用的视觉问答(VQA)数据集的样本,总共得到99k个图像问答对。

- 下图显示了生成LLaVA-CoT-100k数据集的过程流程,其中作者提示GPT-4o在单独的阶段生成响应,并过滤其输出以确保质量。

同时还包含了来自通用视觉问答(VQA)数据集和科学针对性VQA数据集的数据,具体如下:

(1) 通用VQA数据集

- ShareGPT4V:提供来自GPT-4V交互的多轮问答数据

- ChartQA:专注于图表和图形的解读

- A-OKVQA:强调超出可见内容的外部知识

- DocVQA:涉及需要文本理解的基于文档的问题

- PISC:有助于理解社会关系

- CLEVR [24]:处理对象属性、空间关系和计数任务

(2) 科学针对性VQA数据集

- GeoQA+:用于几何推理,以及针对科学问题的AI2D和ScienceQA

(3) CLEVR-Math

- CLEVR的扩展,专注于视觉情境中的算术分析

下表显示了从每个数据集中选择的问答对数量。

c) 模型训练

- 构建的LLaVA-CoT-100k数据集可用于对任何现有模型进行进一步的监督微调(SFT),以增强其推理能力。

- 在本工作中,作者选择了Llama-3.2–11BVision-Instruct模型作为基础模型,并使用LLaVA-CoT-100k数据集进行了全参数微调。

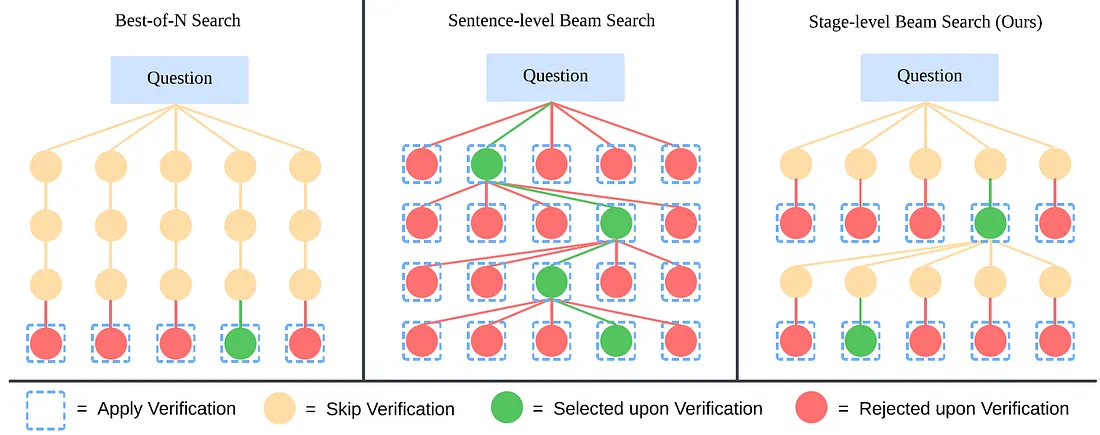

ii) 使用阶段级束搜索实现有效的推理时间扩展

利用LLaVA-CoT的基于阶段的输出,这为推理时间扩展提供了理想的粒度。我们的方法遵循以下步骤:

- 为解决方案的第一阶段采样N个响应。

- 随机采样2个响应,并让模型判断哪个更好,保留更好的响应。

- 重复N-1次,保留最佳响应。

- 为下一个阶段采样N个响应,然后重复步骤2-4,直到所有阶段都处理完毕。

正是LLaVA-CoT的结构化输出设计使得这种方法成为可能,使得在每个阶段都能进行高效且准确的验证。

下图展示了这三种方法的示意图:

- 最佳 N 搜索生成 N 个完整响应并从中选择最佳响应

- 句子级 Beam Search 为每个句子生成多个候选选项,并选择最佳选项。相比之下,我们的 Stagelevel

- Beam Search 为每个推理阶段(例如摘要、标题、推理和结论)生成候选,并在每个阶段选择最佳选项。

- Best-of-N 搜索操作比较粗略,而 Sentence-level Beam Search 则过于细粒度,我们的方法达到了最佳平衡,取得了最好的性能。

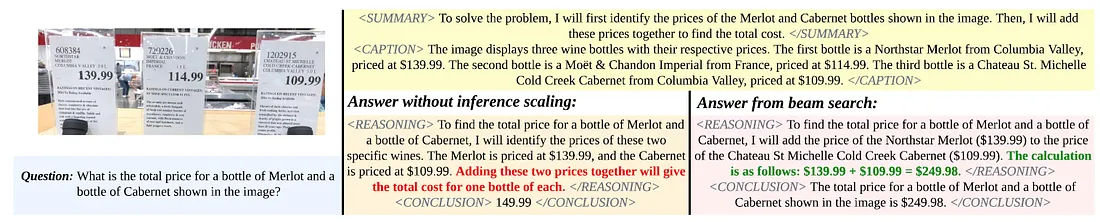

下图展示了使用阶段级束搜索与不使用阶段级束搜索时LLaVA-CoT性能的比较。我们的阶段级束搜索在模型推理过程中有效地选择了更好的推理路径。

训练后性能

i) 基准测试结果

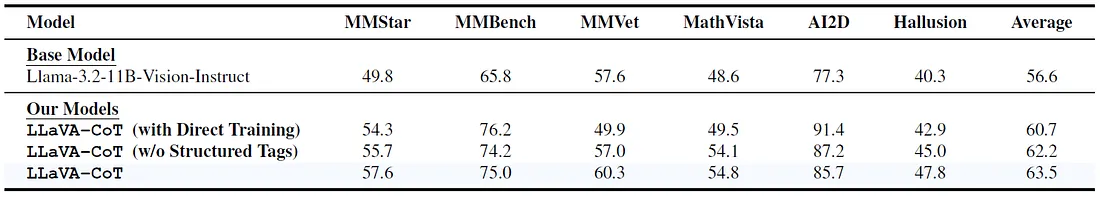

下表展示了不同模型在基准测试上的实验结果。在此,LLaVA-CoT(直接训练)指的是直接在原始VQA数据集的Q&A对上训练的模型,而LLaVA-CoT(无结构化标签)则表示在移除了结构化标签的LLaVA-CoT-100k数据集上训练的模型。LLaVA-CoT则指的是在完整的LLaVA-CoT-100k数据集(包括结构化标签)上训练的模型。

结果显示,LLaVA-CoT在通用VQA、数学推理、科学VQA和幻觉控制任务方面均取得了显著进步,平均基准分数提高了6.9%,从而验证了我们方法的有效性。

推理时间扩展

i) 基准测试结果

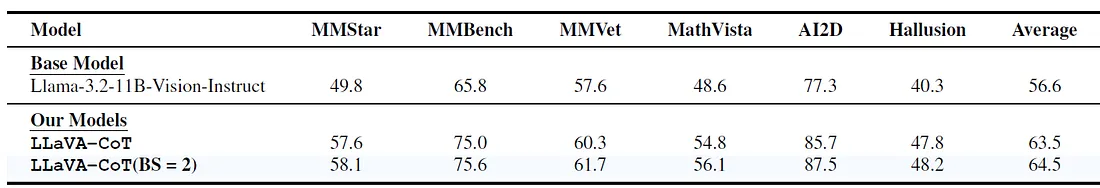

下表展示了推理时间期间的实验结果。LLaVA-CoT(BS=2)表示使用阶段级束搜索且束大小为2的模型。结果表明,阶段级束搜索可以进一步显著提升性能。

结果显示,LLaVA-CoT在通用VQA、数学推理、科学VQA和幻觉控制任务方面均取得了显著进步,平均基准分数提高了6.9%,从而验证了我们方法的有效性。

ii)与基线方法的比较

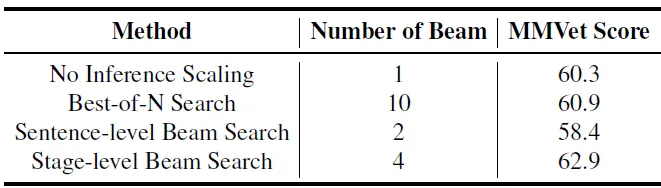

下表显示与基线方法的比较

提出的阶段级束搜索在可比的推理时间计算下优于最佳N选一和句子级束搜索

iii) 阶段级束搜索的扩展趋势

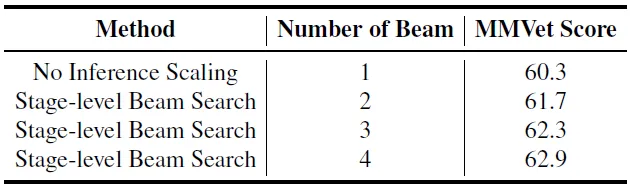

下表展示了LLaVA-CoT的扩展趋势。

随着候选响应数量的增加,模型的性能持续提高。

与最先进的视觉语言模型(VLM)的比较

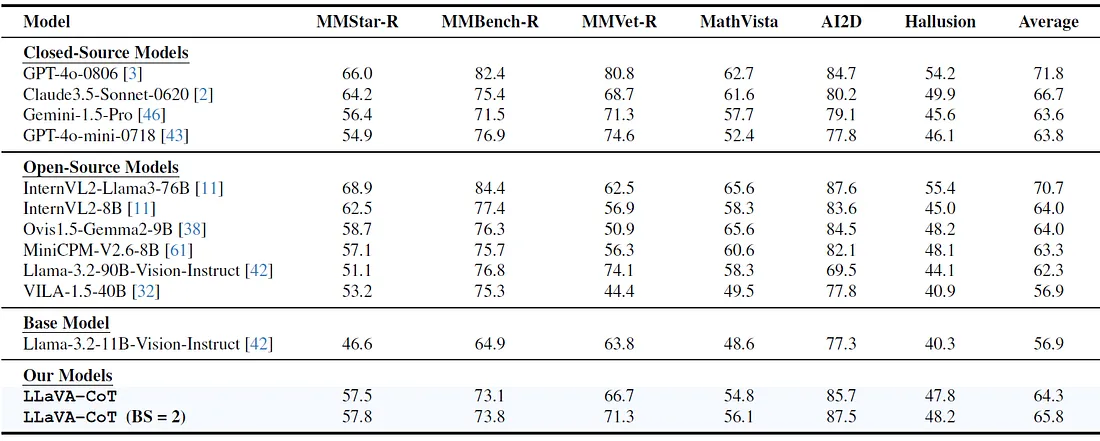

下表将LLaVA-CoT与其他最先进的开源和闭源视觉语言模型在六个需要高级推理能力的基准测试上进行了比较。

结果表明,LLaVA-CoT始终优于许多规模相似甚至更大的开源模型,如InternVL2–8B、Ovis1.5-Gemma2-9B、MiniCPM-V2.6–8B、Llama-3.2–90B-Vision-Instruct和VILA-1.5–40B。

值得注意的是,LLaVA-CoT甚至超越了某些闭源模型,如GPT-4o-mini和Gemini-1.5-pro,这凸显了我们结构化推理方法的有效性。

结论

我们提出了LLaVA-CoT,这是一种新颖的视觉语言模型,能够在多个阶段进行结构化、自主推理。

创建了带有详细推理注释的LLaVA-CoT-100k数据集,该数据集支持对系统化、结构化的响应进行训练;提出了一种阶段级束搜索方法,实现了有效的推理时间扩展。

总体而言,LLaVA-CoT为视觉语言模型中的多模态推理树立了新标准,提供了稳健的性能和可扩展性,尤其是在推理时间方面。