Meta AI推出COCONUT:突破语言限制,设定机器推理新标准

基于大规模语言模型(LLMs)的推理方法,通过遵循结构化途径,模拟逻辑与问题解决能力。然而,当前方法主要局限于语言空间内运作,其中推理过程通过明确的文本链来表达。尽管这种方式在清晰度方面颇具成效,但它也带来了低效性,因为自然语言本质上是为交流而非推理而优化的。神经科学研究进一步支持了这一观点,揭示出推理过程往往绕过了人脑中的语言网络。这些发现凸显了开发能突破语言限制、为LLMs提供可行替代推理框架的潜力。

基于语言的推理方法在计算效率上存在局限。当LLMs处理推理链时,多数记号都贡献于流畅性,而非实际推理,这导致了计算资源的浪费。另一方面,关键的推理步骤需要精确的规划与决策,而现有架构难以有效应对。这些低效性在推理任务变得复杂或需同时探索多种解决方案时尤为明显。此外,基于语言的模型往往过早地锁定了单一确定性路径,限制了其回溯或考虑其他解决方案的能力,从而影响了它们在解决动态或探索性问题上的效力。

思维链(CoT)推理方法作为解决这些低效性的一种途径,已经引起了广泛关注。通过引导LLMs在语言中逐步生成中间解决方案,CoT增强了问题解决的清晰度和准确性。然而,它仍受自然语言限制,对于需要复杂规划或探索的任务效果不佳。近期创新尝试结合潜在推理,即允许模型进行非语言计算的方法。尽管已取得一定进展,但潜在推理方法仍需更强的可扩展性和稳健性,才能在各种任务中超越传统的基于语言的方法。

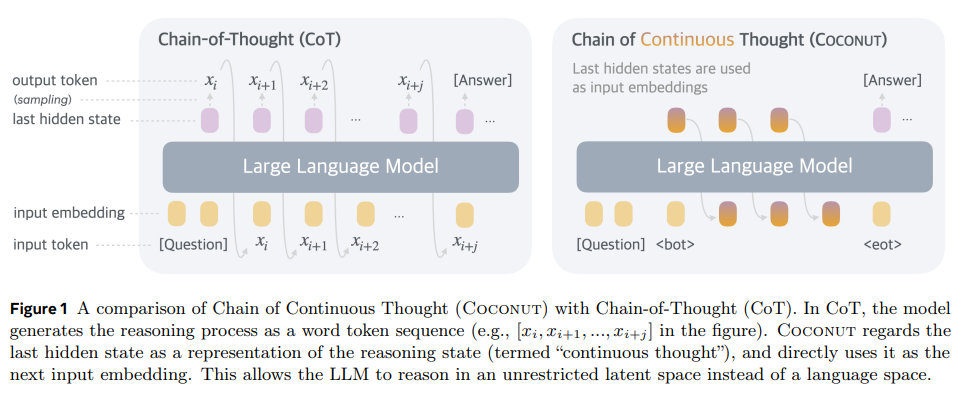

为了应对这些挑战,Meta的FAIR和UC San Diego的研究人员提出了COCONUT(连续思维链)。COCONUT引入了一种新范例,使LLMs能在无限制的潜在空间中进行推理,从而绕过了语言的束缚。与传统的CoT将推理状态编码为词记号不同,COCONUT利用LLM的最后隐藏状态作为推理状态的连续表示。这种表示被称为“连续思维”,可直接输入模型进行进一步处理,而无需解码为语言。通过这种方式,COCONUT使模型能够高效地处理推理步骤,同时保留了探索多个解决路径的能力。

COCONUT采用多阶段训练过程来优化其潜在推理能力。在训练过程中,模型在语言和潜在模式之间交替,逐渐用潜在表示替代基于语言的推理步骤。例如,在最终训练阶段,COCONUT用连续思维替换了所有推理链,使模型能够完全在潜在空间中解决问题。这种方法类似于广度优先搜索(BFS),模型在缩小到最有希望的解决方案之前,会同时评估多个推理路径。这种灵活性使COCONUT能够解决需要大量规划和决策的复杂任务。

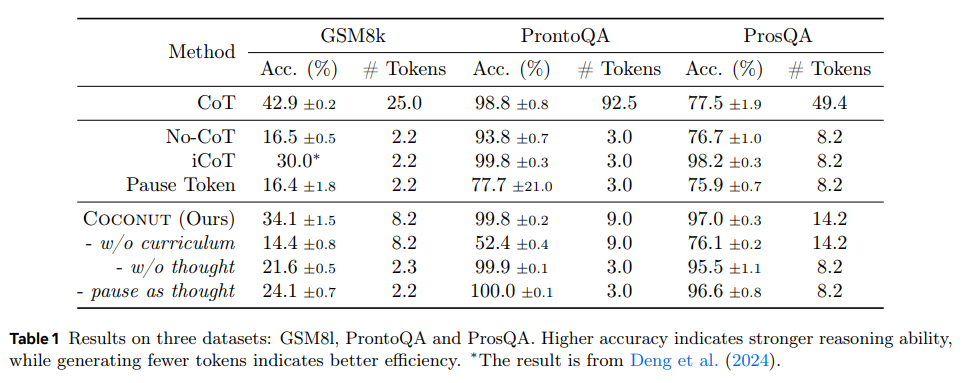

为了验证COCONUT的有效性,研究人员对其进行了三个数据集的实验:

- GSM8k数据集,用于数学推理;

- ProntoQA数据集,用于逻辑推理;

- ProsQA数据集,是一个需要对图结构进行高级规划的新数据集。

结果显示,COCONUT在准确性和效率方面都优于传统的CoT方法。在逻辑推理任务上,COCONUT的准确性高达99.9%,超过了CoT的98.8%,同时在推理过程中生成了更少的推理记号。在ProsQA数据集上,COCONUT在需要大量规划的任务中表现出显著优势,超越了CoT,并在使用更少计算资源的情况下获得了更高的准确性。

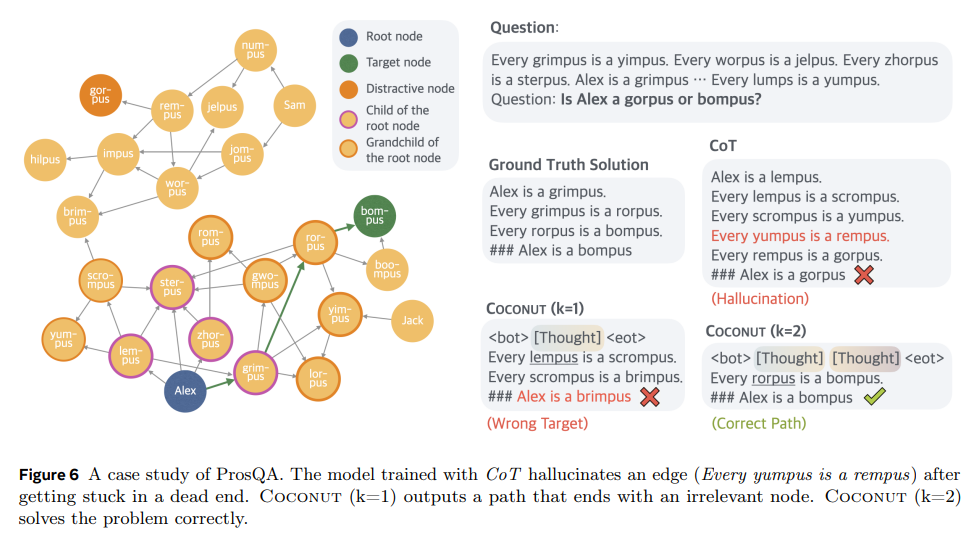

COCONUT的最大亮点在于其能够同时编码多个推理路径。通过将推理状态处理为连续思维,模型避免了过早地对特定解决方案产生偏见。相反,它保持了潜在的下一步行动分布,并逐步消除错误路径。这种方法在开放领域推理任务中,如GSM8k,表现出特别的效果,COCONUT的准确性达到了42.9%,而CoT为42.0%。在潜在空间内探索和回溯的灵活性赋予了COCONUT出色的规划能力,使其适用于涉及不确定性或多个解决路径的任务。

关于COCONUT研究的主要要点如下:

- · COCONUT在逻辑推理任务(ProntoQA)上实现了99.9%的准确性,在数学推理任务(GSM8k)上达到了42.9%的准确性,均优于传统方法。

- · 在推理过程中,模型减少了推理记号的生成数量,展现了计算效率。

- · COCONUT的潜在空间推理模拟了BFS,使模型能够探索多个解决方案,并适应复杂任务。

- · 多阶段的训练过程使COCONUT能够应对更具挑战性的问题,同时保持高性能。

- · COCONUT在各种推理任务中表现出色,涵盖了从开放领域的数学问题到具有图形结构的逻辑推理。

总之,通过引入连续的潜在思维,COCONUT克服了基于语言方法的低效性,并提升了计算效率。其编码和探索多个推理路径的能力使其成为解决复杂问题的理想选择。因此,COCONUT在逻辑推理和高效记号利用方面为机器推理树立了新的标杆。