使用未来预测层增强Transformer模型:一种新的语言建模方法

近年来,基于Transformer的模型彻底改变了自然语言处理领域。例如,GPT-2就是语言生成任务中最广泛使用的模型之一。GPT-2由OpenAI开发,基于Transformer架构,擅长生成上下文相关且连贯的文本。然而,这些模型的能力和性能总有改进和扩展的空间。其中一个机会就是增加一个未来预测层(Future Prediction Layer),该层利用模型所有层的隐藏状态来改进文本生成和预测能力。由于其紧凑的架构和较小的文件大小,我将使用GPT-2进行研究。

在本文中,我们将探索如何通过引入这个额外的层FutureTransformerEncoder来提高GPT-2预测未来单词或序列的能力,从而增强其输出和性能。我们还将讨论从模型的所有层中提取隐藏状态的过程,以及这种技术如何有助于做出更明智和准确的预测。

理解Transformer模型中的隐藏状态

在我们深入探讨修改之前,了解隐藏状态是什么以及它们在基于Transformer的模型(如GPT-2)中的价值至关重要。

在Transformer模型中,每一层都会处理输入序列,生成称为隐藏状态的中间表示。这些隐藏状态捕捉了输入及其上下文在不同抽象层次上的信息,从较早层中的简单标记级关系到较深层中的更复杂语义结构。GPT-2作为一个深度Transformer网络,在其每一层都会产生一个隐藏状态。

到模型处理结束时,最终层的隐藏状态包含了最具上下文信息的表示,用于生成序列中的下一个标记。然而,这个最终隐藏状态并没有利用早期层捕捉到的更丰富信息。我们方法的创新之处在于使用来自所有层的隐藏状态,并将它们传递到一个新的未来预测层中,从而提高模型更准确地预测下一个标记的能力。

引入未来预测层

未来预测层是一种创新的修改,旨在增强基于Transformer的模型(如GPT-2)的预测能力。这一层的工作原理是利用GPT-2模型所有层生成的隐藏状态,而不是仅依赖最终的隐藏状态。通过整合来自多个层的信息,未来预测层帮助模型做出更明智和准确的预测,从而最终改进文本生成和序列预测任务。

未来预测层的工作原理

从每一层提取隐藏状态

在传统的像GPT-2这样的Transformer架构中,模型通过多层处理输入序列。这些层中的每一层都会生成隐藏状态(也称为激活或中间表示),它们捕捉了输入序列的不同层次的信息。这些隐藏状态是输入的表示,但抽象程度取决于它们来自哪一层。

- Transformer模型的较早层往往更关注局部的标记关系(如语法或句法),捕捉输入序列中标记之间更细粒度的交互。

- 而较深层则捕捉更抽象、语义上的关系(如意义、上下文、话语结构)。

在典型的基于Transformer的模型中,只有最终层的隐藏状态被用来预测序列中的下一个标记。这是因为最终隐藏状态被认为包含了最具上下文信息的表示。然而,这种方法忽略了早期层中可能存在的丰富上下文信息。来自所有层的隐藏状态提供了对输入序列更丰富、更细致的理解,因为每一层都在其表示输入的基础上构建于前一层之上。

在我们的方法中,我们从GPT-2的所有层中提取隐藏状态,而不仅仅是最后一层。这样,我们就能利用每一层的上下文知识来改进预测。例如:

- 第1层可能关注句法细节,如语法和词级交互。

- 第6层可能开始捕捉句子结构和词语之间的长距离依赖关系。

- 第12层可能封装了关于句子整体意义的更抽象知识,包括句子本身的上下文之外的内容。

通过使用所有这些隐藏状态,我们能够捕捉到输入序列的全面视图,从而使模型能够做出更好的预测。

将隐藏状态传入Transformer编码器

一旦我们从每一层中提取了隐藏状态,我们就将它们传入FutureTransformerEncoder,这是一个为此目的特别设计的自定义层。FutureTransformerEncoder本质上是另一个Transformer编码器,它处理隐藏状态的序列,从中学习,并预测未来的词或序列。

为什么选择编码器?

Transformer编码器非常适合这项任务,因为它被设计为处理序列并构建复杂、上下文敏感的表示。它使用自注意力机制来捕捉数据中的长距离依赖关系,使其能够专注于输入序列中最相关的部分,无论这些词相距多远。

它是如何工作的?

FutureTransformerEncoder接收来自GPT-2的提取隐藏状态,并应用其自身的自注意力机制。它学会了根据上下文和当前任务,对不同层的输入表示进行优先排序。例如,它可能会为句法信息赋予较早层更多的权重,而为语义理解赋予较深层更多的权重。

在处理完隐藏状态后,FutureTransformerEncoder基于这种丰富的上下文生成未来预测。这些预测本质上是模型关于下一个词或词序列的有根据的猜测,考虑了来自所有层的综合见解。

改进预测

这种方法的核心好处之一是,我们不再仅依赖最终层的隐藏状态。通过整合模型所有层的信息,FutureTransformerEncoder使模型能够从更全面的特征集中学习。

- 更丰富的上下文:较深层的隐藏状态更擅长捕捉文本中复杂的高层次关系,而较浅层的隐藏状态则更擅长捕捉更局部的依赖关系。通过同时使用这两者,模型可以做出既反映细粒度细节又反映更广泛上下文的预测。

- 捕捉细微模式:每一层在理解输入时都有其不同的优势。一些层可能对句法(如逗号的放置或短语的结构)更敏感,而其他层则更擅长理解长距离依赖或抽象意义。通过聚合来自所有这些层的信息,FuturePredictionLayer能够捕捉到更广泛的模式,从而提高其生成文本或预测未来词的准确性。

- 更稳健的预测:FutureTransformerEncoder能够将这种丰富信息以增强模型预测稳健性的方式结合起来。例如,如果一层捕捉到了文本中可能的歧义,另一层可能会根据更广泛的上下文帮助消除这种歧义,从而更准确地预测下一个词。

总之

未来预测层通过利用Transformer模型所有层的隐藏状态,增强了GPT-2预测未来词的能力。该过程如下:

- 从GPT-2的所有层中提取隐藏状态,从而在多个抽象层次上捕捉输入序列的全面表示。

- 这些隐藏状态被传入一个Transformer编码器(即FutureTransformerEncoder),该编码器对它们进行处理以做出更明智的预测。

- 通过利用来自多层的隐藏状态,模型可以从更广泛的模式和上下文中学习,从而产生更准确和稳健的预测。

这种方法确保了模型在进行预测时能够访问更丰富的上下文,最终提高了其在生成连贯、上下文相关和准确文本方面的性能。

代码实现

以下是展示我们如何实现带有额外未来预测层的GPT-2模型的Python代码。该层捕获所有层的隐藏状态,并基于这种更丰富的上下文进行预测。

from transformers import GPT2Tokenizer, GPT2LMHeadModel

import torch

import torch.nn as nn

tokenizer = GPT2Tokenizer.from_pretrained("gpt2")

model = GPT2LMHeadModel.from_pretrained("gpt2")

class FutureTransformerEncoder(nn.Module):

def __init__(self, embed_dim, num_heads, num_layers):

super(FutureTransformerEncoder, self).__init__()

self.encoder_layer = nn.TransformerEncoderLayer(d_model=embed_dim, nhead=num_heads)

self.transformer_encoder = nn.TransformerEncoder(self.encoder_layer, num_layers=num_layers)

self.fc_out = nn.Linear(embed_dim, embed_dim)

def forward(self, x):

transformer_output = self.transformer_encoder(x)

future_predictions = self.fc_out(transformer_output)

return future_predictions, transformer_output

class GPT2WithFuture(nn.Module):

def __init__(self, model, embed_dim, num_heads, num_layers):

super(GPT2WithFuture, self).__init__()

self.gpt2_model = model

self.future_predictor = FutureTransformerEncoder(embed_dim, num_heads, num_layers)

def forward(self, input_ids, labels=None):

gpt2_outputs = self.gpt2_model(input_ids=input_ids, labels=labels, output_hidden_states=True)

current_features = gpt2_outputs.hidden_states[-1]

future_features, transformer_output = self.future_predictor(current_features)

if labels is not None:

loss = gpt2_outputs[0]

return future_features, loss, transformer_output

else:

return future_features, transformer_output

embed_dim = 768

num_heads = 12

num_layers = 12

gpt2_with_future_model = GPT2WithFuture(model, embed_dim=embed_dim, num_heads=num_heads, num_layers=num_layers)

input_text = "What is the capital of France?"

input_ids = tokenizer(input_text, return_tensors="pt").input_ids

future_features, loss, transformer_output = gpt2_with_future_model(input_ids)

generated_output = model.generate(input_ids=input_ids, max_length=50, num_beams=5, no_repeat_ngram_size=2, top_k=50, top_p=0.95)

decoded_output = tokenizer.decode(generated_output[0], skip_special_tokens=True)

print("Generated Text:", decoded_output)

print("\nFuture Features Output Shape:", future_features.shape)

print("Transformer Output Shape:", transformer_output.shape)

代码工作原理

GPT-2模型加载:

- 使用GPT2LMHeadModel.from_pretrained("gpt2")方法加载GPT-2模型,并同时加载相应的分词器。

未来Transformer编码器:

- 这个自定义层处理来自GPT-2所有层的隐藏状态,并对未来状态进行预测。它帮助模型从多个抽象层次中学习,从而提高整体预测质量。

带有未来预测的GPT-2:

- 在GPT2WithFuture类中,我们将FutureTransformerEncoder与GPT-2模型集成。这个类将现有的GPT-2架构与添加的未来预测机制相结合,使我们能够捕获更丰富的上下文并改进预测。

性能评估和基准测试

为了评估添加未来预测层的影响,我们需要根据基准来评估模型的性能。我使用了困惑度技术进行评估。以下是困惑度的定义:

困惑度是评估语言模型,特别是在自然语言处理(NLP)中常用的一个指标。它衡量语言模型预测样本的好坏。较低的困惑度表明模型做出的预测更好,而较高的困惑度则表明性能较差。

简单来说,困惑度可以被视为模型在预测序列中下一个词时的不确定性或惊讶程度的度量。其工作原理如下:

- 困惑度与概率:困惑度与模型中预测词汇的似然度密切相关。如果模型为正确的下一个词分配了高概率,那么困惑度就会低。如果分配的概率低,困惑度就会高。

- 数学定义:从数学上讲,困惑度是预测词汇平均负对数似然度的指数。困惑度的公式为:困惑度= 2^Cross-Entropy Loss

- 解释:较低的困惑度意味着模型对其预测更有信心,并且更好地建模了文本的底层分布。较高的困惑度表明预测中存在更多的混淆或不确定性,这意味着模型的表现不佳。

总结来说,较低的困惑度意味着更好的性能,因为模型的预测更准确且更有信心。

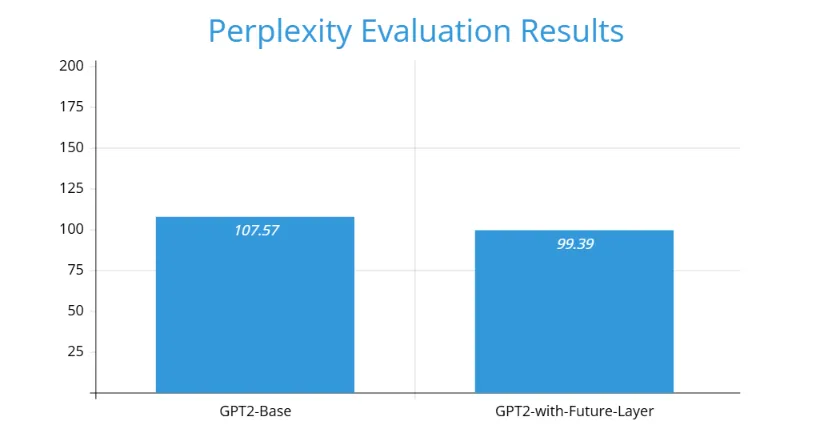

基准测试是在wikitext数据集的wikitext-2-raw-v1测试部分的一个样本数据上进行的。以下是结果:

从图表中我们可以看出,带有未来预测层的GPT2(GPT2-with-Future-Layer)具有更好的基准测试结果。

结论

通过利用GPT-2所有层的隐藏状态,我们可以构建一个更加强大的语言模型。未来预测层不仅考虑最后一层的上下文,还考虑来自各层的所有可用上下文,从而使模型更加稳健。这带来了更加明智的预测,进而产生更加连贯和准确的文本生成。