LLMs推理策略新突破:小模型在受限计算预算下超越大模型

近日,清华大学交叉信息研究院与卡内基梅隆大学计算机科学学院的研究人员,在大型语言模型(LLMs)的推理策略方面取得了重要突破。他们通过深入研究推理缩放规律和计算最优推理策略,发现小模型在受限的计算预算下,通过运用复杂的推理技术,能够超越大模型的表现。

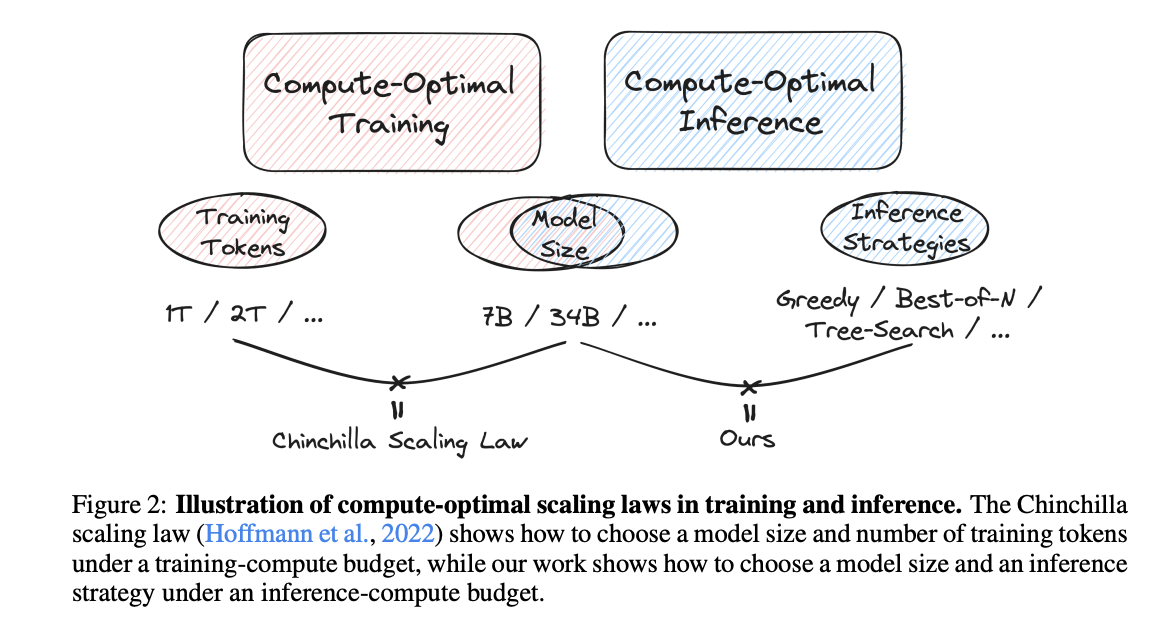

这项研究挑战了关于模型缩放和计算效率的传统认知。在过去,随着模型规模的扩大,计算资源对模型性能的影响逐渐凸显,成为制约LLMs进一步发展的关键因素。然而,研究人员通过全面研究各种推理方法,包括贪婪搜索、多数投票、best-of-n、加权投票以及两种不同的树搜索算法等,发现计算最优推理策略能够在一定程度上弥补模型规模上的不足。

实验选择了MATH和GSM8K两个数学数据集,采用了多个策略模型,包括Pythia模型、数学专用Llemma模型和Mistral-7B等,以探索不同模型规模和架构之间的性能差异。结果显示,Llemma-7B在竞争性准确性方面与Llemma-34B相当,但所需的计算资源却减少了约50%。这一发现表明,在合适的推理策略配合下,较小的模型能够在有限的计算预算内提供更具成本效益的性能。

此外,研究还揭示了一种名为REBASE的新颖树搜索方法,该方法在各种设置下均表现出Pareto最优性,并优于基于采样的方法和传统的蒙特卡洛树搜索算法。REBASE在更低的计算预算下实现了更高的准确性,这一新发现进一步挑战了关于推理策略中计算复杂性的先前认知。

研究人员表示,这项研究为LLMs的计算最优推理策略提供了重要见解,并得出了三个基本结论:首先,在受限的计算预算内,通过运用复杂的推理技术,较小的模型能够超越较大的模型;其次,基于采样的多数投票策略存在基本局限性;第三,REBASE树搜索方法已成为一种突破性的推理策略,超越了现有方法。

尽管这项研究取得了重要进展,但研究人员也指出了其局限性,即关注点仅限于数学问题求解。他们表示,未来将继续探索不同任务领域中的推理缩放规律,以期在更多领域实现LLMs的性能提升和计算效率优化。

这项研究成果不仅为LLMs的推理策略提供了新的思路和方法,也为推动人工智能技术的进一步发展奠定了坚实基础。